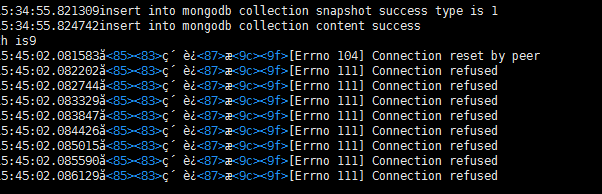

在使用爬虫抓取 网站的时候,启动了多个进程,运行一段时间后有的进程会无缘无故的停止,,,,还经常会出现超时,,,,还有一个连接被拒绝的错误,,,请教大神这些问题产生的原因有哪些,,,怎么解决的.。。。。

附连接拒绝的错误

python+scrapy+selenium爬虫超时和连接被拒绝问题

- 写回答

- 好问题 0 提建议

- 追加酬金

- 关注问题

- 邀请回答

-

4条回答 默认 最新

oyljerry 2017-03-23 04:42关注

oyljerry 2017-03-23 04:42关注一个是爬虫的个数,可能被服务器判断出在扒取数据了,还有就是同一个IP访问过多,

所以拒绝你的连接。一个是降低扒取的频率,还有就是增加proxy代理,通过不同的IP爬取网站

解决 无用评论 打赏 举报

悬赏问题

- ¥15 ads仿真结果在圆图上是怎么读数的

- ¥20 Cotex M3的调试和程序执行方式是什么样的?

- ¥20 java项目连接sqlserver时报ssl相关错误

- ¥15 一道python难题3

- ¥15 用matlab 设计一个不动点迭代法求解非线性方程组的代码

- ¥15 牛顿斯科特系数表表示

- ¥15 arduino 步进电机

- ¥20 程序进入HardFault_Handler

- ¥15 oracle集群安装出bug

- ¥15 关于#python#的问题:自动化测试