在用seurat跑单细胞分析的时候,感觉因为数据集太大一直出现奇奇怪怪的报错

做标准化分析的时候出现的报错

我的代码

Hs <- ScaleData(Hs,features = all.genes)

我报过的错们

Centering and scaling data matrix

|============================================= | 62%Error in (function (mat, scale = TRUE, center = TRUE, scale_max = 10, :

std::bad_alloc

Centering and scaling data matrix

|=========================================================================| 100%

Error: cannot allocate vector of size 10.5 Gb

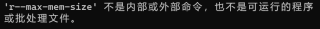

本来不是很懂,但是刚刚好不容易跑出上面100%的错,感觉就是因为内存问题没错了,但是上网搜索了一下,大家说的修改内存用的memory.limit()已经停用了。而且在cmd上增加参数我试了一下也不可以,效果如图

请大家帮忙看一下如何解决这个问题!万分感谢!