FFmpeg编译时的参数:./configure --enable-shared --enable-static --enable-pic --enable-gpl --enable-avresample --enable-sdl --enable-libx264

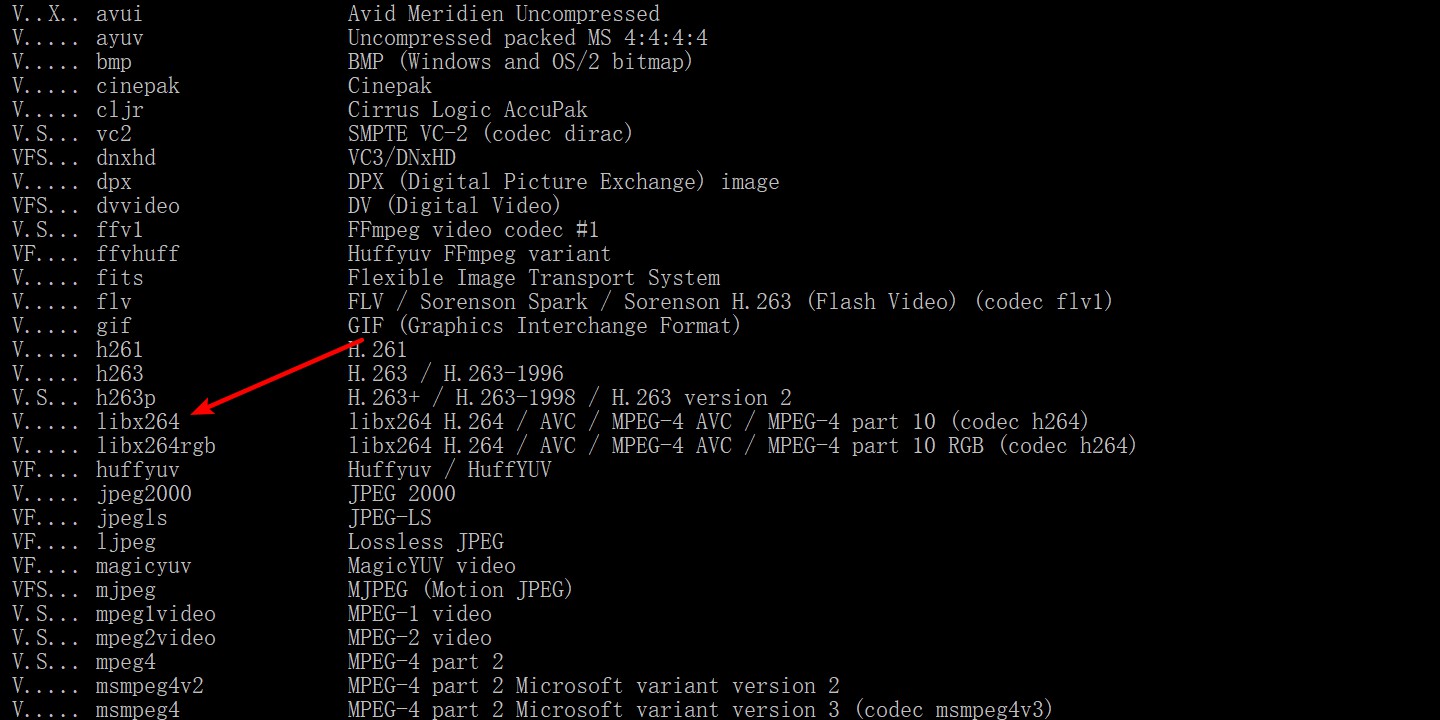

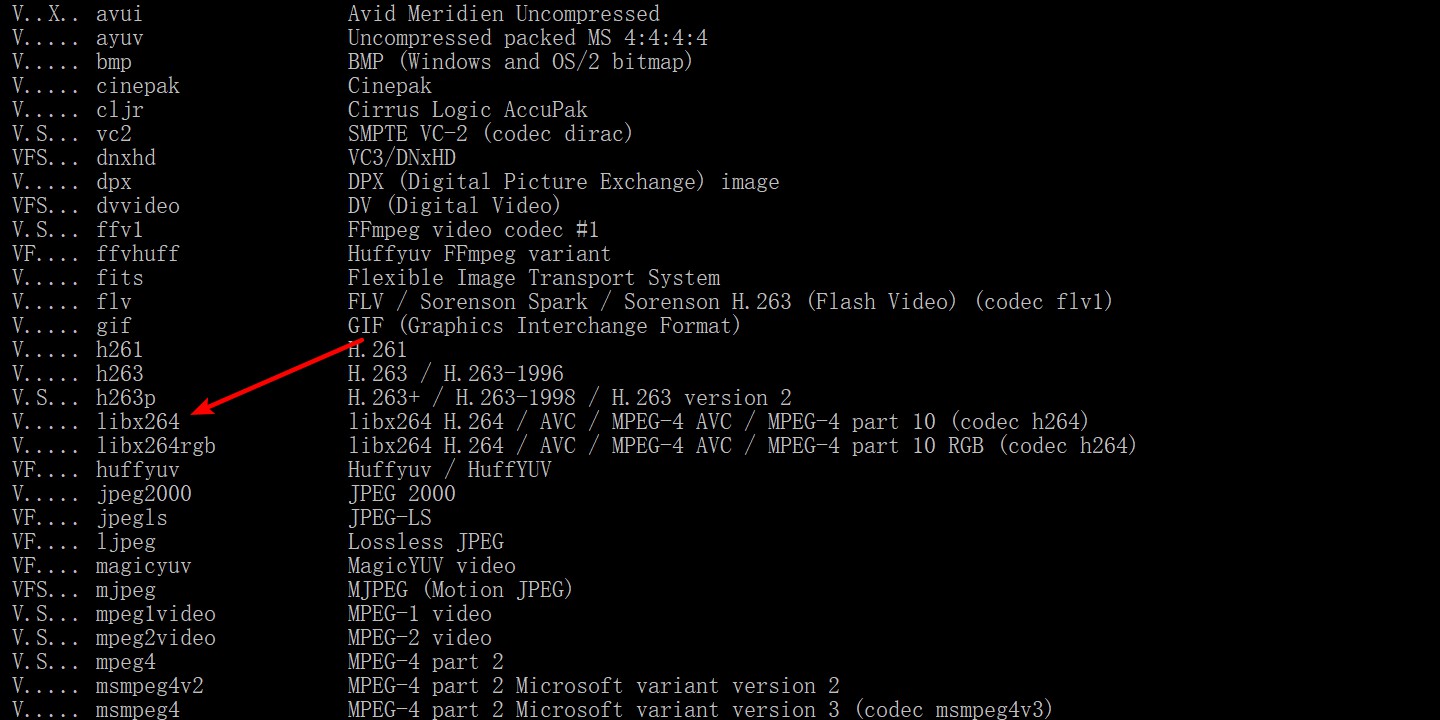

cmd中使用ffmpeg -encoders

新线索:

在win7、vs2015中此函数不为空,在win10、vs2017中为空;

在win10、vs2017中的debug模式下,此函数返回空,release模式下不为空;

FFmpeg编译时的参数:./configure --enable-shared --enable-static --enable-pic --enable-gpl --enable-avresample --enable-sdl --enable-libx264

cmd中使用ffmpeg -encoders

新线索:

在win7、vs2015中此函数不为空,在win10、vs2017中为空;

在win10、vs2017中的debug模式下,此函数返回空,release模式下不为空;

检查下在ffmpeg的lib目录下,有没有libx264的dll/so文件。