如下,如何把df['key1'] 分组出来的索引对象,传入函数func中? 求高人指教,谢谢!

# 自定义聚合函数

def func(df):

#print type(df) #参数为索引所对应的记录

return df.max() - df.min()

print(df.groupby('key1').agg(func))

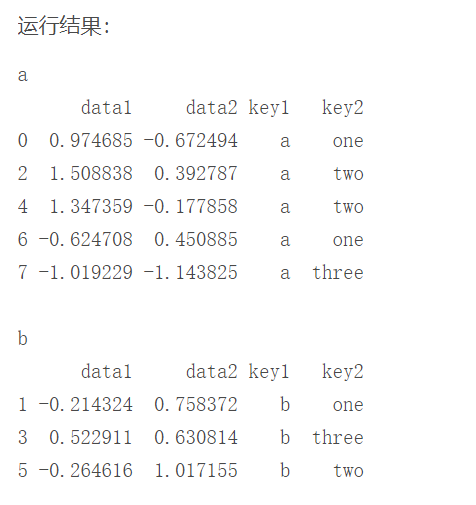

示例代码:**(我想把这里对象a,b 取出来放入agg的函数,求指教!!!)**

# 单层分组,根据key1

for group_name, group_data in grouped1:

print(group_name)

print(group_data)