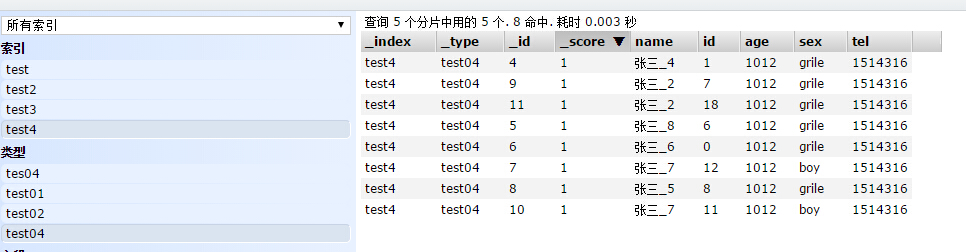

通过 界面可以看到数据

过滤器写法:

public void search04() {

FilterBuilder filter =FilterBuilders.prefixFilter("name", "张三");

SearchResponse res = client.prepareSearch("test4").setTypes("test04")

.execute().actionGet();

SearchHits shs = res.getHits();

System.out.println("总共有数据:" + shs.getHits().length);

for (SearchHit it : shs) {

System.out.println(it.getSource());

}

}