请大神帮忙解决一下:六台机器,SparkStreaming的例子程序,运行在yarn上四个计算节点(nodemanager),每台8G内存,i7处理器,想测测性能。

自己写了socket一直向一个端口发送数据,spark 接收并处理

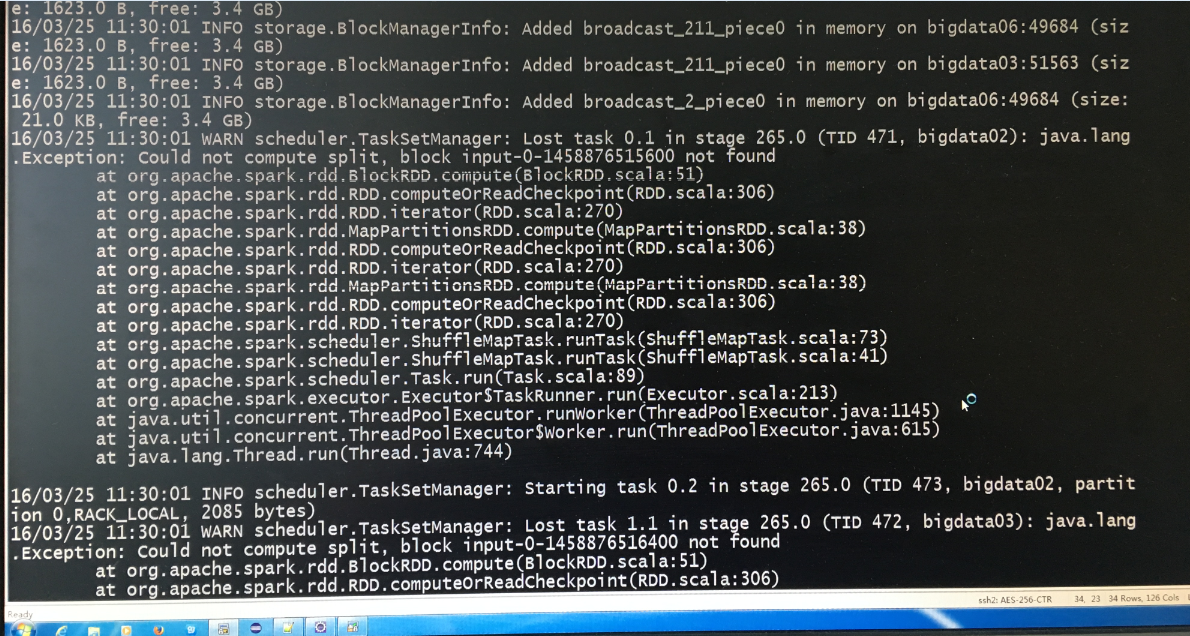

运行十几分钟汇报错:WARN scheduler TaskSetManagerost task 0.1 in stage 265.0 :java.lang.Exception:Could not compute split ,block input-0-145887651600 not found

六台机器集群,40M数据就报错,spark streaming运行例子程序wordcount

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-