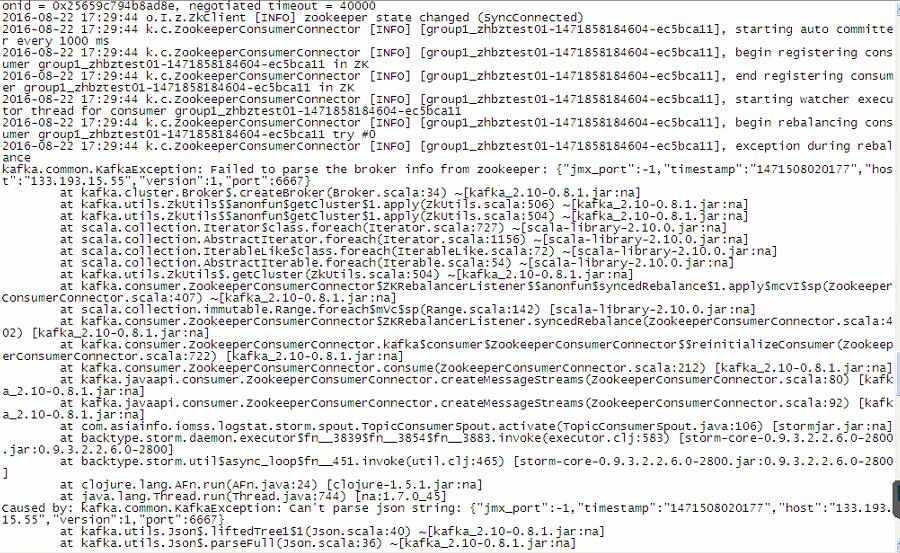

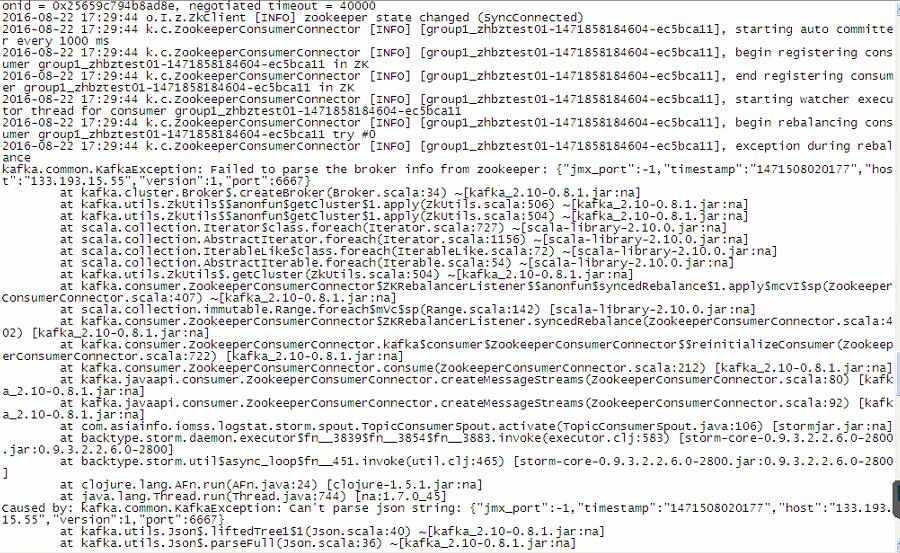

使用flume将文件数据解析发送到kafka上,然后使用storm(storm运行自己写的java程序,程序中使用kafka 的consumer)读取kafka中的数据,使用zookeeper管理集群,有3个节点,报错如下:

从报错上看是其中的一个主机的kafka与zookeeper的通信有问题?不过这只是我的猜测,大牛们遇到过类似的问题吗?或者说 有什么解决问题的思路吗?

补充,就这一个主机有问题,却导致了storm无法正常运行,无法读取任何数据。

使用flume将文件数据解析发送到kafka上,然后使用storm(storm运行自己写的java程序,程序中使用kafka 的consumer)读取kafka中的数据,使用zookeeper管理集群,有3个节点,报错如下:

从报错上看是其中的一个主机的kafka与zookeeper的通信有问题?不过这只是我的猜测,大牛们遇到过类似的问题吗?或者说 有什么解决问题的思路吗?

补充,就这一个主机有问题,却导致了storm无法正常运行,无法读取任何数据。