1条回答 默认 最新

hijack00 2016-09-11 13:29关注

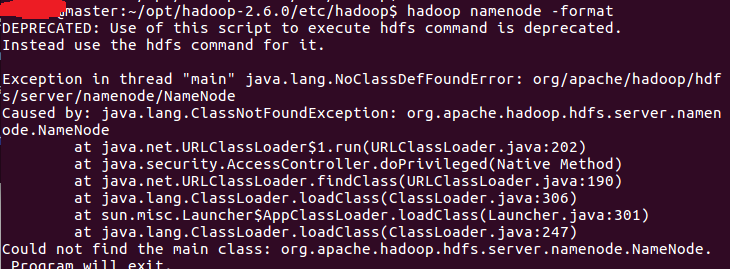

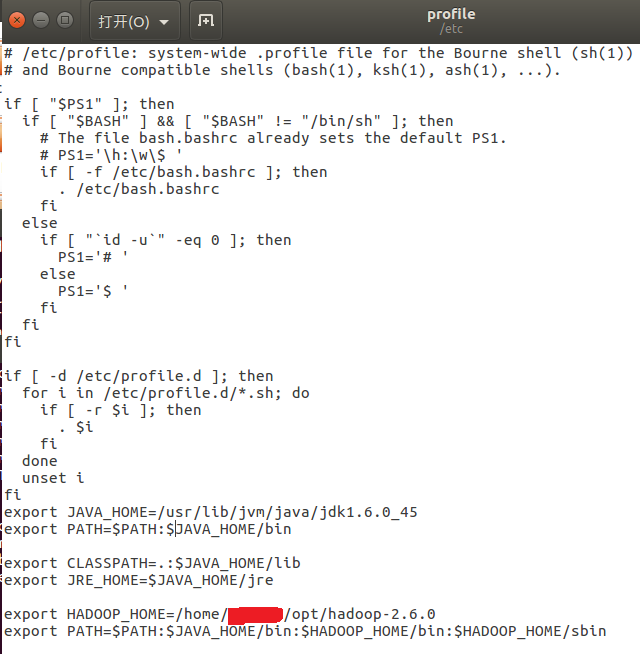

hijack00 2016-09-11 13:29关注使用hadoop classpath命令查看hadoop当前配置的classpath路径,这样可以确定hadoop配置是不是有问题。

此外,将log4j.properties文件中的LogLevel设置为DEBUG,重点关注日志中的WARN和ERROR,这样可能会找到出错原因。解决 无用评论 打赏 举报

悬赏问题

- ¥15 Python爬取指定微博话题下的内容,保存为txt

- ¥15 vue2登录调用后端接口如何实现

- ¥65 永磁型步进电机PID算法

- ¥15 sqlite 附加(attach database)加密数据库时,返回26是什么原因呢?

- ¥88 找成都本地经验丰富懂小程序开发的技术大咖

- ¥15 如何处理复杂数据表格的除法运算

- ¥15 如何用stc8h1k08的片子做485数据透传的功能?(关键词-串口)

- ¥15 有兄弟姐妹会用word插图功能制作类似citespace的图片吗?

- ¥15 latex怎么处理论文引理引用参考文献

- ¥15 请教:如何用postman调用本地虚拟机区块链接上的合约?