1条回答 默认 最新

Little_Cigar 2017-12-06 06:40关注

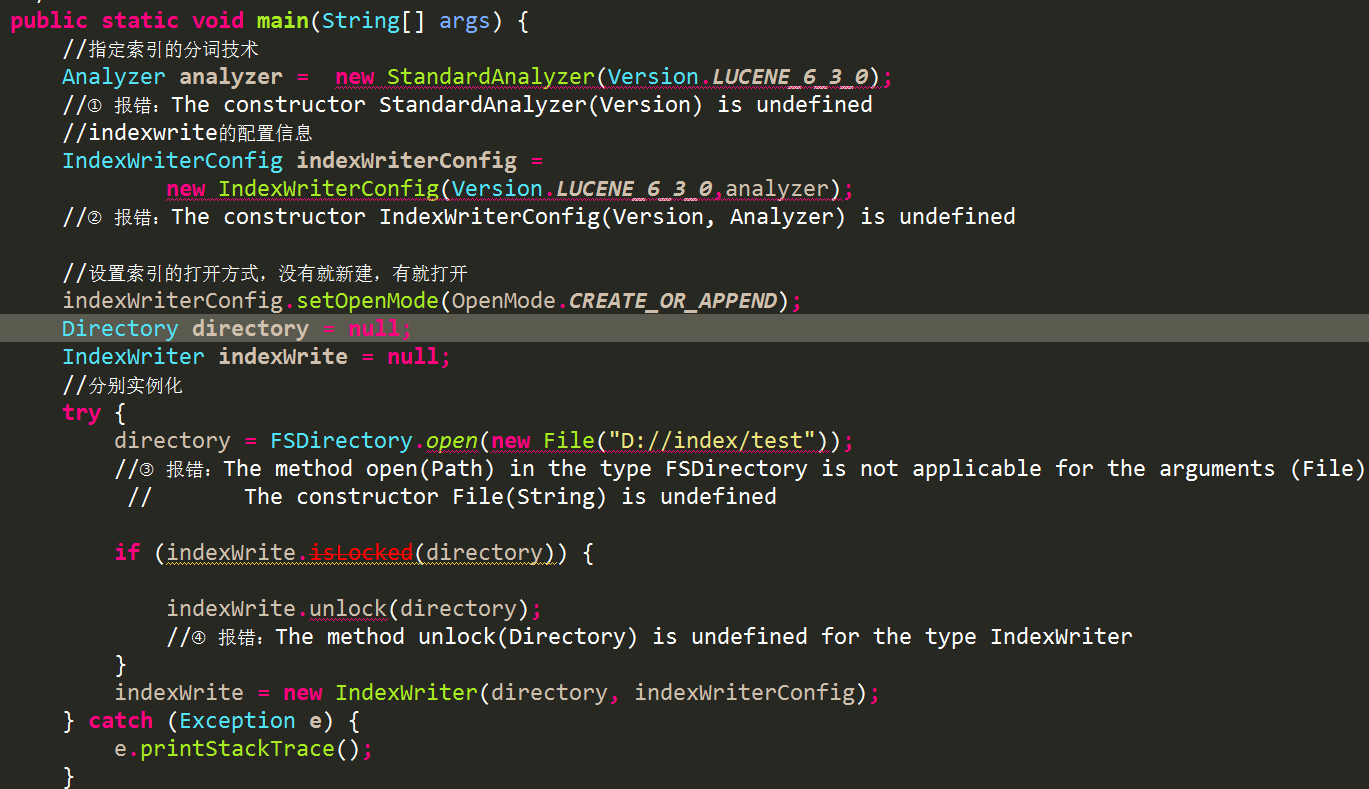

Little_Cigar 2017-12-06 06:40关注用这种方法啊,Directory directory = FSDirectory.open(Paths.get(indexPath)); indexPath是你的D://index/test

解决 无用评论 打赏 举报

用这种方法啊,Directory directory = FSDirectory.open(Paths.get(indexPath)); indexPath是你的D://index/test