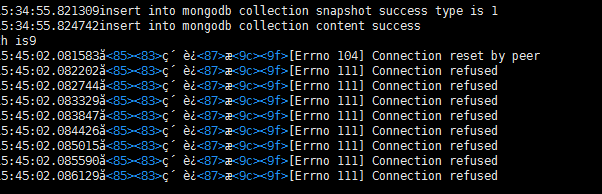

在使用爬虫抓取 网站的时候,启动了多个进程,运行一段时间后有的进程会无缘无故的停止,,,,还经常会出现超时,,,,还有一个连接被拒绝的错误,,,请教大神这些问题产生的原因有哪些,,,怎么解决的.。。。。

附连接拒绝的错误

python+scrapy+selenium爬虫超时和连接被拒绝问题

- 写回答

- 好问题 0 提建议

- 追加酬金

- 关注问题

- 邀请回答

-

4条回答 默认 最新

oyljerry 2017-03-23 04:42关注

oyljerry 2017-03-23 04:42关注一个是爬虫的个数,可能被服务器判断出在扒取数据了,还有就是同一个IP访问过多,

所以拒绝你的连接。一个是降低扒取的频率,还有就是增加proxy代理,通过不同的IP爬取网站

解决 无用评论 打赏 举报

悬赏问题

- ¥15 (希望可以解决问题)ma和mb文件无法正常打开,打开后是空白,但是有正常内存占用,但可以在打开Maya应用程序后打开场景ma和mb格式。

- ¥20 ML307A在使用AT命令连接EMQX平台的MQTT时被拒绝

- ¥20 腾讯企业邮箱邮件可以恢复么

- ¥15 有人知道怎么将自己的迁移策略布到edgecloudsim上使用吗?

- ¥15 错误 LNK2001 无法解析的外部符号

- ¥50 安装pyaudiokits失败

- ¥15 计组这些题应该咋做呀

- ¥60 更换迈创SOL6M4AE卡的时候,驱动要重新装才能使用,怎么解决?

- ¥15 让node服务器有自动加载文件的功能

- ¥15 jmeter脚本回放有的是对的有的是错的