有个网址是动态的,我需要爬取的数据存储在json数据格式中,

这个用json模块读取没毛病,

但是存在这么一个问题,就是向这个数据url提交访问请求时,

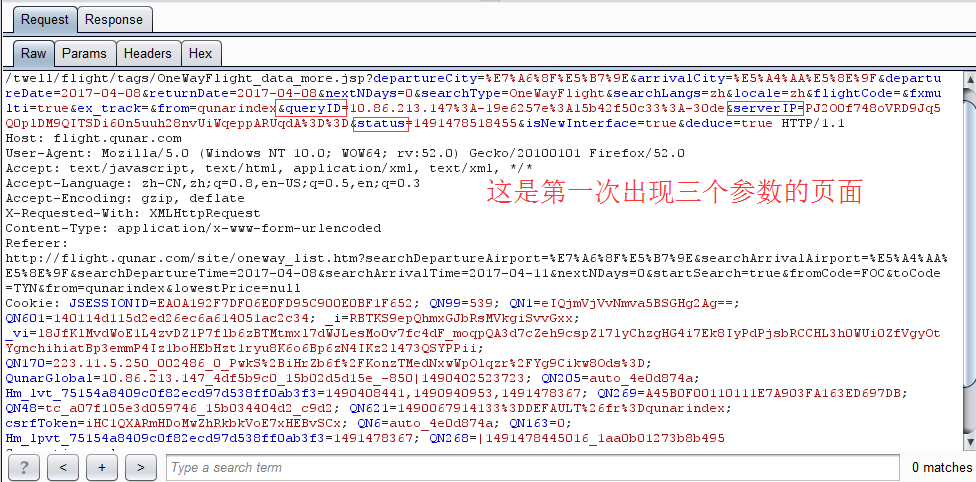

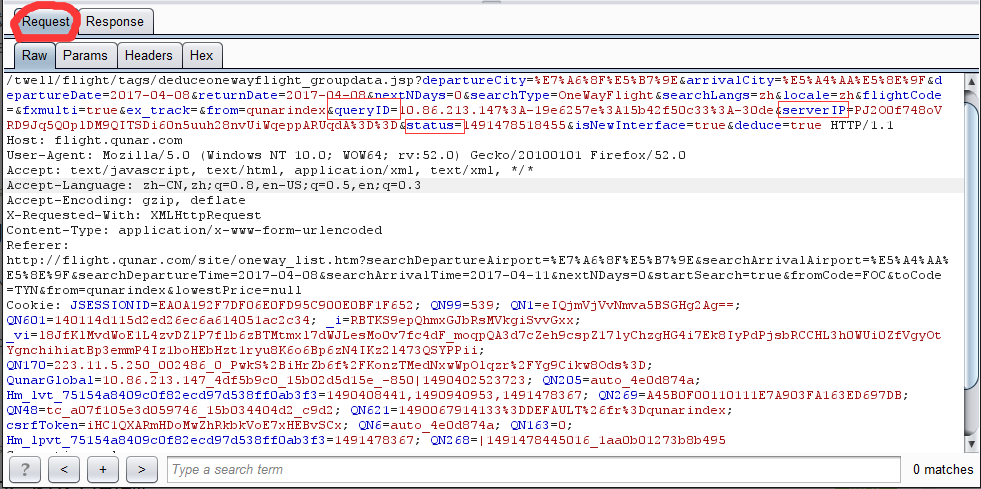

有加密的参数,比如queryID,serverIP,status这三个参数,删去这几个参数去访问是被对方服务器禁止的,

而且通过正常浏览器访问的话,这个页面会在一分钟左右失效不可访问

去找cookies,没在cookies中找到与这三个参数有关联,我没法构造出这个数据页面的url

想问问各位大牛,向某个网站请求的时候,这些动态的参数一般会存储在哪里?怎么获取这种动态添加的参数?

感激不尽!

python爬取动态网址时如何获取发送的参数

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-