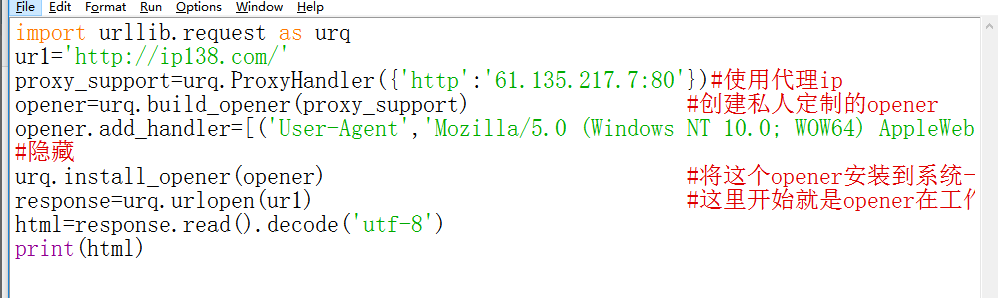

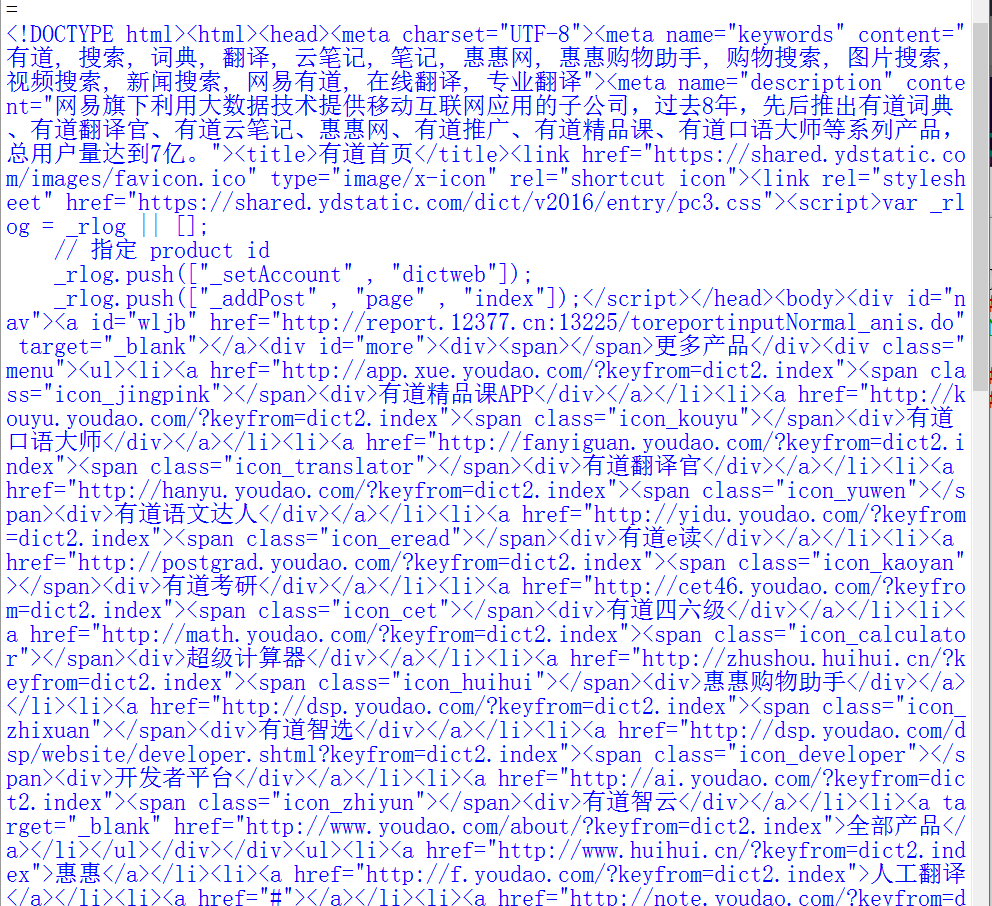

在网站上找一个免费的ip代理,在窗口上打印出来自己的代理ip,但是显示结果并没有看到IP的有关记录,全是网易上的网页内容好像,哪位大神可以帮我解惑!!!

关于python爬虫代理ip的问题

- 写回答

- 好问题 0 提建议

- 追加酬金

- 关注问题

- 邀请回答

-

2条回答 默认 最新

悬赏问题

- ¥15 微信公众号自制会员卡没有收款渠道啊

- ¥15 stable diffusion

- ¥100 Jenkins自动化部署—悬赏100元

- ¥15 关于#python#的问题:求帮写python代码

- ¥20 MATLAB画图图形出现上下震荡的线条

- ¥15 关于#windows#的问题:怎么用WIN 11系统的电脑 克隆WIN NT3.51-4.0系统的硬盘

- ¥15 perl MISA分析p3_in脚本出错

- ¥15 k8s部署jupyterlab,jupyterlab保存不了文件

- ¥15 ubuntu虚拟机打包apk错误

- ¥199 rust编程架构设计的方案 有偿