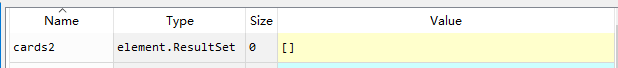

cards2 = soup.find_all('div',class_='product ')

class的属性值我是复制粘贴过来的,find其他的div上没有问题,可是就是这个总是给我返回空列表

网址为:https://list.tmall.com/search_product.htm?q=%CA%D6%BB%FA

请大神们帮忙看看是怎么回事

cards2 = soup.find_all('div',class_='product ')

class的属性值我是复制粘贴过来的,find其他的div上没有问题,可是就是这个总是给我返回空列表

网址为:https://list.tmall.com/search_product.htm?q=%CA%D6%BB%FA

请大神们帮忙看看是怎么回事