需要在C#中绘制图表,图表还是可以拖动,放大缩小的那种,python的matplotlib包含了这些功能,所以想将matplotlib嵌入到C#的GUI中,我是C#新手,这是老师给的任务,求C#大佬们帮忙。

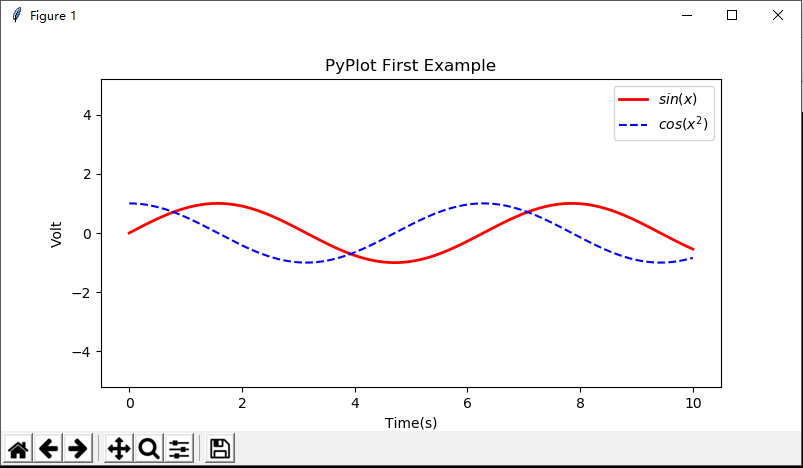

下图是matplotlib绘制图表的示例图:

将matplotlib嵌入到C#的GUI中

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

3条回答 默认 最新

threenewbee 2017-11-08 15:29关注

threenewbee 2017-11-08 15:29关注C# 有 chart控件,不需要matplotlib,只要你算出数据就可以。

本回答被题主选为最佳回答 , 对您是否有帮助呢?解决 无用评论 打赏 举报