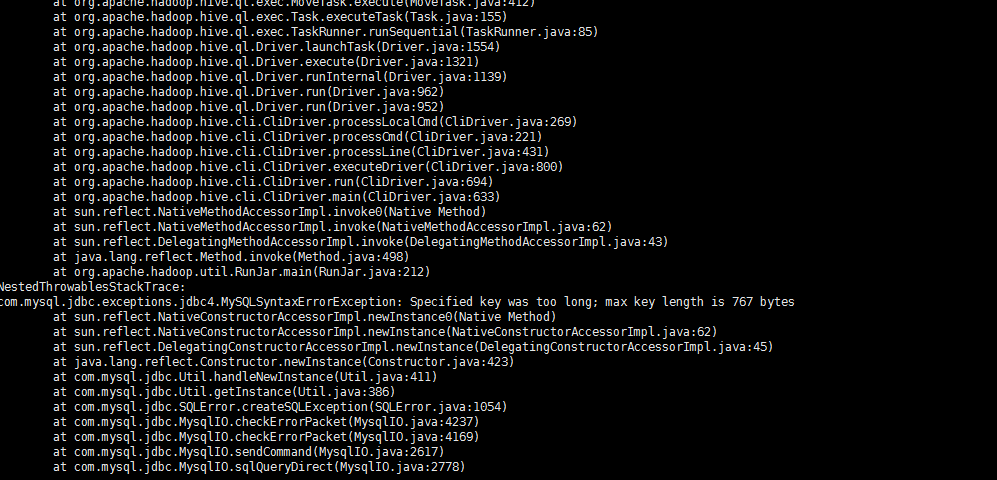

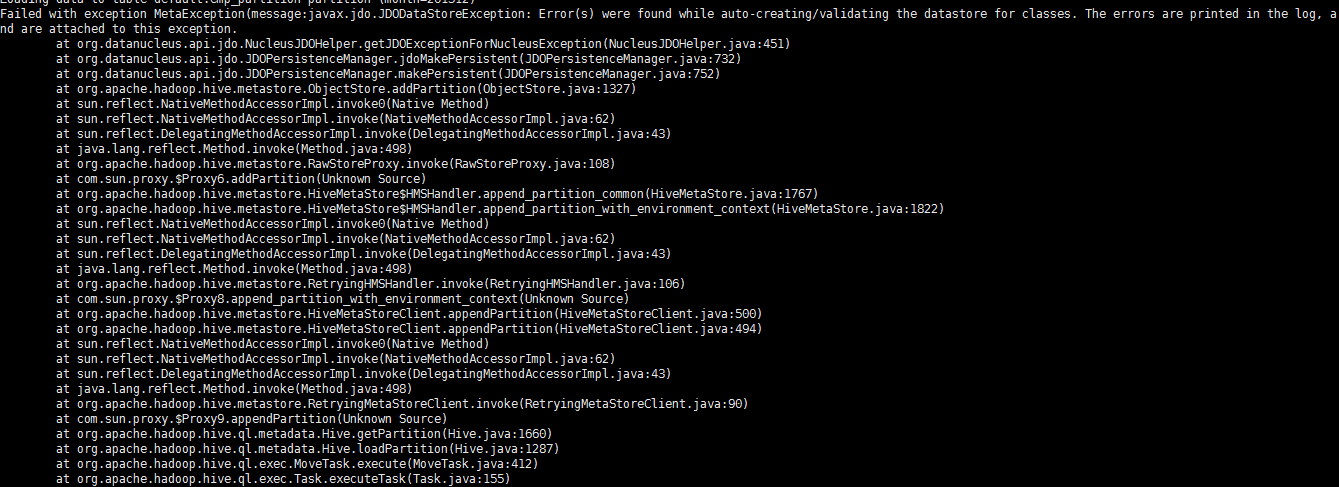

分区表导入数据load data local inpath '/opt/datas/distdata/emp.txt' into table emp_partition partition(month='201512');我修改了mysql的字符集:alter database hive character set latin1;报错如下:

不知道这个问题是怎么回事

文件也上传上去了 select查询就查不出来

大数据hive分区表导入数据的问题

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-