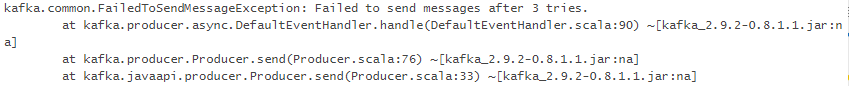

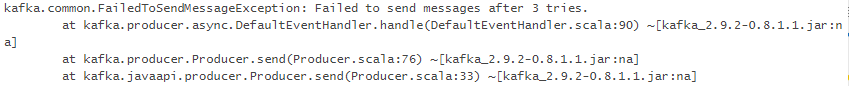

服务器正常运行,kafka本来没有问题,从某一时刻开始,就一直抛异常了,重启服务器后恢复正常。

请问是什么原因?

绝大部分消息抛异常了,还有很小一部分没有抛异常,但也没收到,这些丢失但没有异常的又是什么原因?

已知情况:kafka消息生产者 没有指定partition

服务器正常运行,kafka本来没有问题,从某一时刻开始,就一直抛异常了,重启服务器后恢复正常。

请问是什么原因?

绝大部分消息抛异常了,还有很小一部分没有抛异常,但也没收到,这些丢失但没有异常的又是什么原因?

已知情况:kafka消息生产者 没有指定partition

1, 先确认你的网络有没有问题

2,在向服务器发起连接后,在kafka的服务器配置中有zookeeper.connect=xx.xx.xx.xx:2181的配置 这时候kafka会查找zookeeper

那么如果我们的hosts 中没有做hosts的配置 kafka经多次尝试连接不上就会报上面的错误,所有要做host映射,配置hosts文件 做zookeeper服务器的映射配置。

3,出现此种错误 还有一种情况

advertised.host.name=192.168.1.118

远程连接的话 是根据这个配置来找broker的,默认是localhost ,所以如果不是本机运行的话 应该设置此值 来确保通信畅通。