现在已将图片数据存储到了Hbase表中,能够通过http方式访问Hbase表中的图片,

但是返回是以XML和Json返回的。 因为图片是想在web系统中直接展示用的(类似http

的方式直接展示图片)。

有没有有这方面的大佬能解答下,或者知道方法的指点下,多谢大家了。

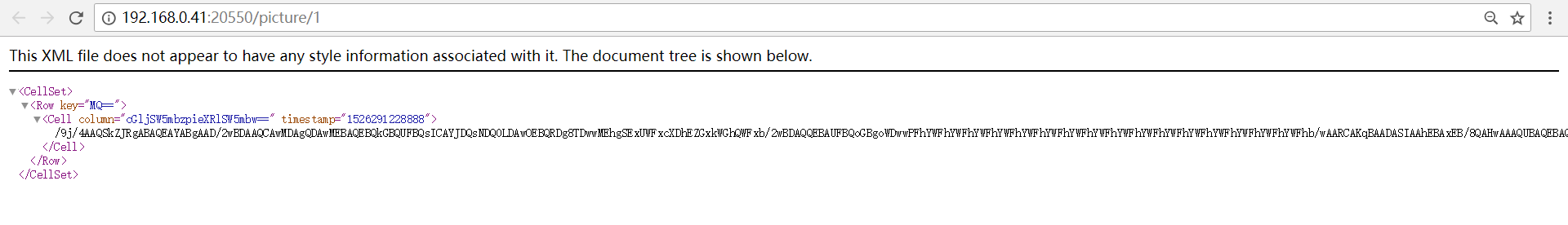

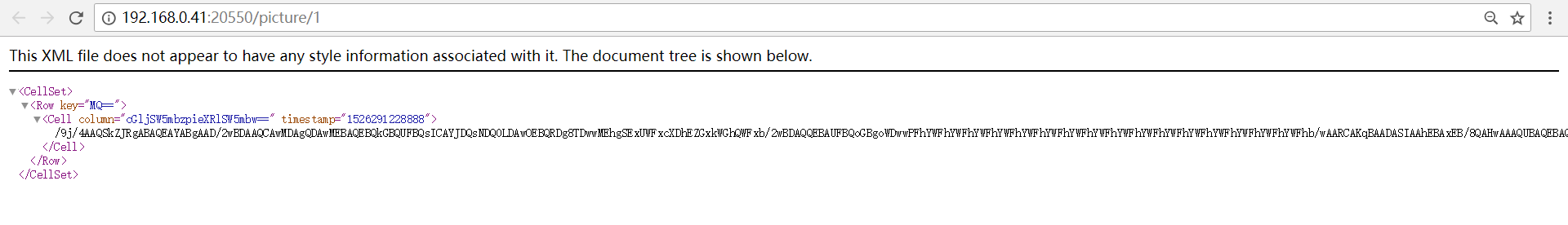

下面是我现在访问Hbase的返回:

现在已将图片数据存储到了Hbase表中,能够通过http方式访问Hbase表中的图片,

但是返回是以XML和Json返回的。 因为图片是想在web系统中直接展示用的(类似http

的方式直接展示图片)。

有没有有这方面的大佬能解答下,或者知道方法的指点下,多谢大家了。

下面是我现在访问Hbase的返回: