kafka和zookeeper都放在了一台windows系统上。

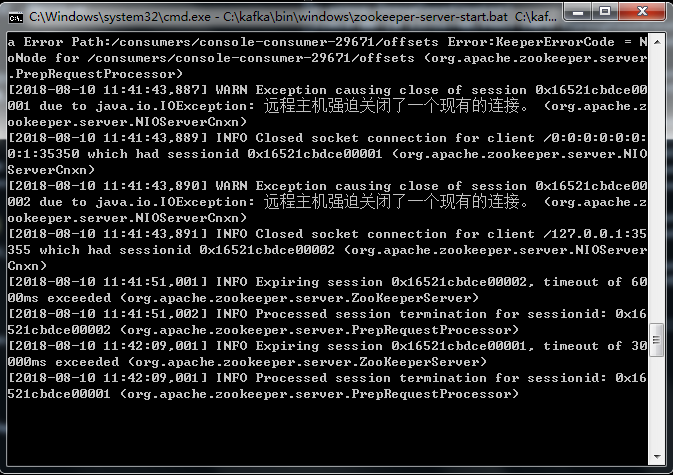

kafak的运行页面没什么变化,但是zookeeper服务就会出现“远程主机强迫关闭了一个现有的连接“,但是对kafka生产和消费消息并没有什么影响,请问这是什么原因导致的。 强迫关闭的连接是什么?

kafka服务安装在windows下,有时zookeeper会出现“远程主机强迫关闭了一个现有的连接“

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

1条回答 默认 最新

oyljerry 2018-08-10 06:15关注

oyljerry 2018-08-10 06:15关注一般是网络连接被终止了,比如另一端程序被强制结束了。强制关闭的就是zookeeper跟对应consumer的连接

解决 无用评论 打赏 举报