getList:(firstRow,listRows)=>{

return new Promise((resolve,reject)=>{

let listStr = 'select count(*) from user;select * from user limit '+firstRow+','+listRows+'';

connection.query(listStr,function (err,result) {

console.log(result)

if(err){

reject(err)

}else{

resolve(result)

}

})

})

}

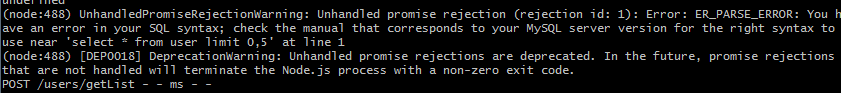

我封装了查询用户的一个方法,但是在查询时查询语句listStr一个是查询总数,一个是按条件查询时返回数组的语句,两个语句分开写时不会报错,但是合并起来就会报错。

另外这个方法是参照:https://blog.csdn.net/zhuming3834/article/details/77184193这个的,那个老哥暂时没回应,大家帮忙看看吧