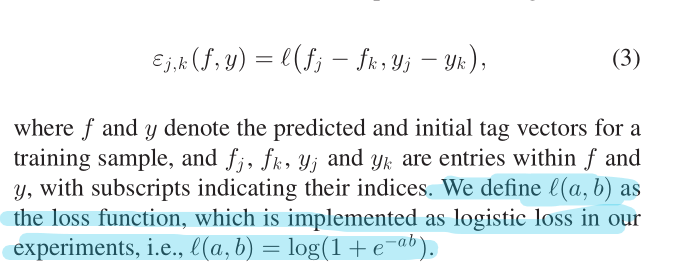

论文中损失函数为图片当中的定义

loss=tf.Variable(tf.constant(0.0))

for v in range(50):

y = y_[v]

y_pre = y_conv[v]

for n in range(260):

for m in range(260):

loss = loss + tf.log(1 + tf.exp((y[n]-y[m])*(y_pre[n]-y_pre[m])))

train_step = tf.train.AdamOptimizer(1e-4).minimize(loss)

其中y_是数据集标签,y_conv是tf.softmax的输出(为预测标签的输出),50是每个batch的大小,260是标签的个数。