2条回答 默认 最新

潭溪Zerg 2018-12-09 01:36关注

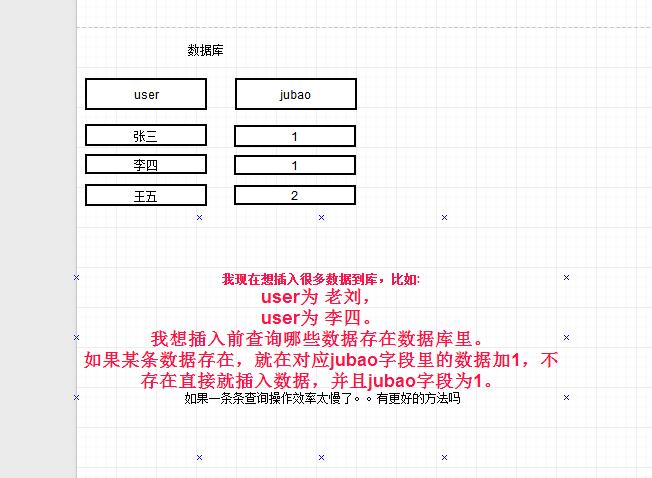

潭溪Zerg 2018-12-09 01:36关注使用insert update复合sql语句

例如你这里,insert into t(user, jubao) values( 'username', 1) on duplicate key update jubao = jubao + 1

前提是你需要保证user字段是唯一性,如果不是

alter table t add unique key(user);本回答被题主选为最佳回答 , 对您是否有帮助呢?解决 无用评论 打赏 举报