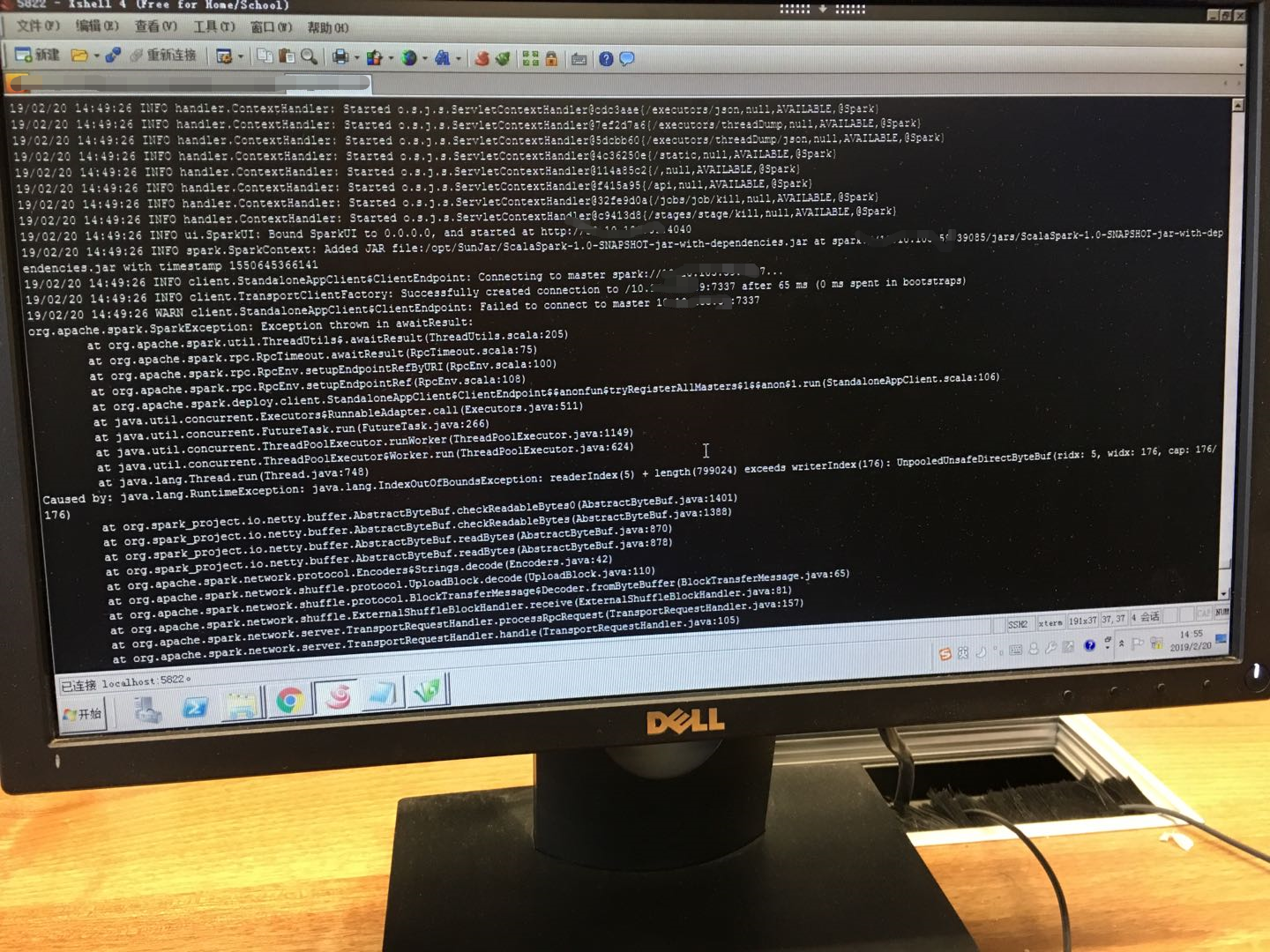

spark-shell --master spark://ip:7337 的方式运行

报错 readerIndex(5) + length(799024) exceeds writerIndex(176) : UNpooledUnsafeDir

(cdh集群的端口是7337没毛病,经常用的7077报错拒绝连接,可以排除端口问题)

现在提交spark-submit脚本运行standalone模式也是报同样的错,yarn模式没问题,百度谷歌无果,望大神们帮忙解决下!

spark-shell --master spark://ip:7337 的方式运行

报错 readerIndex(5) + length(799024) exceeds writerIndex(176) : UNpooledUnsafeDir

(cdh集群的端口是7337没毛病,经常用的7077报错拒绝连接,可以排除端口问题)

现在提交spark-submit脚本运行standalone模式也是报同样的错,yarn模式没问题,百度谷歌无果,望大神们帮忙解决下!

以下回答参考 皆我百晓生、券券喵儿 等免费微信小程序相关内容作答,并由本人整理回复。

根据您提供的信息,这似乎是一个关于使用Apache Spark的Standalone模式在特定端口上尝试连接失败的问题。要解决此问题,您可以尝试以下步骤:

检查Spark配置:确保您的Spark配置正确且没有冲突。

确保Spark服务已经启动:通过检查控制台或使用ps aux | grep spark命令来确认Spark服务是否正在运行。

检查网络设置:确认您的机器与Spark服务器之间的网络连接正常。

检查端口号:如果端口号已被其他应用程序占用,请尝试更改端口号,并再次尝试连接。

联系Apache Spark社区:Apache Spark社区提供了一个论坛和邮件列表,可以向他们寻求帮助和建议。

如果您能够提供更多的详细信息,例如错误日志、Spark版本号等,我将能为您提供更具体的解决方案。