例如以下是请求的url:

以下请求头:

Accept: text/html,application/xhtml+xml,application/xml;q=0.9,image/webp,image/apng,*/*;q=0.8

Accept-Encoding: gzip, deflate

Accept-Language: zh-CN,zh;q=0.9,en;q=0.8,ja;q=0.7,zh-TW;q=0.6,vi;q=0.5

Cache-Control: max-age=0

Connection: keep-alive

Cookie: Hm_lvt_78c58f01938e4d85eaf619eae71b4ed1=1550575085,1552764171; PHPSESSID=e9cddc3108ec629d2db0c2f2e30ce810; cid=e9cddc3108ec629d2db0c2f2e30ce8101552829178; ComputerID=e9cddc3108ec629d2db0c2f2e30ce8101552829178; other_uid=ths_mobile_iwencai_2e6c84325ffc4a0b201b430c00d1df46; iwencaisearchquery=%E8%BF%9E%E7%BB%AD15%E5%B9%B4%E6%89%A3%E9%9D%9E%E5%87%80%E5%88%A9%E6%B6%A6%E5%A4%A7%E4%BA%8E0%20%E5%B8%82%E5%87%80%E7%8E%87%E4%BD%8E%E4%BA%8E2%20roe%E9%AB%98%E4%BA%8E10%25%20%E5%B8%82%E7%9B%88%E7%8E%87%E4%BD%8E%E4%BA%8E20; guideState=1; Hm_lpvt_78c58f01938e4d85eaf619eae71b4ed1=1552835669; v=AoFMlTW5uV-o89Vrfg5AnBoTkMaYrvY4Hy-ZvOPWfVvmsa8wK_4FcK9yqbBw

Host: search.10jqka.com.cn

Referer: http://search.10jqka.com.cn/stockpick/search?typed=1&preParams=&ts=1&f=1&qs=result_rewrite&selfsectsn=&querytype=stock&searchfilter=&tid=stockpick&w=%E5%B8%82%E7%9B%88%E7%8E%87%E5%A4%A7%E4%BA%8E%E7%AD%89%E4%BA%8E21%E5%80%8D%E4%B8%94%E5%B8%82%E7%9B%88%E7%8E%87%E5%B0%8F%E4%BA%8E%E7%AD%89%E4%BA%8E22%E5%80%8D&queryarea=

Upgrade-Insecure-Requests: 1

User-Agent: Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/72.0.3626.121 Safari/537.36

我的代码:

r=requests.get(myurl,headers=myheader)

其中myurl就是上面要请求的url,myheader就是上面的请求头

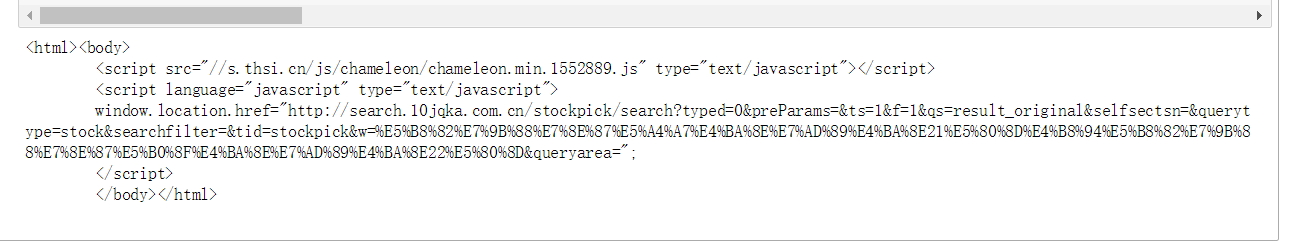

如果请求头里不包含cookie,那么r.text的结果就显示异常,根本不是我想要的信息:

若是请求头里包含了cookie,那么r.text就显示正常(正常的我就不列出来了)。但问题来了:这个cookie是随机没有规律的,而且过一段时间就失效,而且好像我打开新的网页也会重置什么的,那我怎么才能写请求头呢?