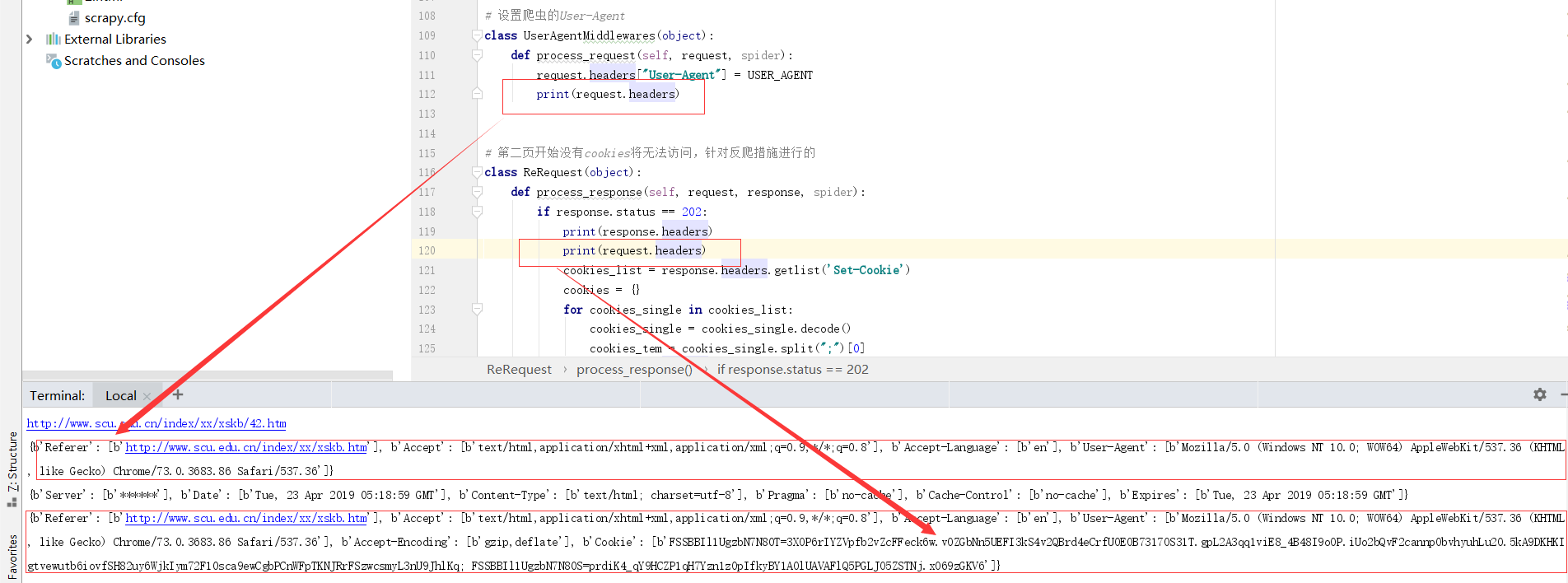

如图所示,在request进入downloader之前,headers里是没有cookie字段的,但是在下载结束后,request的headers字段里出现了cookie字段,且该cookie内容为上一次请求返回的set-cookie的内容,但是这里我其实是不需要这个request携带任何cookie进行请求的,尝试过在settting里设置cookies-enabled=False,这样虽然request.headers里的确没有cookie可以得到我希望的请求头,但是后续需要携带cookie的请求就没办法继续正常请求了,请问如何设置本次请求不携带上一次请求的xin'xi

求解关于scrapy请求会自动携带上一次请求中的set-cookie字段的问题

- 写回答

- 好问题 0 提建议

- 关注问题

- 邀请回答

-

2条回答 默认 最新

Yajun-Z 2019-04-24 18:09关注

Yajun-Z 2019-04-24 18:09关注在你不需要的地方手动清除不可行吗?或者你每次在不需要

cookies的地方深拷贝一份setting里面的headers解决 无用评论 打赏 举报