不用代理都可以,ip代理测试是没问题的

以下回答参考 皆我百晓生、券券喵儿 等免费微信小程序相关内容作答,并由本人整理回复。

要解决这个问题,首先需要了解Python Scrapy框架是如何处理HTTP请求的。Scrapy使用Twisted作为其核心异步I/O库来实现并发爬虫。

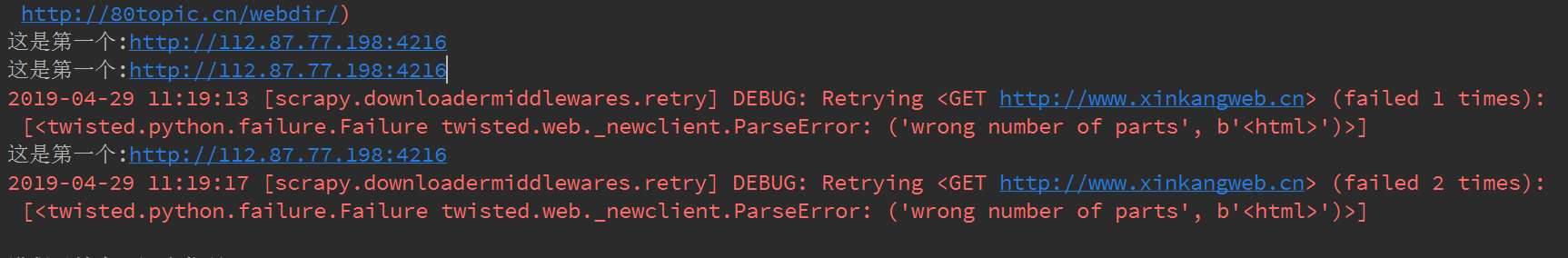

在上述问题中,你提到的两个URL都指向了相同的服务器(http://80topic.cn/webdir/),这表明它们可能来自同一个IP地址或网络。如果一个URL可以正常工作而另一个不能,则可能是由于网络连接不稳定或其他原因导致的问题。

为了进一步分析问题,你可以尝试以下步骤:

以下是针对上述问题的一些建议和示例代码片段:

import time

from scrapy.exceptions import IgnoreRequest, NotProxyAvailable

from scrapy.http import HtmlResponse

from twisted.internet.error import TimeoutError

# 定义一个函数来处理异常并返回响应

def handle_exception(e):

if isinstance(e, NotProxyAvailable):

return None

else:

raise e

# 检查是否为代理问题

def check_proxy(proxy):

try:

# 使用proxy访问url

response = requests.get("http://www.google.com", proxies={"http": proxy})

print(f"Success with proxy {proxy}")

return True

except Exception as e:

print(f"Failed with proxy {proxy}: {e}")

return False

# 主循环

while True:

# 随机获取一个代理

proxy = get_random_proxy()

# 检查是否可用

if not check_proxy(proxy):

continue

# 发送请求

request = Request(url)

response = make_request_from_response(request, lambda: HtmlResponse(url, encoding="utf-8"))

yield response

get_random_proxy()方法随机生成一个代理。check_proxy()函数检查这个代理是否可用。请注意,上述代码仅提供了一个基本思路,实际应用中还需要根据具体情况调整参数、逻辑以及异常处理策略。此外,对于复杂的爬虫场景,建议采用更专业的代理池管理工具或者自动化测试脚本,避免手动编写复杂的逻辑判断和错误处理。