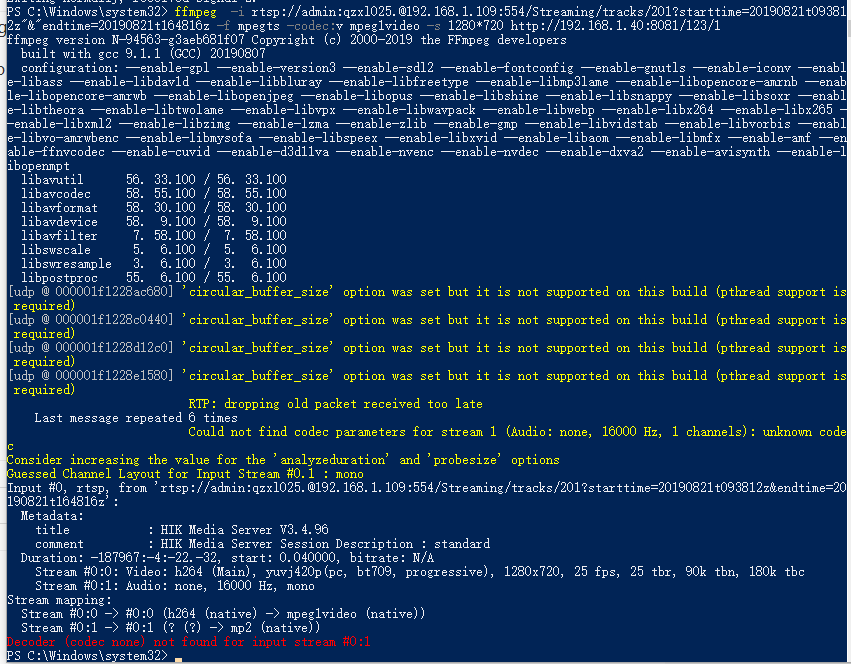

命令:ffmpeg -i rtsp://admin:qzxl025.@192.168.1.109:554/Streaming/tracks/201?starttime=20190821t09381

2z"&"endtime=20190821t164816z -f mpegts -codec:v mpeg1video -s 1280*720 http://192.168.1.40:8081/123/1

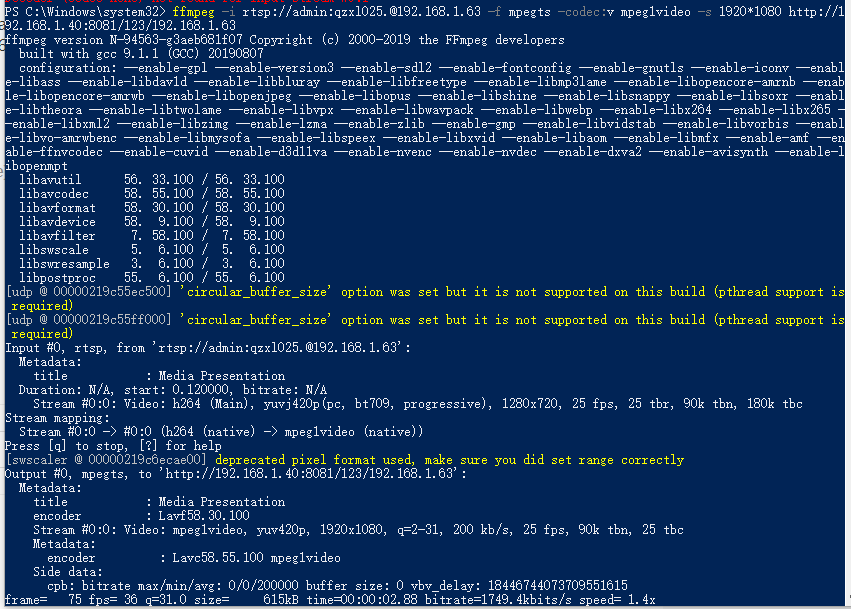

如果直接摄像头的RTSP流就完全没问题

这是什么原因啊,回放流和预览流有区别吗????求大佬解答一下