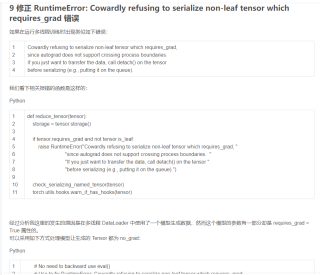

RuntimeError: Cowardly refusing to serialize non-leaf tensor which requires_grad, since autograd does not support crossing process boundaries. If you just want to transfer the data, call detach() on the tensor before serializing 大佬们,这个问题一般是怎么解决的?requires_grad全设置为false么,设置为false后不会改变原有逻辑么?原有逻辑是需要grad回传导数的

在多线程并行的时候serialize a tensor 需要gradient计算,计算图分开了,autograd 不支持在多个process之间去做同步

能找到这个tensor,但是这个tensor本来是需要gradient计算,如果设置成require_grads=False,不会改变原有的逻辑么。目前想要的状态是,既支持多个process并行,又支持这个tensor的autograd

目前的问题是autograd 不支持在多个process之间去做同步