如题,如何用C语言计算hamming级数,并控制误差呢?

注意,要求每次提示用户输入x的值(如0.0 0.1 1.0 10.0 100.0),程序最终按行输出级数和、误差估计(要求控制在10e-6内)、k的上界和计算耗时。另外,要考虑x值太大时程序能否输出数据。

如题,如何用C语言计算hamming级数,并控制误差呢?

注意,要求每次提示用户输入x的值(如0.0 0.1 1.0 10.0 100.0),程序最终按行输出级数和、误差估计(要求控制在10e-6内)、k的上界和计算耗时。另外,要考虑x值太大时程序能否输出数据。

关注

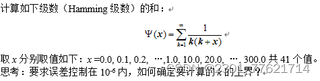

关注让阿豪来帮你解答,本回答参考chatgpt3.5编写提供,如果还有疑问可以评论或留言解答: 首先,hamming级数指的是如下的无穷级数:

其中,x为用户输入的值。

要用C语言计算hamming级数,并控制误差,需要按照下面的步骤进行:

其中,x为用户输入的值。

要用C语言计算hamming级数,并控制误差,需要按照下面的步骤进行:

printf("请输入x的值:");

scanf("%lf", &x);

sum = 1.0 + x;

term = x;

k = 2;

gettimeofday(&start_time, NULL); // 记录开始时间

while (fabs(term) >= eps) {

term *= x / k * (k + 1) / (k + 2);

sum += term;

k += 3;

}

gettimeofday(&end_time, NULL); // 记录结束时间

printf("级数和为:%f\n", sum);

printf("误差估计为:%f\n", fabs(term));

printf("计算到第%d项\n", k);

printf("计算耗时:%ld us\n", (end_time.tv_sec - start_time.tv_sec) * 1000000 + (end_time.tv_usec - start_time.tv_usec));

完整代码如下: