让阿豪来帮你解答,本回答参考chatgpt3.5编写提供,如果还有疑问可以评论或留言

问题描述:

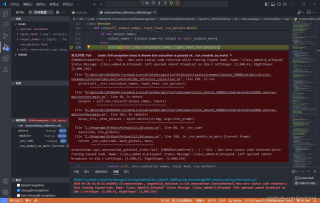

使用 GroundingDINO-onnxrun 的 Python 程序时,将 onnxruntime 设置为 GPU 推理时会报错 "onnxruntime.capi.onnxruntime_pybind11_state.Fail: [ONNXRuntimeError] : 1 : FAIL : Non-zero status code returned while running Expand node. Name:'/class_embed.0_4/Expand' Status Message: /class_embed.0_4/Expand: left operand cannot broadcast on dim 2 LeftShape: {1,900,4}, RightShape: {1,900,256}",请问这个有解决方案吗?

问题分析:

根据报错信息,出错的地方在 onnxruntime 的 Expand 节点上,原因是左侧的操作不允许在第二维进行广播。左操作的形状是 {1, 900, 4},右操作的形状是 {1, 900, 256}。可能是由于形状不匹配而导致的问题。

解决方案:

- 检查代码: 可以通过检查代码来确定问题是否在输入数据的处理过程中出现了错误。查看输入数据是否有误,如是否存在 NaN、无穷值等非法输入。检查输入数据的类型是否与模型的期望类型相同。

- 更新 onnxruntime 版本: 更新 onnxruntime 到最新版本,以确保能够获得最新的 bug 修复和性能优化。可以在命令行中使用以下命令升级: pip install onnxruntime --upgrade

- 修改模型: 如果在模型的构建和训练过程中出现了问题,则需要修改模型。请检查模型中使用的层、激活函数、优化器等是否合适,是否存在错误。

- 修改输入数据: 尝试调整输入数据的形状,使其与期望的形状相同。您可以尝试调整输入数据的大小、形状、尺寸等,以使其适应模型的期望输入。

- 切换到 CPU 推理: 如果将 onnxruntime 设置为 GPU 推理时出现错误,则可以将其设置为 CPU 推理。您可以使用以下代码将 onnxruntime 设置为 CPU 推理: import onnxruntime ort_session = onnxruntime.InferenceSession('model.onnx') ort_session.set_providers(['CPUExecutionProvider']) 案例分享: 下面提供一个样例代码,演示如何使用 onnxruntime 进行 CPU 推理: import numpy as np import onnxruntime

创建一个 InferenceSession 实例并将其设置为 CPU 推理

ort_session = onnxruntime.InferenceSession('model.onnx') ort_session.set_providers(['CPUExecutionProvider'])

初始化输入数据

input_data = np.random.rand(1,900,4).astype(np.float32)

执行推理

outputs = ort_session.run([], {'input_data': input_data})

输出结果

print(outputs)