为什么我重启后还是master节点,怎么切换到slave节点呀

关注

关注引自免费微信小程序:皆我百晓生

要从Master节点切换到Slave节点,在Linux环境中,你可以按照以下步骤进行操作:

备份现有数据和配置文件:

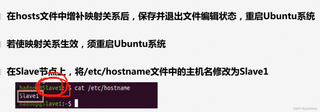

在/etc/hostname文件中更改主机名以使其与Slave1相对应,确保已备份旧主机名。

sudo cp /etc/hostname/master /etc/hostname/slave1

重置Hadoop配置文件:

修改 /etc/hadoop/conf/core-site.xml 文件以启用SMB shares和认证以从Master转换到Slave。

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://Slave1:8020</value>

</property>

<property>

<name>hadoop.security.authentication</name>

<value>kerberos</value>

</property>

</configuration>

重启Hadoop服务:

使用sudo service hadoop restart命令启动Hadoop服务,并指定新的Master节点地址。

sudo service hadoop restart -D namenode.address=Slaveserver1:9000

检查集群状态: 验证新Cluster是否已成功切换至Slave节点:

hdfs dfs status

重新配置HDFS namenode:

通过hdfs dfs rmod命令移动namenode到新的Host Master信息文件(如/etc/hadoop/namenode/primary.hdfs.namenode):

hdfs dfs rmod namenode /etc/hadoop/namenode/primary.hdfs.namenode

重启HDFS Namenode:

将namenode设置为Secondary host模式以完成其职责迁移:

sudo service hadoop namenode set-secondary-hosts primary host slave1:9000

重新启动YARN和Hive:

根据您的Yarn和Hive的部署方式,确认Hive和YARN的服务已经更新到新的主Master节点(在这个例子中是Slaveserver1),然后进行服务重启:

sudo service yarn-client restart

sudo service hive-server restart

检查服务状态: 检查所有服务是否都已正常运行,包括Hadoop,YARN,Hive等:

hdfs dfs status

hive status

yarn-client status

现在,您已经在Linux系统中成功将当前主Master节点切换到了名为Slaveserver1的新Slave节点。在 /etc/hostname 文件中,您可以查看新的主机名及其对应的IP地址。如果您尝试登录到该新集群,可能会发现用户名为slaveserver1且密码为空的Hadoop Master节点。这表明默认Hadoop服务由新的Slaveserver1主机运行,而不是旧的master主机。此时,您可以通过访问 http://localhost:9000 或者 http://slaveserver1:9000 来验证新集群的环境配置是否正确。若无错误,则SSH客户端连接到新的主节点应正常工作,能创建、读取和写入文件。

请注意,这个过程涉及对配置文件的修改以及Hadoop服务的重启,这些操作可能需要一定的技术知识和网络环境。如果您在实际操作过程中遇到任何问题或不熟悉上述步骤,请查阅相关文档或向专业的Hadoop或YARN技术支持人员寻求帮助。