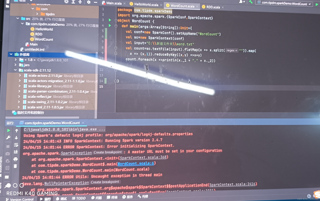

-为啥程序运行不起来,全是红色代码,到底是哪里出错了 ,请各位帮忙瞅一眼

关注

关注引自免费微信小程序:皆我百晓生

从你提供的信息来看,你在尝试运行一个基于Apache Spark的Scala程序,但遇到了启动失败的问题。错误提示是 "A master URL must be set in your configuration",这意味着你需要在配置中指定Spark的集群master地址。

解决这个问题的方法是在创建SparkConf对象时设置master URL。默认情况下,Spark会尝试连接到本地运行的standalone模式的Spark Master(如果没有找到,它会启动一个本地Master)。然而,在大多数生产环境中,Spark通常部署在集群上,这时就需要明确提供集群的master地址。

以下是修改后的代码片段,添加了master URL的设置:

import org.apache.spark.{SparkConf, SparkContext}

object WordCount {

def main(args: Array[String]): Unit = {

val masterUrl = "local[*]" // 使用本地模式,如果是集群,请替换为集群的master地址,例如 "spark://your-master-host:7077"

val conf = new SparkConf()

.setAppName("WordCount")

.setMaster(masterUrl)

val sc = new SparkContext(conf)

val input = "C:\\新建文件夹\\word.txt"

val lines = sc.textFile(input)

val words = lines.flatMap(_.split(" "))

val wordCounts = words.map(word => (word, 1)).reduceByKey(_ + _)

wordCounts.foreach(println)

sc.stop()

}

}

确保在运行这个程序之前,已经正确安装并配置了Java环境、Scala环境以及Apache Spark,并且你的环境变量或者配置文件中没有指向错误的Spark路径。

如果你正在尝试在集群上运行Spark,你需要将masterUrl更改为集群的实际master地址,例如 "spark://your-master-host:7077",其中 your-master-host 是集群主节点的IP地址,7077 是Spark默认的端口号。

此外,确认你的项目依赖是否正确,所有的Scala库应该被正确地包含在构建路径中。如果这是在IDEA中运行,检查你的项目结构中的依赖项,确保它们都已经被正确识别和引用。

如果问题仍然存在,可能需要检查IDEA的配置,确保所有必要的JAR包都已经添加到项目的Classpath中。如果是在命令行中运行,确保你的环境变量设置正确,可以执行 spark-submit 命令,将你的main class作为参数提交给Spark集群。