就是在hdfs HA的搭建中启动进程的时候,主节点master和slave2都是正常的,但是slave1就是一直没有namenode

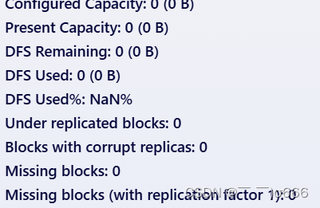

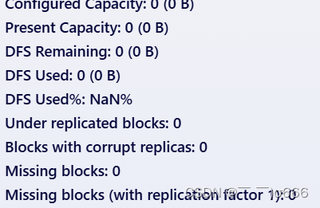

然后我就用这个代码:hdfs dfsadmin -report找了一下,结果显示这样:

这是这么回事,master主机上面都有namenode

就是在hdfs HA的搭建中启动进程的时候,主节点master和slave2都是正常的,但是slave1就是一直没有namenode

然后我就用这个代码:hdfs dfsadmin -report找了一下,结果显示这样:

这是这么回事,master主机上面都有namenode

关注

关注让【道友老李】来帮你解答,本回答参考通义千问大模型编写,并整理提供,如果还有疑问可以点击头像关注,评论或留言在Hadoop的HDFS高可用性(HA)配置中,如果发现某个节点(例如slave1)没有启动NameNode,而其他节点(如master和slave2)均正常运行,这可能是因为多种原因导致的。以下是一些常见问题及解决方法:

确保所有相关配置文件(hdfs-site.xml, core-site.xml, yarn-site.xml等)在所有节点上都是一致且正确的。特别是与HA相关的配置项,比如dfs.nameservices, dfs.ha.namenodes.[nameserviceID], dfs.namenode.rpc-address.[nameserviceID].[namenodeID]等。

假设你的集群名为mycluster,并且你有两个NameNode ID分别为nn1和nn2。那么在hdfs-site.xml中应该有类似如下配置:

<property>

<name>dfs.nameservices</name>

<value>mycluster</value>

</property>

<property>

<name>dfs.ha.namenodes.mycluster</name>

<value>nn1,nn2</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn1</name>

<value>master:8020</value>

</property>

<property>

<name>dfs.namenode.rpc-address.mycluster.nn2</name>

<value>slave2:8020</value>

</property>

确保每个节点上的NameNode角色分配正确。如果slave1被指定为其中一个NameNode但未启动,则检查该节点的日志文件以获取更多信息。

$HADOOP_HOME/logs/目录下。hadoop-hdfs-namenode-<hostname>.log日志文件,寻找任何错误信息或警告。假设slave1的日志显示了一个关于找不到特定配置文件的错误,你需要检查该文件是否存在,并确保路径正确。

确保slave1有足够的资源来启动NameNode进程。有时,内存不足或其他系统资源限制可能导致服务无法启动。

top命令查看CPU和内存使用情况。hadoop-env.sh设置了合适的Java堆大小参数(例如-Xmx和-Xms)。确保按照正确的顺序启动了所有必要的服务。对于HA设置,通常需要先格式化Zookeeper,然后初始化JournalNodes,接着启动Zookeeper服务器,最后启动NameNodes。

# 格式化Zookeeper

hdfs zkfc -formatZK

# 初始化JournalNodes

hdfs namenode -initializeSharedEdits

# 启动Zookeeper

zkServer.sh start

# 启动JournalNodes

hadoop-daemon.sh start journalnode

# 在master上启动第一个NameNode

hadoop-daemon.sh start namenode

# 在slave2上启动第二个NameNode

hadoop-daemon.sh start namenode

确保slave1上的防火墙允许与其他节点通信。特别是端口8020(默认的NameNode RPC端口)和其他必要的端口必须开放。

确保slave1能够通过网络访问到其他节点。可以使用ping或telnet命令测试连通性。

hdfs dfsadmin -report检查你已经使用了hdfs dfsadmin -report命令,这可以帮助你了解集群状态。根据你的截图,确认报告中是否显示slave1的信息。如果没有,说明slave1没有成功加入集群。

根据上述步骤逐一排查问题,通常可以找到并解决问题。如果仍然无法解决,请提供更多的日志信息以便进一步诊断。