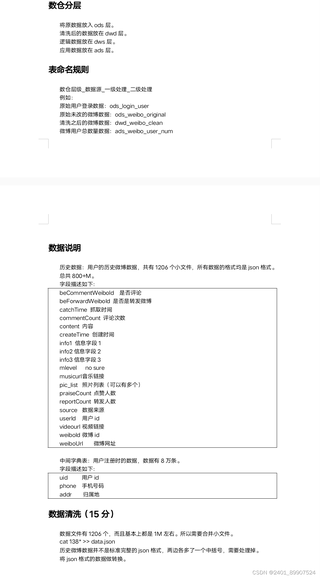

create table ods_weibo(json string);导入数据后如何将其清洗并导入到dwd层

以下回复参考:皆我百晓生、券券喵儿等免费微信小程序作答:

根据你所提供的描述,你的数据清洗任务主要包括合并小文件、处理非标准的json格式以及可能的字段清洗和转换。以下是在Hive中进行数据清洗并导入到DWD层的一般步骤:

ods_weibo的表,并导入了数据。假设这一步已经完成。cat命令或者其他工具来合并这些小文件。例如:cat 138*.json > data.json

请注意,这只是一个简单的示例命令,可能需要根据你的具体文件路径和需求进行调整。 3. 处理非标准的JSON格式: 由于历史微博数据的json格式不是标准的,你需要处理掉两边的中括号。可以使用sed或者其他文本处理工具来完成这个任务。例如:

sed 's/\[//;s/\]//' data.json > cleaned_data.json

这会删除每行开始和结束的[和]。你可能需要根据实际情况调整这个命令。

4. 数据清洗和转换:

在Hive中,你可以使用SQL语句进行数据清洗和转换。例如,你可以使用REPLACE函数来删除不需要的字符,使用CAST来转换数据类型等。对于更复杂的清洗和转换任务,可能需要编写更复杂的Hive SQL语句或使用UDFs(用户定义的函数)。

5. 创建DWD层表并导入清洗后的数据:

完成数据清洗后,你可以在Hive中创建一个新的DWD层表(例如dwd_weibo_clean),并将清洗后的数据导入到这个新表中。你可以使用INSERT INTO TABLE语句或者LOAD DATA命令来完成这个任务。

6. 验证数据:

在将数据从ODS层移动到DWD层之前,确保验证数据的完整性和准确性。检查数据是否按照预期进行了清洗和转换。

请注意,上述步骤是基于你提供的信息和我对Hive和数据处理的理解。在实际操作中,可能需要根据具体情况进行调整和优化。另外,确保在进行任何数据处理操作之前备份原始数据。