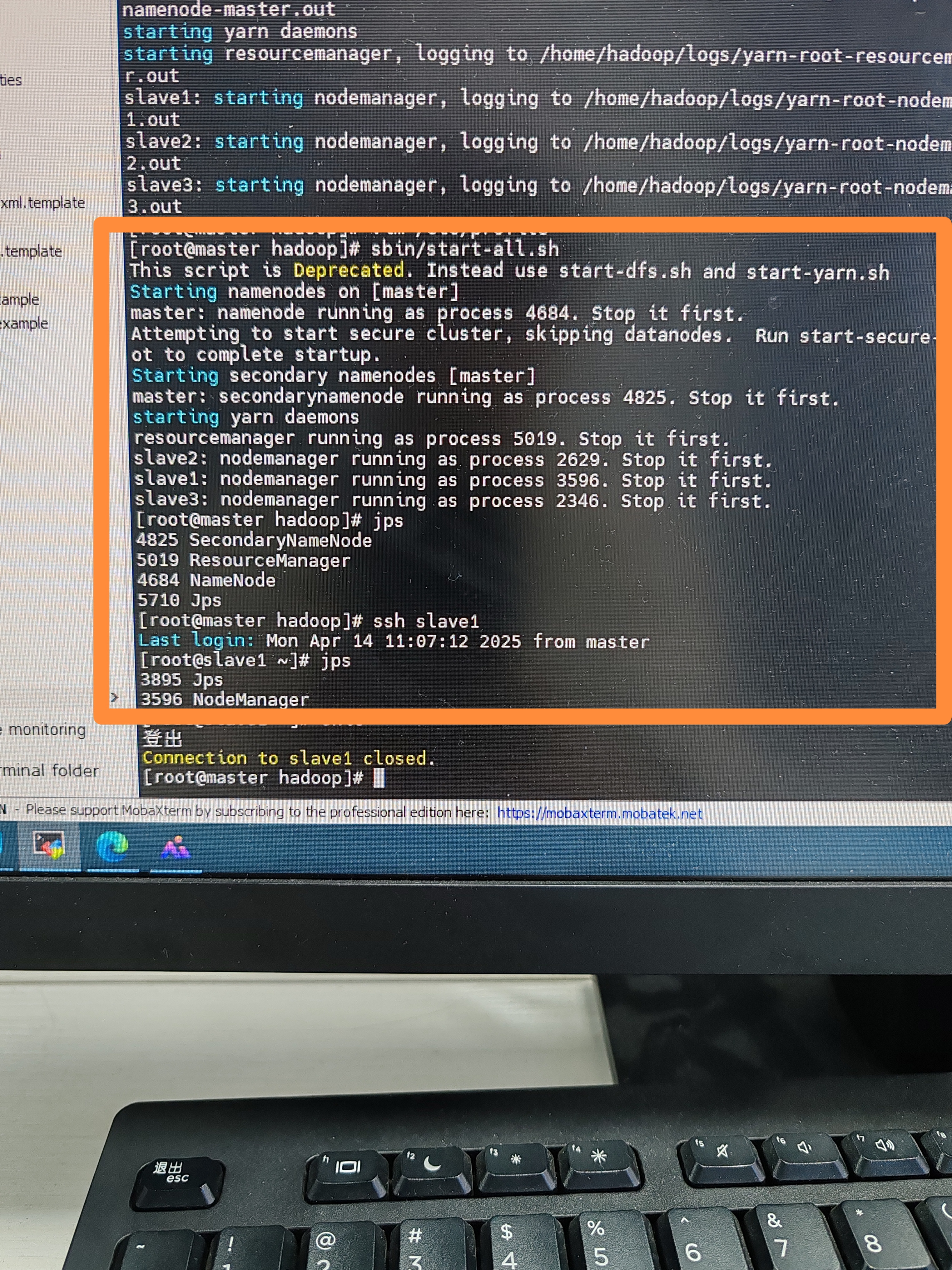

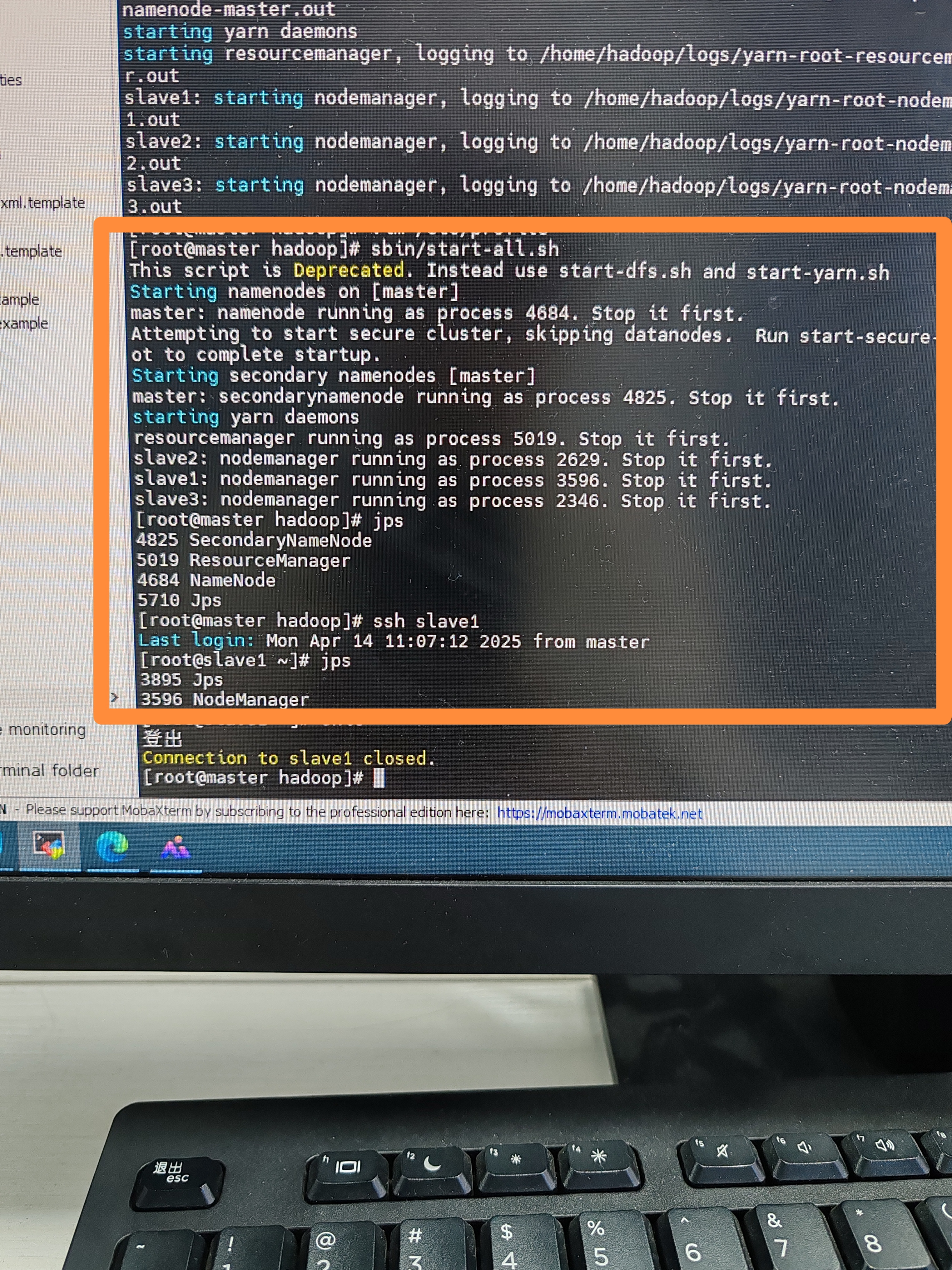

hadoop启动 从节点slave1 2 3没有datanode这个东西 求各位解答 谢谢

关注

关注让 “紫雾凌寒” 来帮你回答,本回答结合 DeepSeek

如果还有问题,请评论或点击头像私信,如果有帮助到您, 请关注、采纳、点赞

hdfs-site.xml配置文件:hdfs-site.xml中正确配置了DataNode的数据存储目录。例如:<configuration>

<property>

<name>dfs.datanode.data.dir</name>

<value>/data/hadoop/datanode</value>

</property>

</configuration>

- 检查`dfs.namenode.secondary.http-address`等相关配置是否正确,与NameNode和SecondaryNameNode的通信配置有关。

/etc/hosts文件中,主机名和IP地址的映射正确。例如:192.168.1.100 namenode

192.168.1.101 slave1

192.168.1.102 slave2

192.168.1.103 slave3

$HADOOP_LOG_DIR目录下查看DataNode的日志文件(通常是hadoop-hdfs-datanode-slaveX.log),例如在/var/log/hadoop-hdfs/目录下。日志中可能会有启动失败的原因提示,如权限问题、网络问题等。systemctl stop firewalld

systemctl disable firewalld

$HADOOP_HOME/sbin/hadoop-daemon.sh start datanode

希望以上解答对您有所帮助。如果您有任何疑问,欢迎在评论区提出。