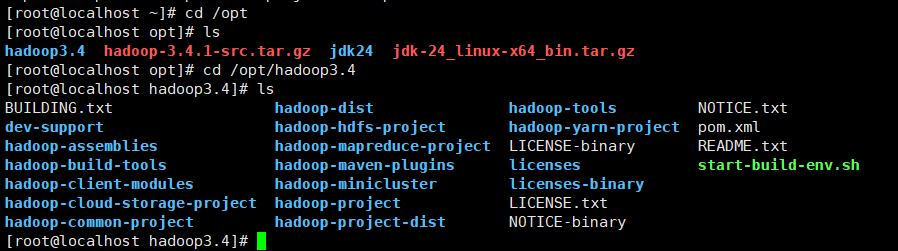

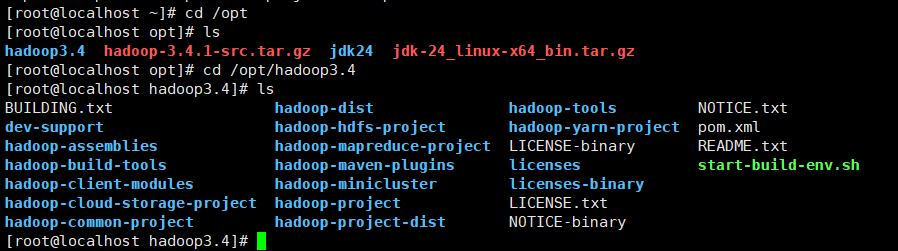

我想请问一下我在尝试做hadoop伪分布式安装的过程中遇到了个问题,我不确定我应该修改哪个配置文件,包括core-site.xml,hadoop-env.sh,hadfs-site.xml,我查看hadoop的根目录的时候发现没有/etc/hadoop的文件夹,我用的虚拟机是centOS10,hadoop的版本是3.4.1,jdk的版本是24

我想请问一下我在尝试做hadoop伪分布式安装的过程中遇到了个问题,我不确定我应该修改哪个配置文件,包括core-site.xml,hadoop-env.sh,hadfs-site.xml,我查看hadoop的根目录的时候发现没有/etc/hadoop的文件夹,我用的虚拟机是centOS10,hadoop的版本是3.4.1,jdk的版本是24

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

你遇到的问题是关于 Hadoop 伪分布式安装的配置问题,具体来说是关于 core-site.xml、hadoop-env.sh 和 hdfs-site.xml 文件的修改。

在 Hadoop 伪分布式安装中,我们需要修改这些配置文件来指定 Hadoop 的运行环境和配置。下面是一些常见的修改项:

core-site.xml:在这个文件中,我们可以指定 Hadoop 的名称节点和数据节点的主机名和端口号。hadoop-env.sh:在这个文件中,我们可以指定 Hadoop 的 Java 版本和其他环境变量。hdfs-site.xml:在这个文件中,我们可以指定 HDFS 的配置项,例如数据块大小、replicationFactor 等。在你遇到的问题中,你可能需要修改这些配置文件来指定 Hadoop 的运行环境和配置。例如,如果你想指定名称节点的主机名和端口号,可以在 core-site.xml 文件中添加以下配置:

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

如果你需要指定数据块大小,可以在 hdfs-site.xml 文件中添加以下配置:

<property>

<name>dfs.block.size</name>

<value>67108864</value>

</property>

在修改配置文件后,你需要重新启动 Hadoop 服务来生效这些修改。

如果你遇到了其他问题或需要更多帮助,请提供更多的信息和错误日志,我将尽力帮助你解决问题。