Flink 1.19.2 Hive3.1.3 通过Flink SQL建表出现java包报错

通过linux不同用户环境变量配置,Flink为jdk11,hive jdk8 Hive可以正常建库建表,

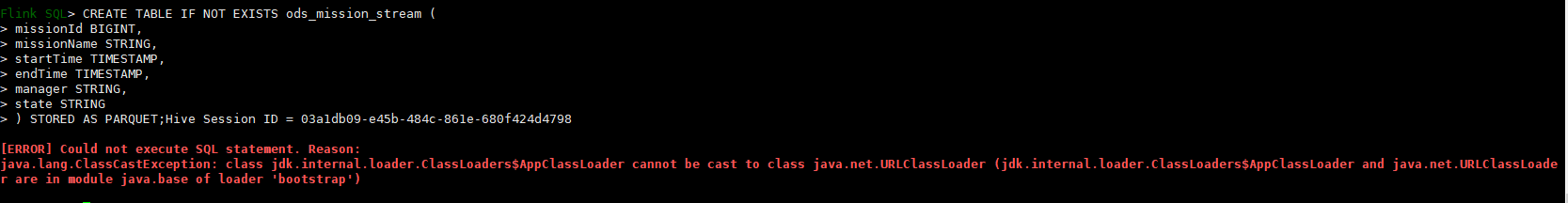

但是在Flink SQL客户端内执行语句报如下错误

could not execute sql statement. reason: java.lang.classcastexception: class jdk.internal.loader.classloaders$appclassloader cannot be cast to class java.net.urlclassloader (jdk.internal.loader.classloaders$appclassloader and java.net.urlclassloader are in module java.base of loader 'bootstrap')

已经成功配置了hive catalog并且在Flink SQL内切换到注册库了,执行语句前切换到了hive方言,如下为建表语句

CREATE TABLE IF NOT EXISTS ods_mission_stream (

missionId BIGINT,

missionName STRING,

startTime TIMESTAMP,

endTime TIMESTAMP,

manager STRING,

state STRING

) STORED AS PARQUET;