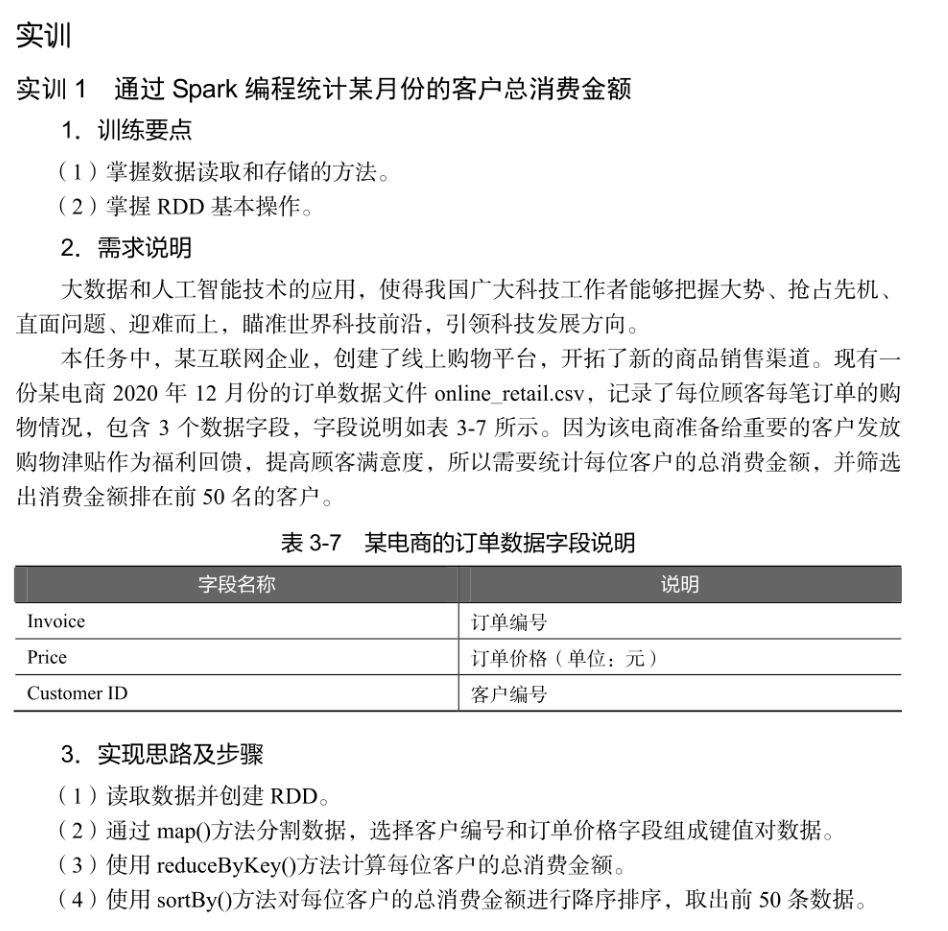

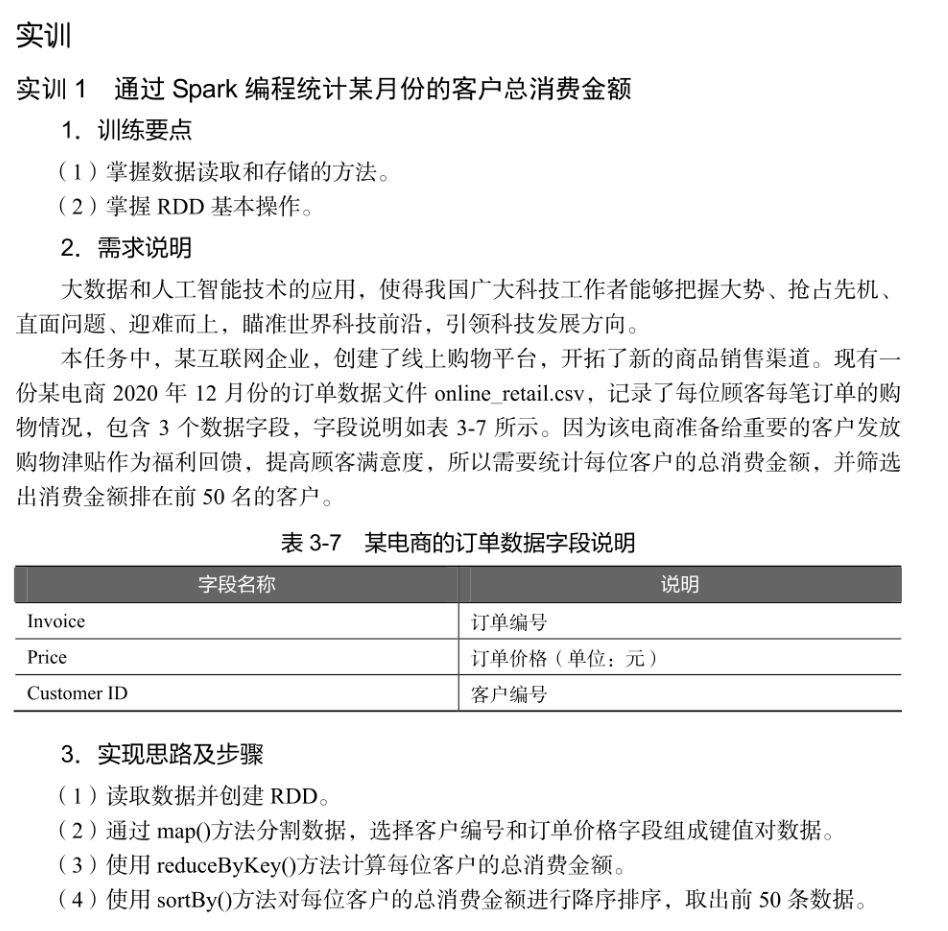

如何使用spark编程来实现这个问题呢?

使用map(),reduceByKey(),sortBy()方法来实现。

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

Spark 提供了一个强大的数据处理引擎,可以使用 Scala 语言来编写 Spark 程序来实现数据处理任务。

根据你的问题,使用 map(), reduceByKey() 和 sortBy() 方法可以实现数据处理任务。下面是一个简单的示例代码:

import org.apache.spark.SparkContext

import org.apache.spark.rdd.RDD

object SparkExample {

def main(args: Array[String]) {

val sc = new SparkContext("local", "example")

val data = Array((1, "a"), (2, "b"), (3, "c"), (4, "d"), (5, "e"))

val rdd = sc.parallelize(data)

// 使用 map() 方法将数据转换为大写

val upperCaseData = rdd.map { case (id, value) => (id, value.toUpperCase) }

// 使用 reduceByKey() 方法将数据聚合

val aggregatedData = upperCaseData.reduceByKey { _ + _ }

// 使用 sortBy() 方法对数据进行排序

val sortedData = aggregatedData.sortBy { case (id, value) => id }

sortedData.foreach(println)

}

}

这个示例代码使用 Spark 创建了一个 RDD,然后使用 map() 方法将数据转换为大写,使用 reduceByKey() 方法将数据聚合,最后使用 sortBy() 方法对数据进行排序。最后,使用 foreach() 方法将结果打印出来。

这个示例代码可以帮助你理解如何使用 Spark 的基本方法来实现数据处理任务。