求能够帮我解决这个问题,谢谢大家了,求专家解决指导,谢谢了,已困扰我好久了

关注

关注让【宝码香车】来帮你解答,本回答参考DeepSeek编写,并整理提供。

如果还有疑问可以点击头像关注私信或评论。如果答案让您满意,请采纳、点赞、关注,非常感谢!

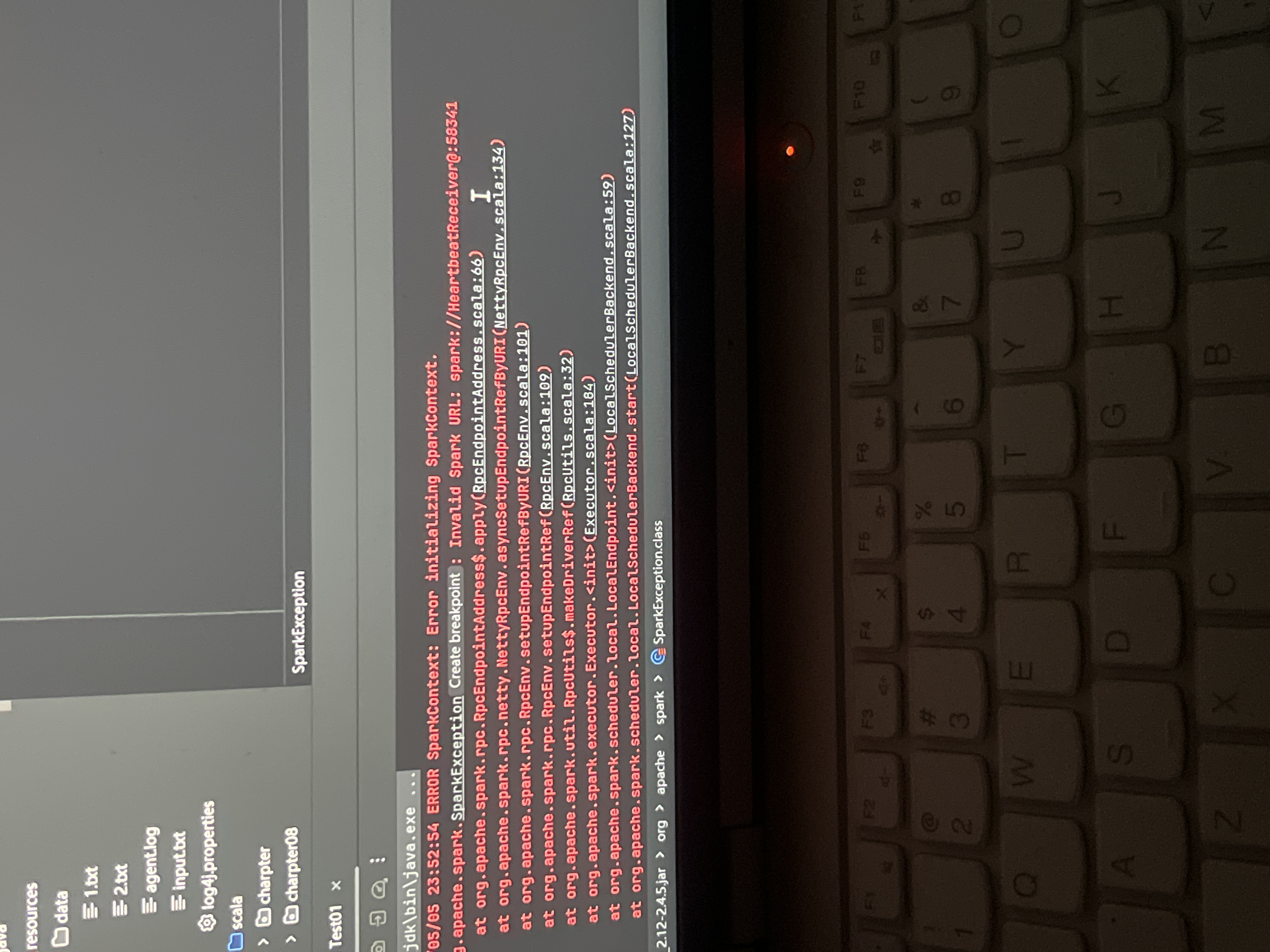

根据您提供的错误信息和描述,这是一个典型的Spark环境配置问题,通常发生在电脑重启后Spark无法正常启动。以下是可能的原因和解决方案:

Spark依赖JAVA_HOME和SPARK_HOME环境变量,重启后这些变量可能丢失。

# 永久设置环境变量(Linux/macOS)

echo 'export JAVA_HOME=/path/to/your/jdk' >> ~/.bashrc

echo 'export SPARK_HOME=/path/to/your/spark' >> ~/.bashrc

echo 'export PATH=$PATH:$SPARK_HOME/bin:$JAVA_HOME/bin' >> ~/.bashrc

source ~/.bashrc

# Windows系统 - 通过系统属性->高级->环境变量设置

Spark在运行时会产生临时文件,重启后这些文件可能被清除。

# 清理并重新创建Spark临时目录

rm -rf /tmp/spark-*

错误信息中提到的RPC通信问题通常与主机名解析有关。

# 确保/etc/hosts包含正确的主机名映射

127.0.0.1 localhost your-computer-name

::1 localhost your-computer-name

编辑$SPARK_HOME/conf/spark-env.sh文件(如果没有则复制模板):

# 示例配置

export SPARK_LOCAL_IP=127.0.0.1

export SPARK_MASTER_HOST=127.0.0.1

export SPARK_PUBLIC_DNS=localhost

查看Spark日志可以获取更详细的错误信息:

tail -n 100 $SPARK_HOME/logs/spark--org.apache.spark.deploy.master.Master-*.out

java -version如果以上方法都不能解决您的问题,请提供:

这样我可以提供更有针对性的解决方案。