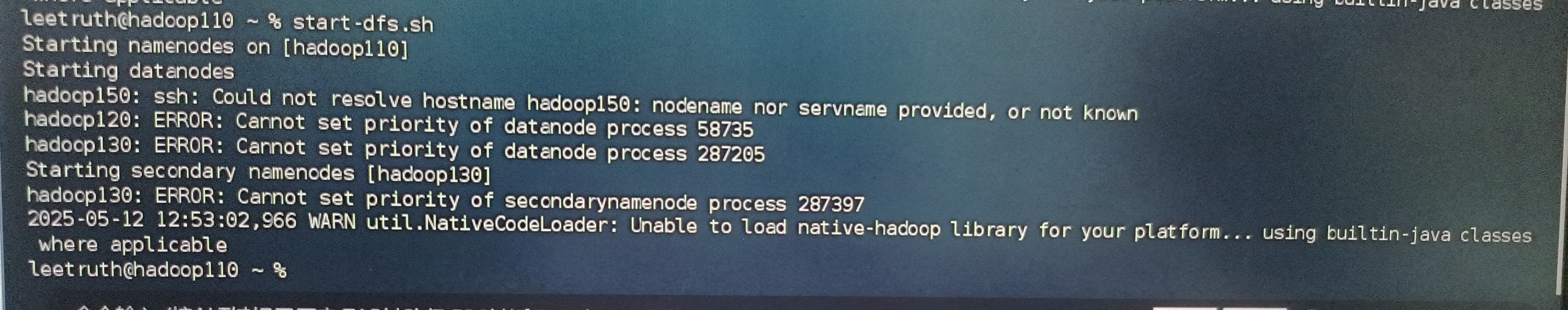

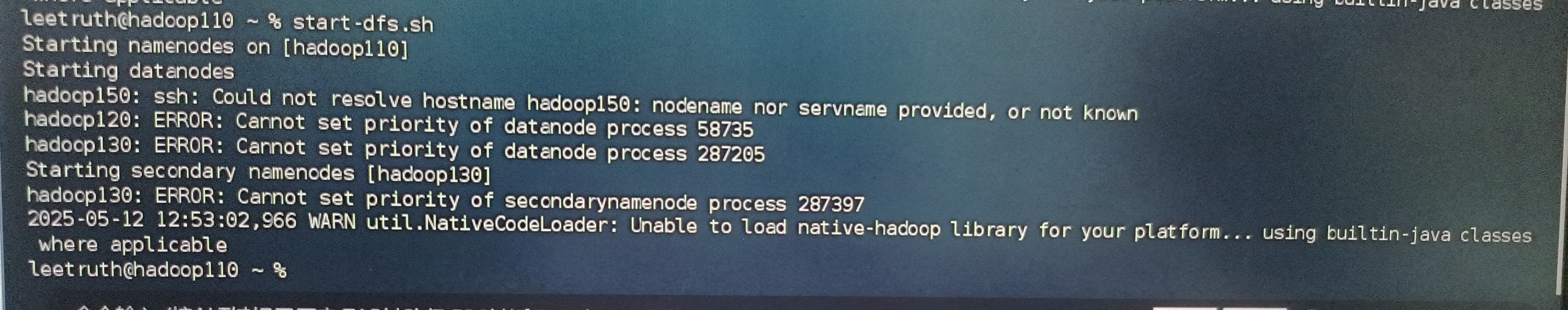

请问大家:macOS系统的Linux,hadoop110为主机,hadoop120和hadoop130进程有问题,修改了120和130的hadoop-env.sh的相关权限还是不行

请问大家:macOS系统的Linux,hadoop110为主机,hadoop120和hadoop130进程有问题,修改了120和130的hadoop-env.sh的相关权限还是不行

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

你遇到的问题是,macOS下Linux环境下HDFS进程权限问题,具体来说是hadoop110主机的hadoop120和hadoop130进程权限问题。

解决方案:

chmod 644 /usr/local/hadoop/etc/hadoop/hadoop-env.sh

cat /usr/local/hadoop/etc/hadoop/hadoop-env.sh

ps命令检查hadoop进程的权限,确保进程的用户和组正确。ps -ef | grep hadoop

sudo /usr/local/hadoop/bin/start-dfs.sh

cat /usr/local/hadoop/logs/hadoop-hdfs-namenode.log

如果以上步骤都无法解决问题,可以尝试重新安装hadoop或 seek help from Hadoop community。