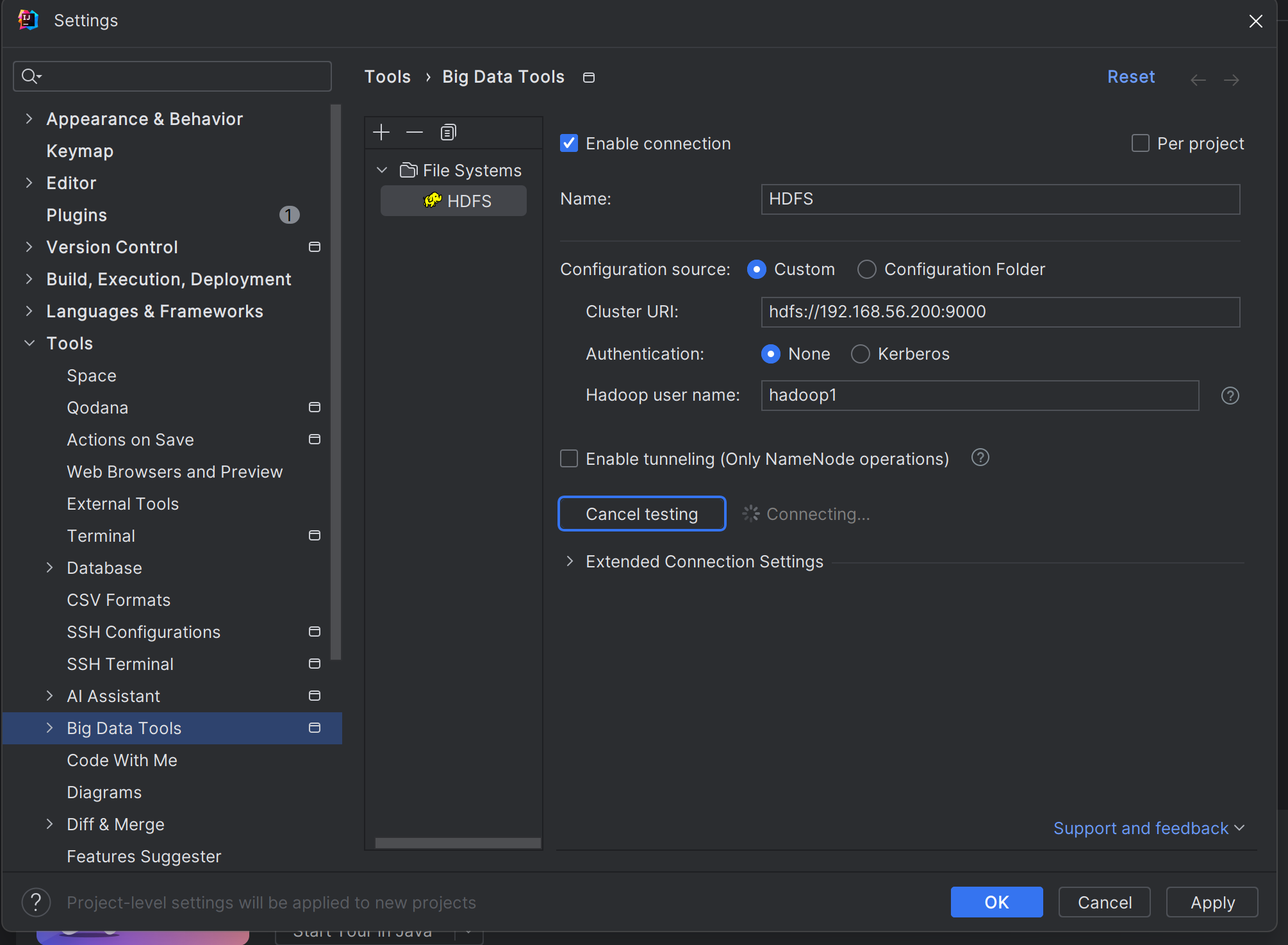

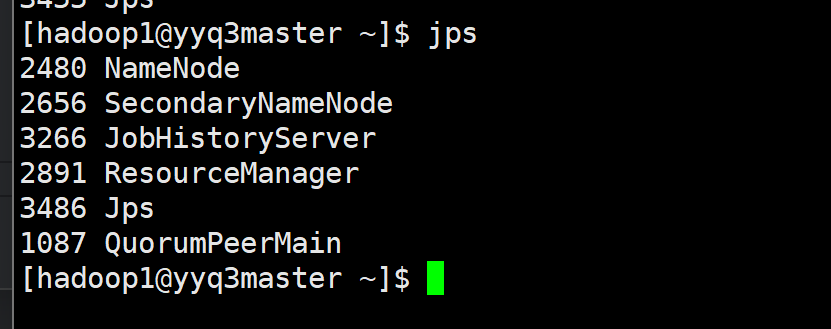

九敏啊,为什么hadoop集群开启了但是idea一直显示连接状态就是连不上呢,九敏

上午好☀️☀️☀️️

本答案参考通义千问

在使用 IntelliJ IDEA 连接 Hadoop 集群时,如果集群已经启动但 IDEA 无法成功连接到 HDFS,可能是由于以下几个原因导致的。以下是可能的原因及解决方案:

Hadoop 需要正确的配置文件来支持客户端访问。IDEA 使用 Hadoop 的配置文件(如 core-site.xml 和 hdfs-site.xml)来连接集群。

解决方案:

core-site.xml 和 hdfs-site.xml 文件放在项目的 src/main/resources 或 resources 目录下。<!-- core-site.xml -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://<namenode-host>:<namenode-port></value>

</property>

</configuration>

<!-- hdfs-site.xml -->

<configuration>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

确保 IDEA 所在机器能够与 Hadoop 集群的 NameNode 和 DataNodes 正常通信。

解决方案:

ping 命令检查是否能访问 NameNode 的 IP 地址。telnet <namenode-host> <namenode-port> 测试端口是否开放。IDEA 需要正确的 Hadoop 客户端库才能连接到集群。

解决方案:

<dependency>

<groupId>org.apache.hadoop</groupId>

<artifactId>hadoop-client</artifactId>

<version>3.x.x</version>

</dependency>

implementation 'org.apache.hadoop:hadoop-client:3.x.x'

如果集群启用了 Kerberos 认证,需要在 IDEA 中配置相应的认证信息。

解决方案:

krb5.conf 文件并将其放在项目资源目录下。查看 IDEA 控制台输出或 Hadoop 的日志文件,定位具体的错误信息。

解决方案:

/var/log/hadoop/ 下),确认是否有异常。如果使用了特定的插件(如 Hadoop Tools for IntelliJ IDEA),确保插件已正确安装并配置。

解决方案:

以下是一个简单的 Java 示例代码,用于测试 HDFS 连接:

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FileSystem;

import java.net.URI;

public class HDFSTest {

public static void main(String[] args) throws Exception {

// 加载 Hadoop 配置

Configuration conf = new Configuration();

conf.addResource("core-site.xml");

conf.addResource("hdfs-site.xml");

// 创建 FileSystem 实例

FileSystem fs = FileSystem.get(URI.create("hdfs://<namenode-host>:<namenode-port>"), conf);

// 测试文件系统是否可用

System.out.println("HDFS is connected: " + fs.exists(new org.apache.hadoop.fs.Path("/")));

// 关闭连接

fs.close();

}

}

注意:

<namenode-host> 和 <namenode-port> 为实际的 NameNode 地址和端口。core-site.xml 和 hdfs-site.xml 文件在类路径中。按照上述步骤逐一排查问题,可以有效解决 IDEA 无法连接 Hadoop 集群的问题。如果仍然无法解决,请提供更详细的错误信息以便进一步分析。