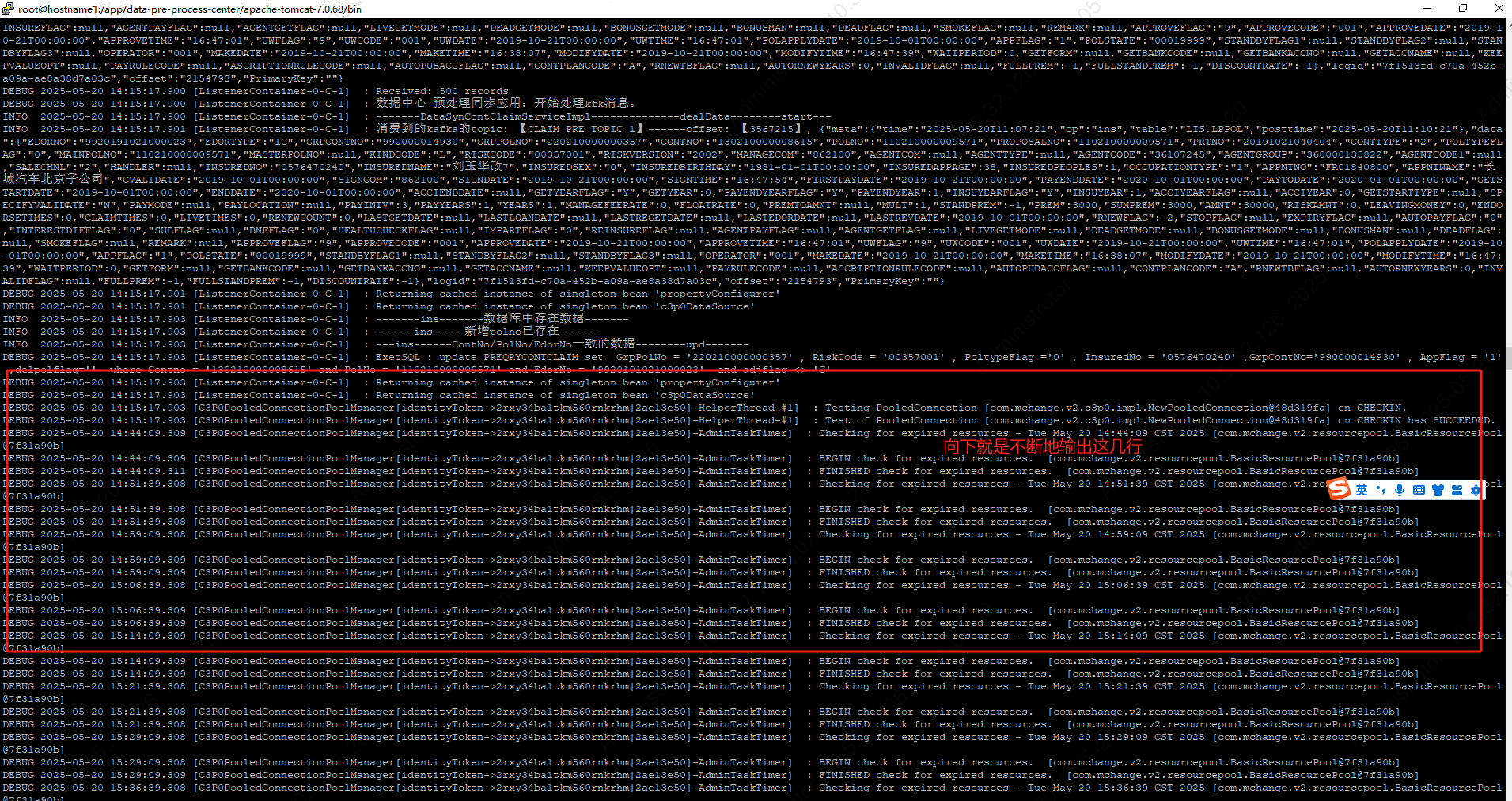

服务且接收kafka消息,业务处理后,sql语句修改失败,服务器一直刷新: BEGIN check for expired resources.

FINISHED check for expired resources. [com.mchange.v2.resourcepool.BasicResourcePool@7f31a90b]

Checking for expired resources - Tue May 20 17:14:09 CST 2025 [com.mchange.v2.resourcepool.BasicResourcePool,重启服务会输出大量的同步数据之后就没有任何日

志输出。kafka消费消息的日志也不再输出,像是卡在哪里这是什么原因,怎么解决?