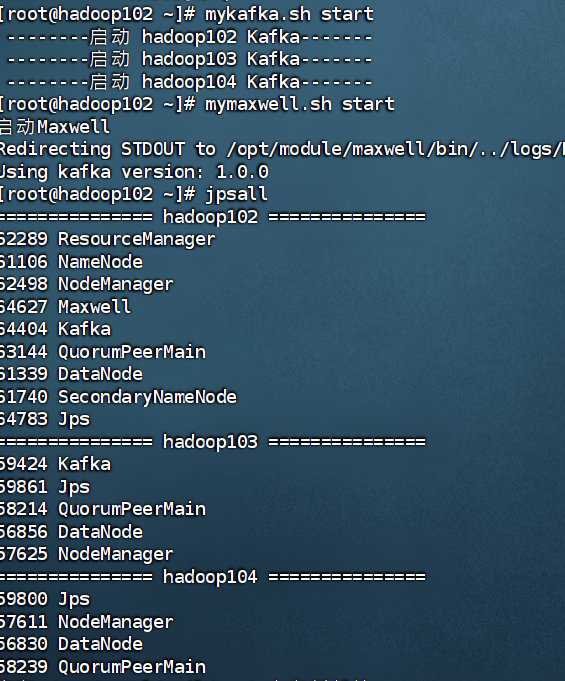

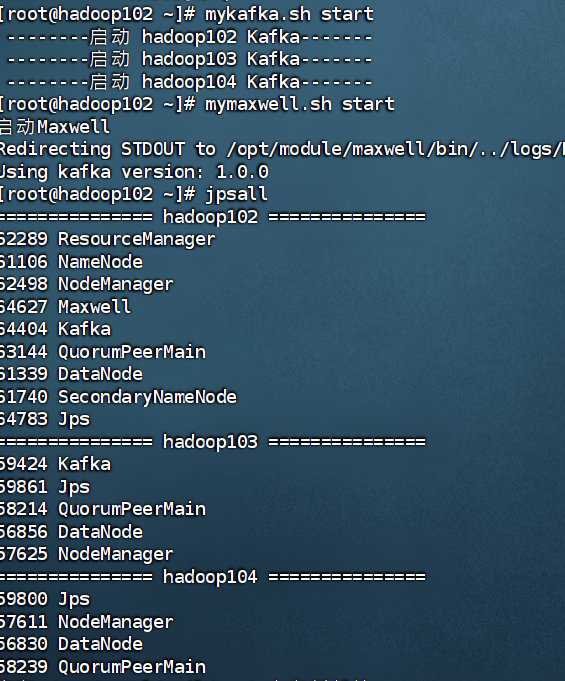

增量数据,flume通道测试时kafka开启遇到问题,启动hadoop102的flume时一直在执行

增量数据,flume通道测试时kafka开启遇到问题,启动hadoop102的flume时一直在执行

上午好☀️☀️☀️️

本答案参考通义千问

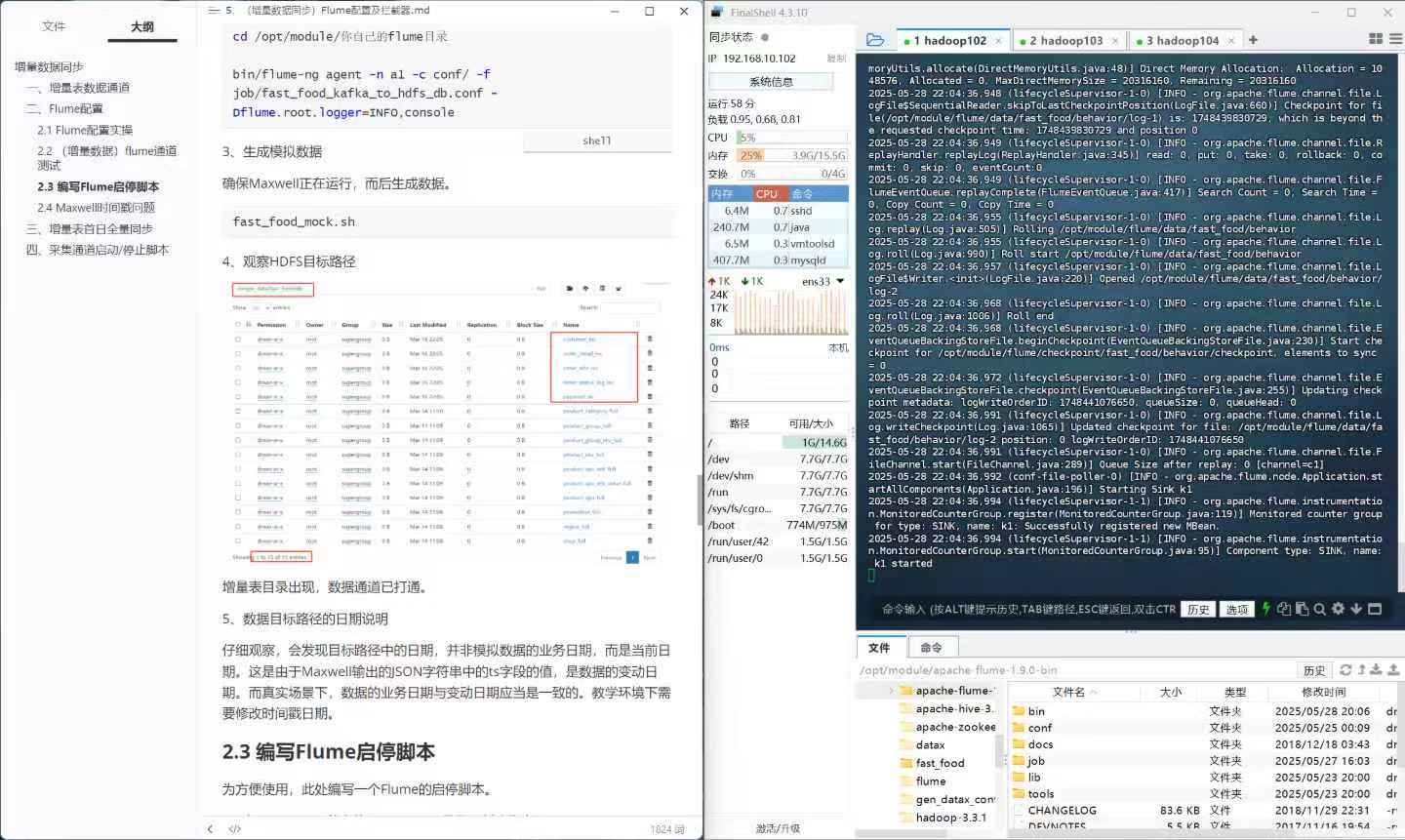

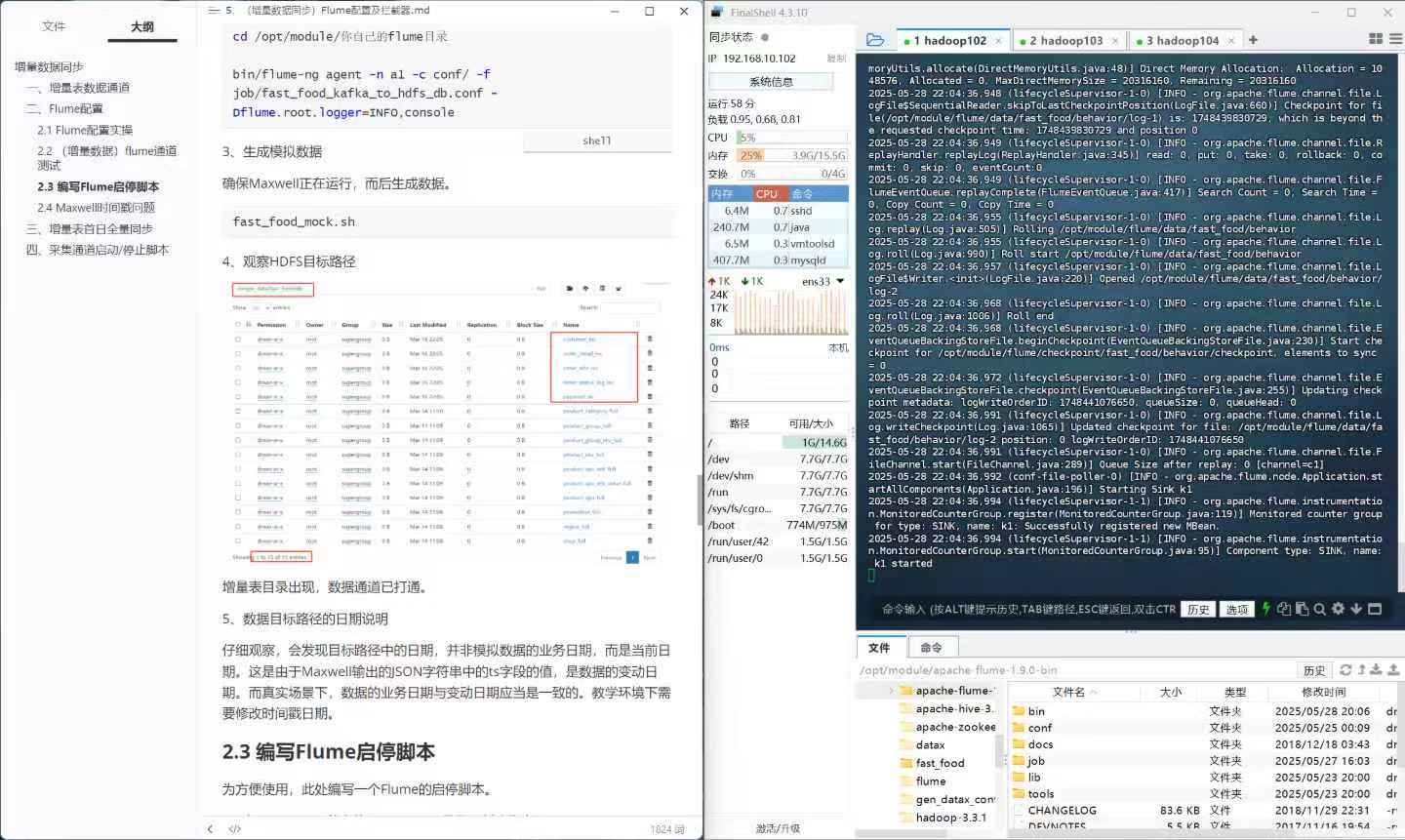

从你的描述来看,你在使用 Flume 和 Kafka 进行增量数据传输时遇到了问题,Flume 启动后一直处于运行状态但没有正常完成任务或输出日志。以下是可能的原因及解决方案:

Kafka 配置问题

Flume 配置文件问题

topic、batch-size 等)设置不当。权限问题

依赖问题

日志问题

确保 Kafka 的 Broker 地址和 Topic 名称正确:

kafka.bootstrap.servers 是否指向正确的 Kafka Broker 地址(如 hadoop102:9092)。修改后的配置示例:

# Flume 配置文件

agent.sources = kafkaSource

agent.channels = memoryChannel

agent.sinks = kafkaSink

# Source 配置

agent.sources.kafkaSource.type = org.apache.flume.source.kafka.KafkaSource

agent.sources.kafkaSource.kafka.bootstrap.servers = hadoop102:9092

agent.sources.kafkaSource.kafka.topics = test-topic

agent.sources.kafkaSource.kafka.consumer.group.id = flume-consumer-group

# Channel 配置

agent.channels.memoryChannel.type = memory

agent.channels.memoryChannel.capacity = 1000

agent.channels.memoryChannel.transactionCapacity = 100

# Sink 配置

agent.sinks.kafkaSink.type = org.apache.flume.sink.kafka.KafkaSink

agent.sinks.kafkaSink.kafka.bootstrap.servers = hadoop102:9092

agent.sinks.kafkaSink.topic = test-topic

Flume 启动时会生成日志文件,通常位于 logs 目录下。查看日志文件可以找到具体的错误信息:

tail -f /path/to/flume/logs/flume.log

根据日志中的错误提示进行排查。

确保 Kafka 集群已正常启动:

# 查看 Kafka Broker 状态

kafka-topics.sh --bootstrap-server hadoop102:9092 --list

# 创建 Topic(如果需要)

kafka-topics.sh --create --bootstrap-server hadoop102:9092 --replication-factor 1 --partitions 1 --topic test-topic

如果 Flume 使用了 Kerberos 或其他安全认证机制,确保 Flume 的运行用户具有访问 Kafka 和 HDFS 的权限:

示例配置:

agent.sources.kafkaSource.kafka.security.protocol = SASL_PLAINTEXT

agent.sources.kafkaSource.kafka.sasl.mechanism = PLAIN

agent.sources.kafkaSource.kafka.sasl.jaas.config = org.apache.kafka.common.security.plain.PlainLoginModule required username="flume" password="password";

可以通过简单的测试验证 Flume 和 Kafka 的集成是否正常:

# 向 Kafka 写入测试消息

kafka-console-producer.sh --broker-list hadoop102:9092 --topic test-topic

> Hello, Kafka!

# 在 Flume 中消费 Kafka 消息

kafka-console-consumer.sh --bootstrap-server hadoop102:9092 --topic test-topic --from-beginning

如果 Flume 的 batch-size 设置过小,可能会导致性能瓶颈。可以根据实际情况调整:

agent.sinks.kafkaSink.batch-size = 100

通过以上步骤,你应该能够定位并解决 Flume 和 Kafka 集成的问题。如果问题仍未解决,请提供更多日志信息或配置细节,我可以进一步帮助你分析。