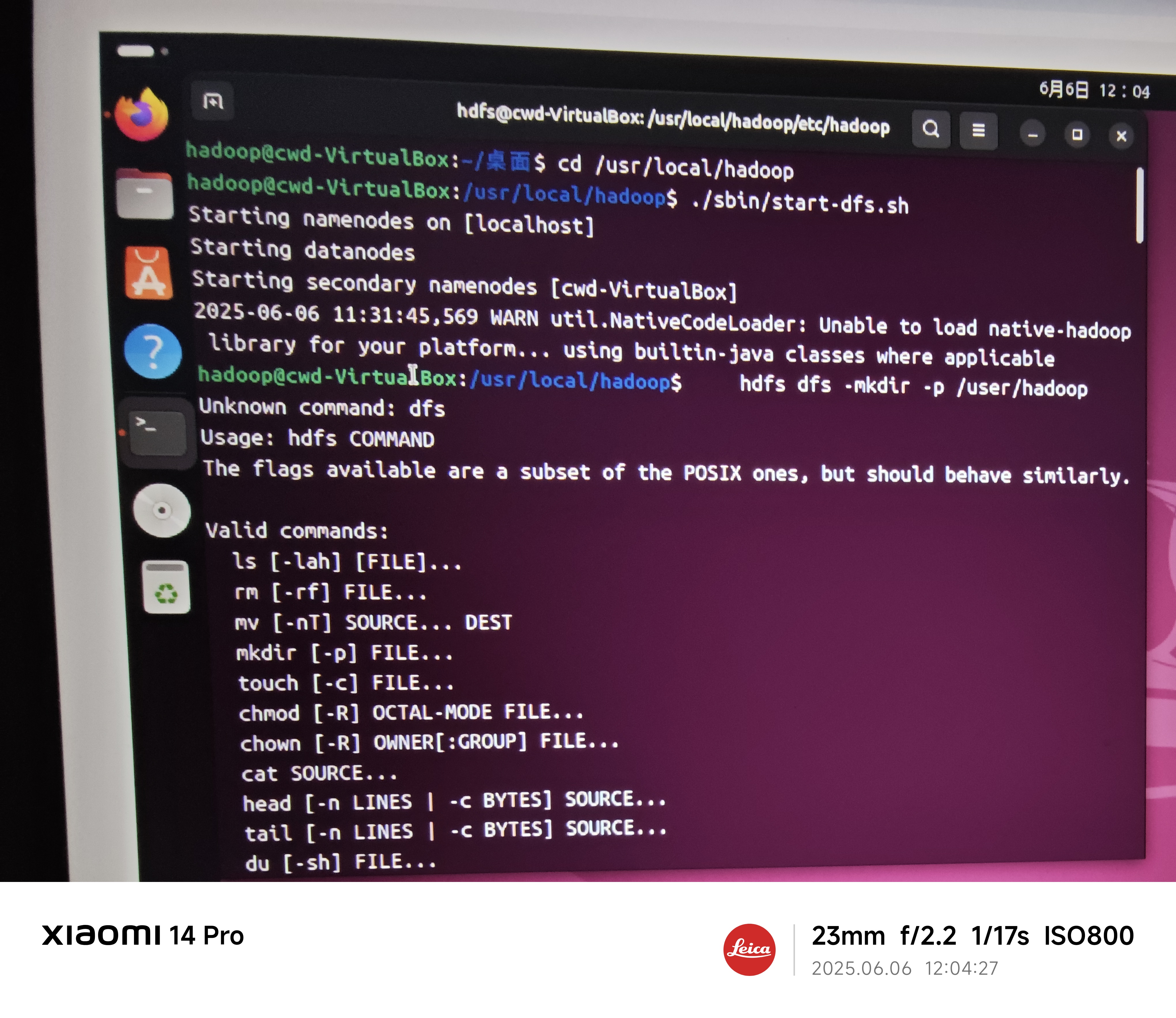

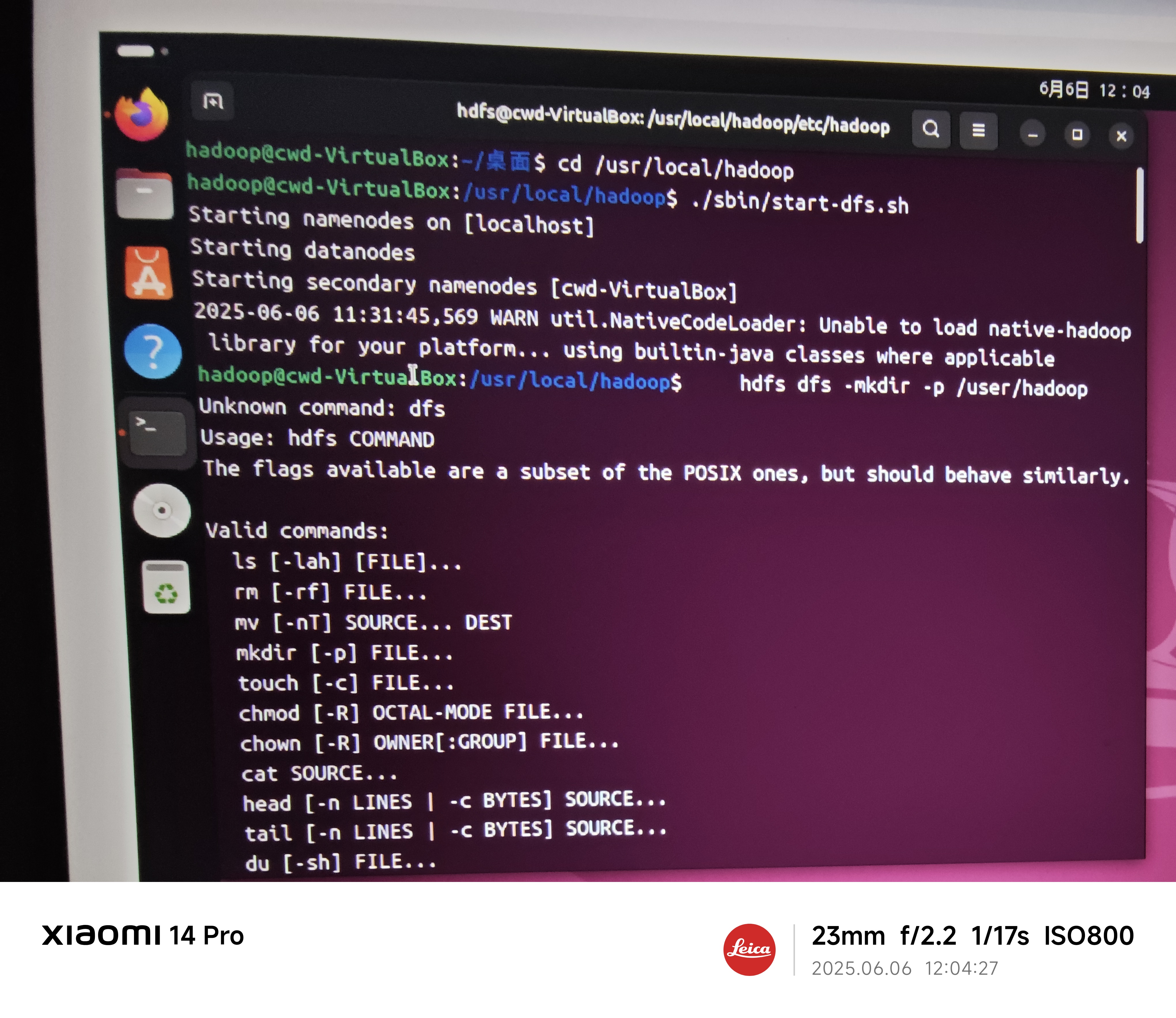

为什么明明启动hadoop了,可是hdfs后面操作进行不了,如何才能把本地文件系统中的文件传到分布式文件系统hdfs中

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

你遇到的问题可能是因为 HDFS dfs 操作需要在 Hadoop 集群中启动 HDFS 服务,而你可能只是启动了 Hadoop 集群,但是没有启动 HDFS 服务。

解决方案:

hadoop dfsadmin -report 命令来检查 HDFS 服务是否已经启动。hadoop dfs -format 命令来格式化 HDFS,然后启动 HDFS 服务。另外,如果你想将本地文件系统中的文件传到 HDFS 中,可以使用 hadoop fs -put 命令,例如:

hadoop fs -put /path/to/local/file /path/to/hdfs/directory

这将将本地文件 /path/to/local/file 传到 HDFS 目录 /path/to/hdfs/directory 中。

如果你想将整个目录传到 HDFS 中,可以使用 -d 选项,例如:

hadoop fs -put -d /path/to/local/directory /path/to/hdfs/directory

这将将整个目录 /path/to/local/directory 传到 HDFS 目录 /path/to/hdfs/directory 中。