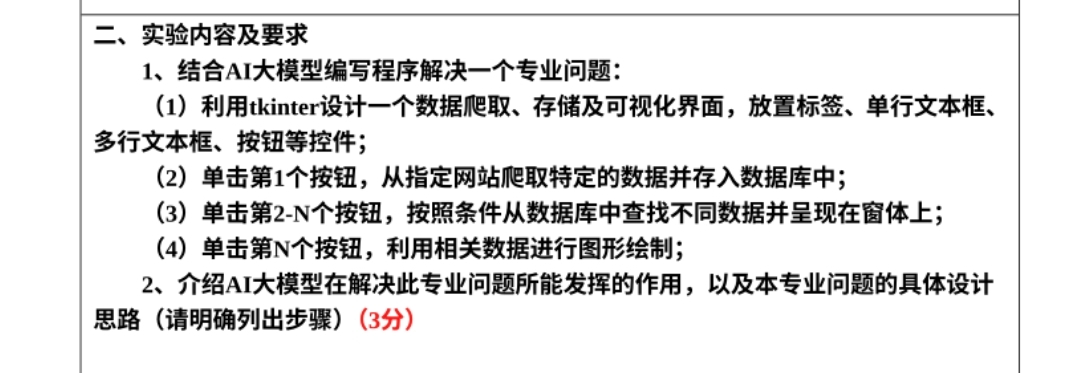

布置的任务,不知道该怎么写啊啊,爬网站也不知道爬什么数据,怎么爬

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

你想爬虫可视化数据库结合,但是你不确定如何爬取数据和写代码。下面是一个简单的解决方案:

import scrapy

class MySpider(scrapy.Spider):

name = "my_spider"

start_urls = [

'https://example.com',

]

def parse(self, response):

# 提取数据

title = response.css('title::text').get()

author = response.css('meta[name="author"]::attr(content)').get()

content = response.css('div.content::text').get()

# ...

yield {

'title': title,

'author': author,

'content': content,

# ...

}

import sqlite3

class MyPipeline:

def __init__(self):

self.conn = sqlite3.connect('my_database.db')

self.cursor = self.conn.cursor()

def process_item(self, item, spider):

self.cursor.execute('INSERT INTO my_table (title, author, content) VALUES (?, ?, ?)',

(item['title'], item['author'], item['content']))

self.conn.commit()

return item

以下是一个简单的示例代码,使用Scrapy爬取数据,然后将数据存储到SQLite数据库:

import scrapy

import sqlite3

class MySpider(scrapy.Spider):

name = "my_spider"

start_urls = [

'https://example.com',

]

def parse(self, response):

# 提取数据

title = response.css('title::text').get()

author = response.css('meta[name="author"]::attr(content)').get()

content = response.css('div.content::text').get()

# ...

yield {

'title': title,

'author': author,

'content': content,

# ...

}

class MyPipeline:

def __init__(self):

self.conn = sqlite3.connect('my_database.db')

self.cursor = self.conn.cursor()

def process_item(self, item, spider):

self.cursor.execute('INSERT INTO my_table (title, author, content) VALUES (?, ?, ?)',

(item['title'], item['author'], item['content']))

self.conn.commit()

return item

# 创建爬虫对象

spider = MySpider()

# 创建pipeline对象

pipeline = MyPipeline()

# 爬虫爬取数据

spider.crawl()

# 将爬虫数据存储到数据库

pipeline.process_item(spider, spider)

爬虫可视化数据库结合需要你确定爬取数据的目标,然后选择爬虫框架,编写爬虫代码,存储爬虫数据到数据库,最后使用可视化库来可视化数据库中的数据。