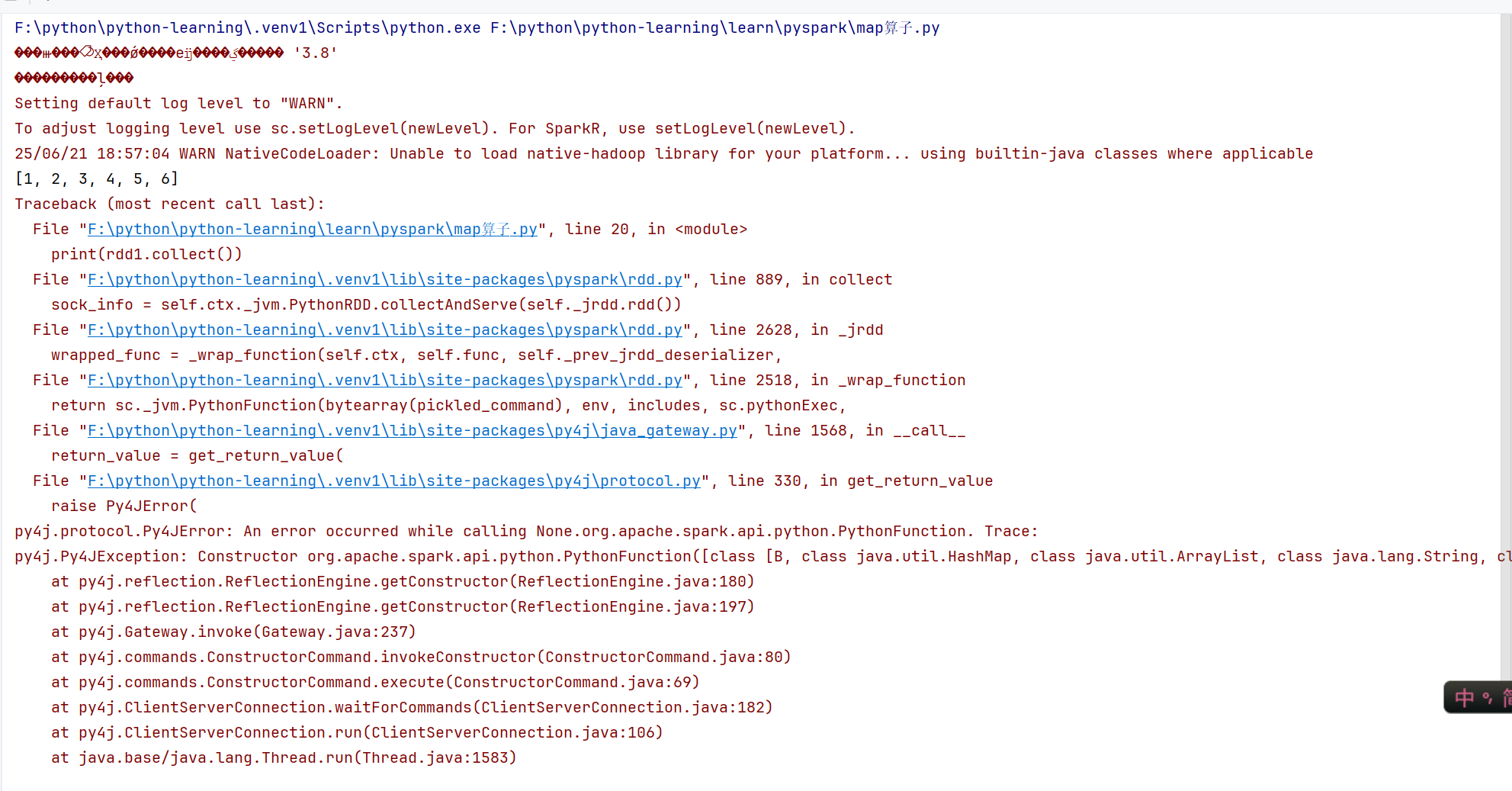

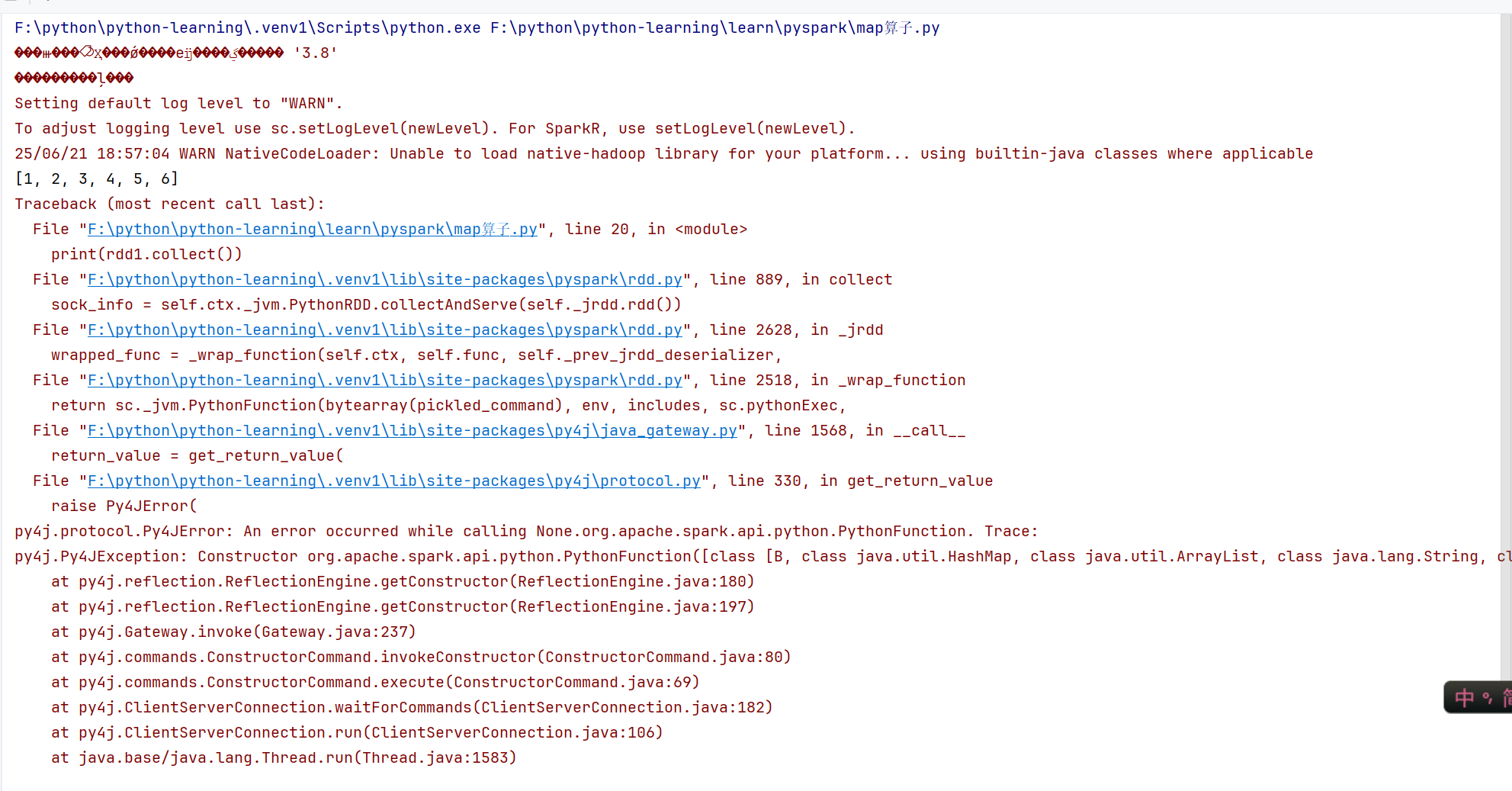

最近在学pyspark 在使用map算子(如图一)的时候 一直报错꒰>﹏< ꒱ (错误类型如图二)

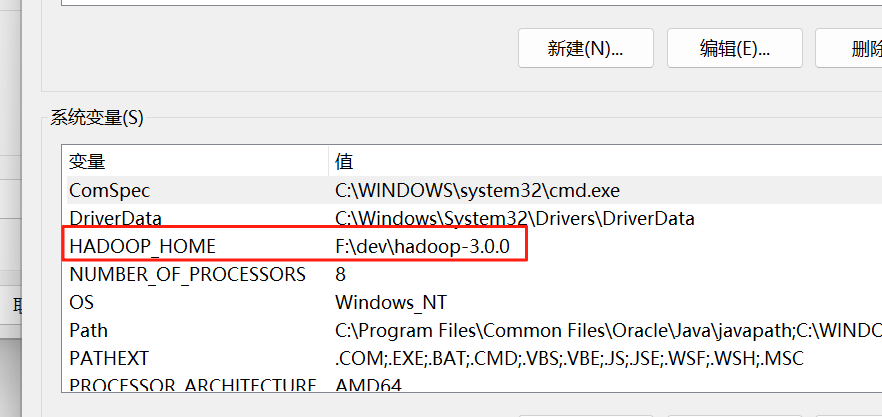

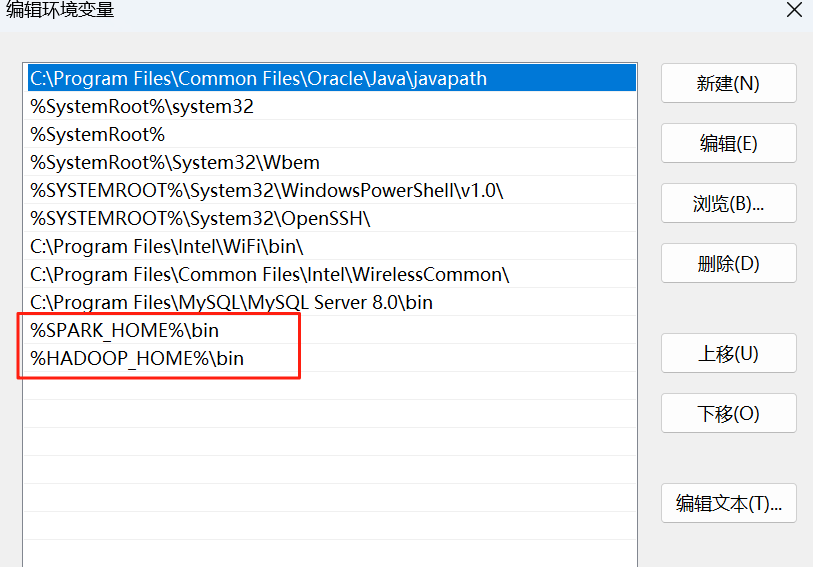

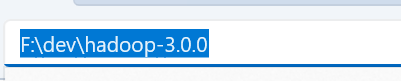

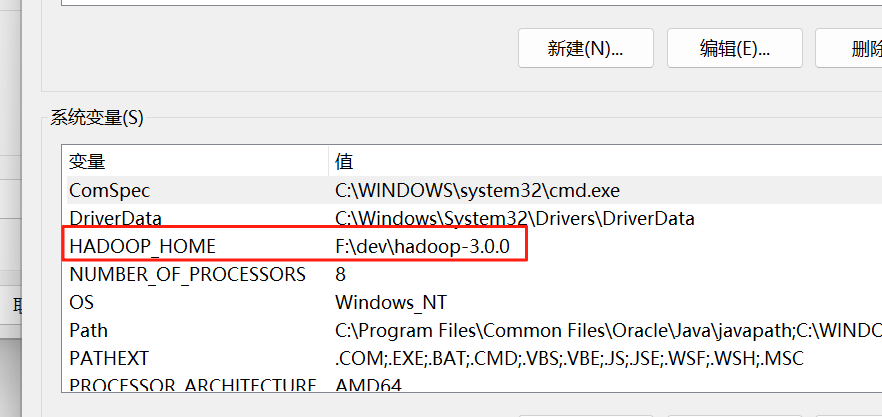

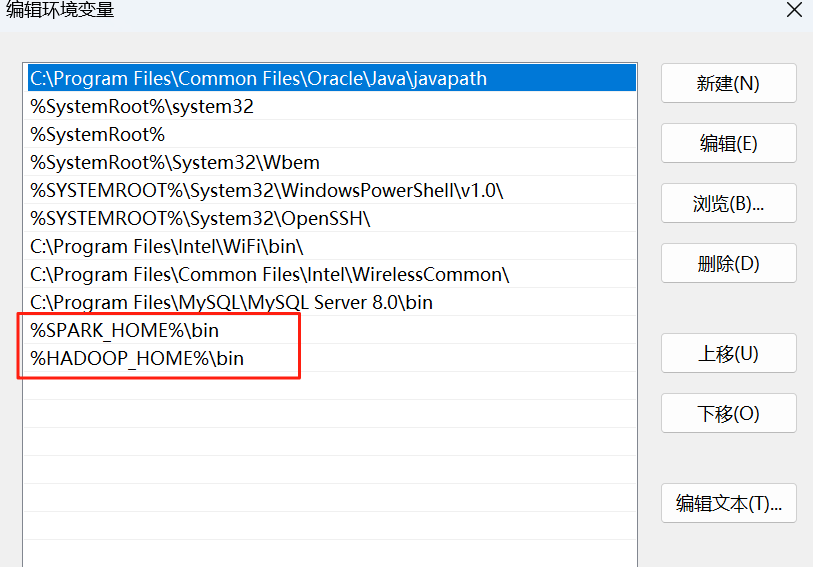

感觉应该是hadoop的问题 但是相关环境变量也有配置 (如三四五) 有没有哪个人可以指点一下迷津 真的不知道要怎么搞了😭😭

最近在学pyspark 在使用map算子(如图一)的时候 一直报错꒰>﹏< ꒱ (错误类型如图二)

感觉应该是hadoop的问题 但是相关环境变量也有配置 (如三四五) 有没有哪个人可以指点一下迷津 真的不知道要怎么搞了😭😭

阿里嘎多学长整理AIGC生成,因移动端显示问题导致当前答案未能完全显示,请使用PC端查看更加详细的解答过程

PyCharm中调用map函数报错,可能是Hadoop相关的问题。以下是一些可能的解决方案:

HADOOP_HOME、HADOOP_MAPRED_HOME、HADOOP_COMMON_HOME等。spark-defaults.conf,确保spark.hadoop.fs.hdfs.impl设置为org.apache.hadoop.hdfs.DFSClient。idea.properties,确保hadoop.home设置为Hadoop的安装目录。如果以上解决方案都不能解决问题,可以尝试以下命令:

import os

os.environ['HADOOP_HOME'] = '/path/to/hadoop'

os.environ['HADOOP_MAPRED_HOME'] = '/path/to/hadoop/mapred'

os.environ['HADOOP_COMMON_HOME'] = '/path/to/hadoop/common'

将Hadoop的安装目录替换为实际路径。

如果问题仍然存在,可以提供更多的错误信息和配置文件内容,以便更好地帮助解决问题。