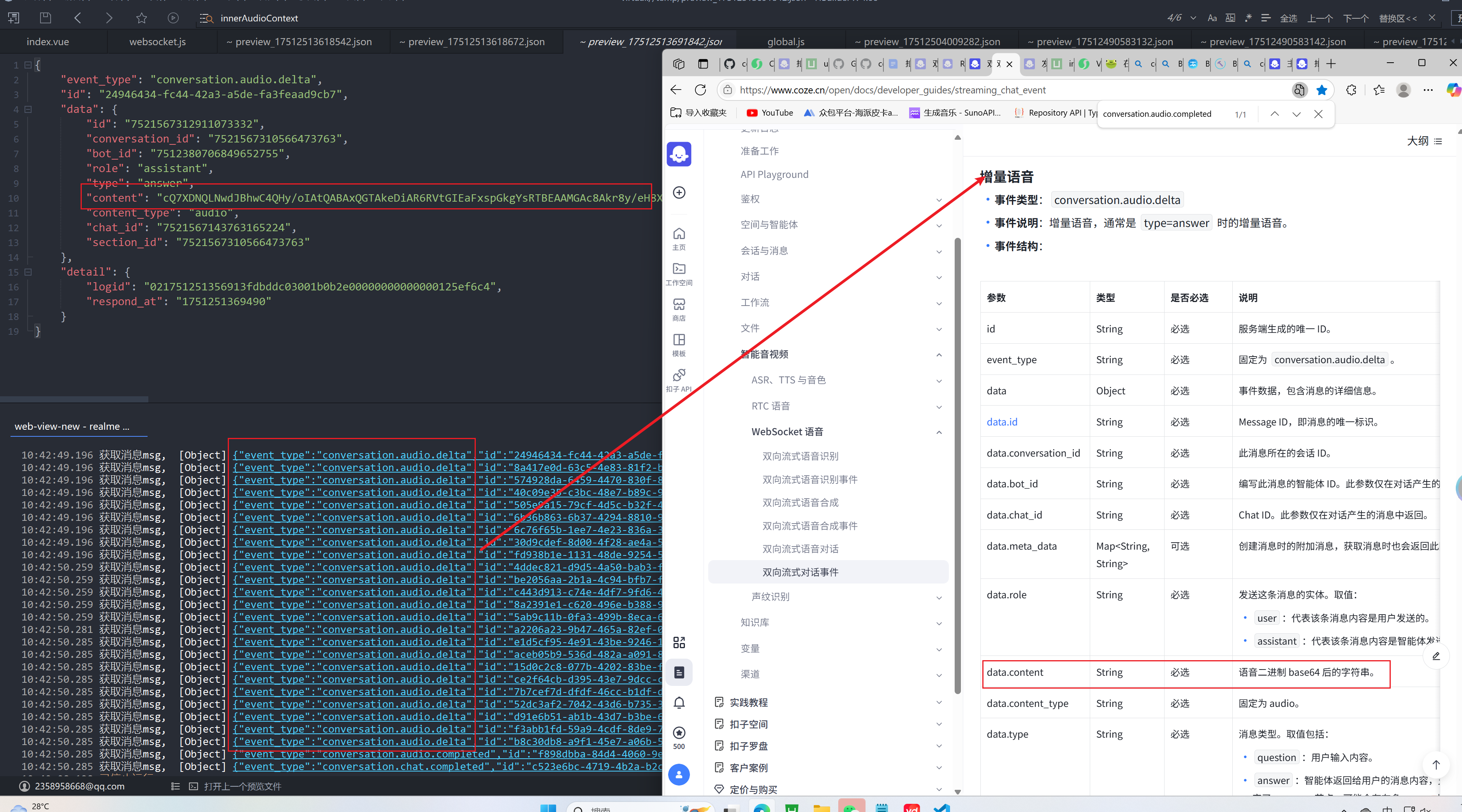

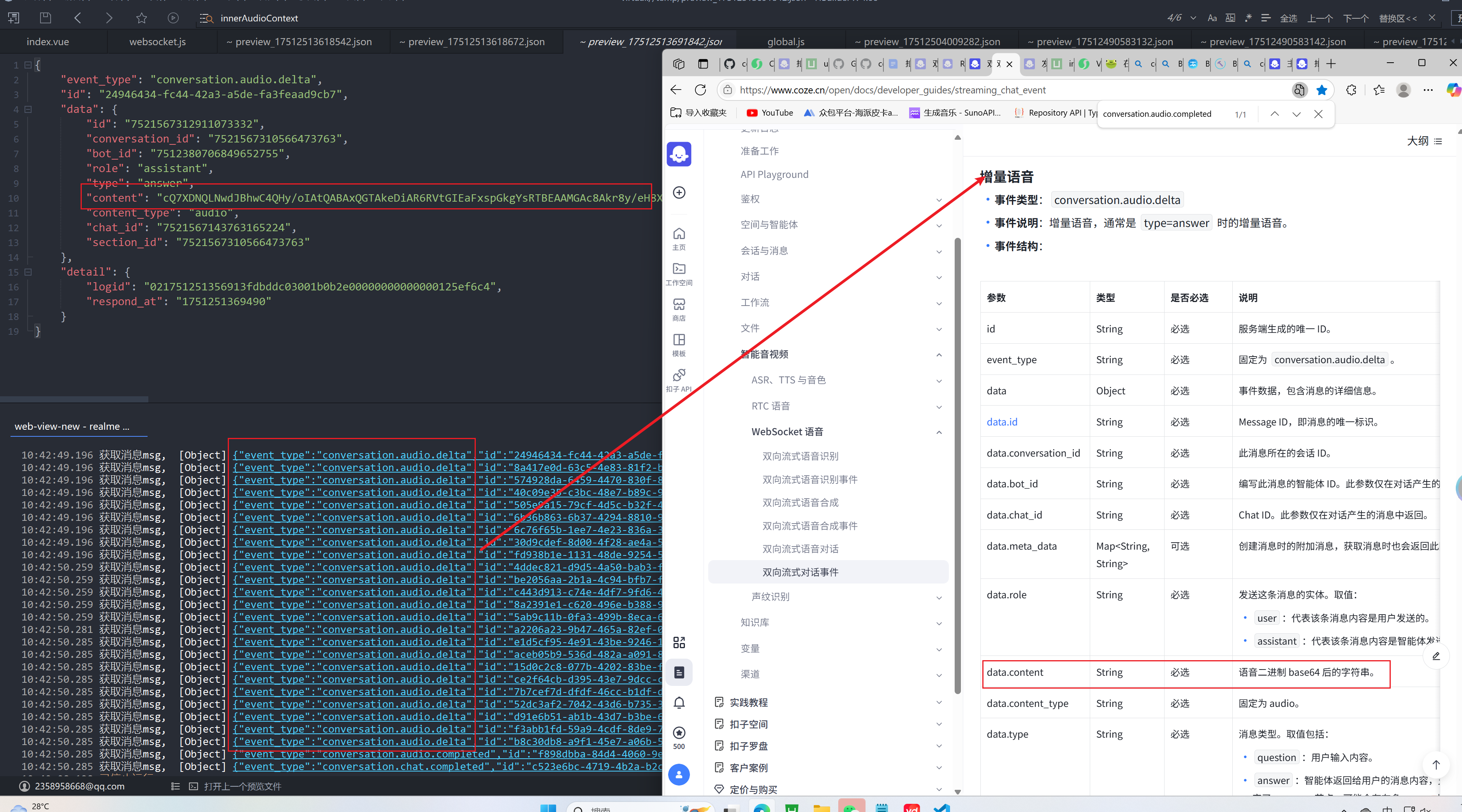

想问下有没有人知道COZE的这个WebSocket语音的双向流式对话事件的增量语音 返回的语音二进制 base64 后的字符串怎么处理才能在app端播放

想问下有没有人知道COZE的这个WebSocket语音的双向流式对话事件的增量语音 返回的语音二进制 base64 后的字符串怎么处理才能在app端播放

上午好☀️☀️☀️️

本答案参考通义千问

在使用 COZE 的 WebSocket 语音双向流式对话事件 进行增量语音处理时,你可能会接收到语音二进制数据的 Base64 字符串。为了在 App 端播放这些音频数据,你需要将 Base64 字符串转换为可播放的音频格式(如 WAV、MP3),并将其传递给设备的音频播放器。

确保你从 COZE WebSocket 接收到的数据是 Base64 编码的语音数据。通常格式如下:

{

"event": "audio",

"data": "base64_string"

}

在 App 端(如 Android/iOS/前端)需要将 Base64 字符串转换为二进制数据。

const base64String = "your_base64_audio_data";

const byteCharacters = atob(base64String);

const byteNumbers = new Array(byteCharacters.length);

for (let i = 0; i < byteCharacters.length; i++) {

byteNumbers[i] = byteCharacters.charCodeAt(i);

}

const byteArray = new Uint8Array(byteNumbers);

val base64Data = "your_base64_audio_data"

val decodedBytes = Base64.decode(base64Data, Base64.DEFAULT)

if let data = Data(base64Encoded: base64String) {

// 使用 data 播放

}

COZE 返回的音频数据可能是以下格式之一:

注意: 如果是压缩格式(如 MP3、OPUS),你需要使用对应的解码器进行解码;如果是未压缩的 PCM 格式,可以直接播放。

根据音频格式选择播放方式。

你可以将 byteArray 写入临时文件,然后通过系统音频播放器播放。

const audioBlob = new Blob([byteArray], { type: 'audio/wav' });

const audioUrl = URL.createObjectURL(audioBlob);

const audio = new Audio(audioUrl);

audio.play();

val audioFile = File.createTempFile("audio", ".wav")

audioFile.writeBytes(decodedBytes)

val mediaPlayer = MediaPlayer()

mediaPlayer.setDataSource(audioFile.absolutePath)

mediaPlayer.prepare()

mediaPlayer.start()

do {

let audioPlayer = try AVAudioPlayer(data: data)

audioPlayer.play()

} catch {

print("播放失败: $error)")

}

由于是流式传输,每次收到部分音频数据后,都需要追加到已有的音频缓冲区中,并实时播放。

buffer = b''

while True:

data = receive_from_websocket()

buffer += base64_decode(data)

play(buffer)

注意:流式播放可能需要更复杂的音频缓冲机制(如使用 Web Audio API、AudioQueue、AudioUnit 等)来避免卡顿。

| 问题 | 解决方案 | |------|----------| | 音频无法播放 | 检查 Base64 是否正确解码,确认音频格式是否匹配 | | 音频有杂音 | 可能是采样率不一致,检查音频编码参数 | | 流式播放卡顿 | 使用缓冲队列或异步播放机制 |

如果你提供具体的平台(如 Android、iOS、Web)和语言(如 Java、Swift、JavaScript),我可以为你提供更详细的代码示例。