一杯年华@编程空间帮您解答,本答案结合 ChatGPT4.0和DeepSeek整理

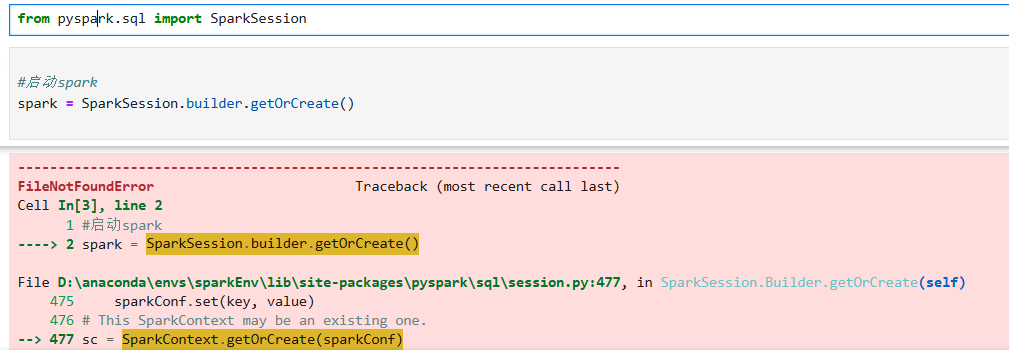

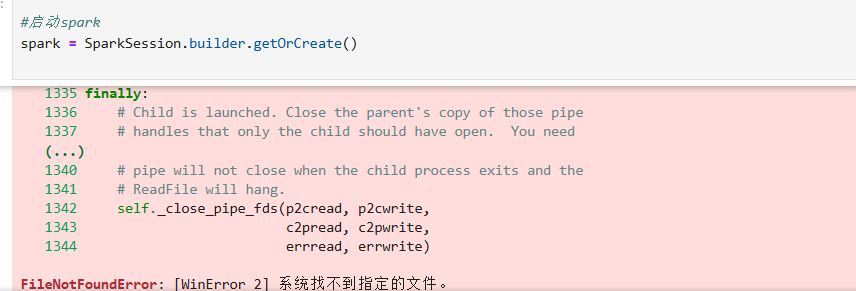

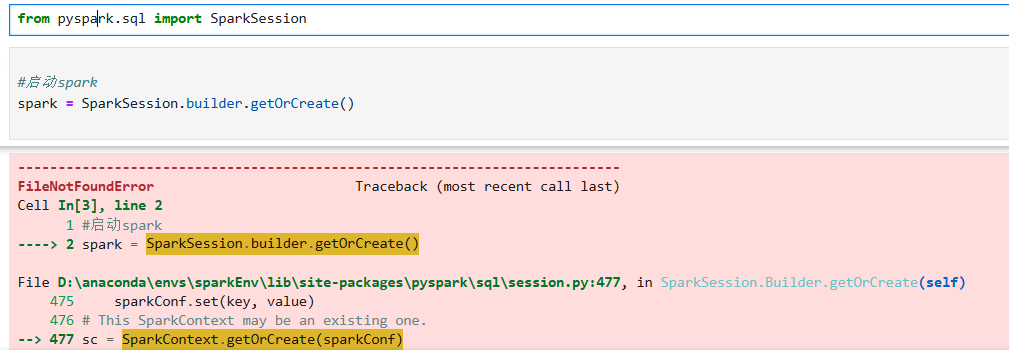

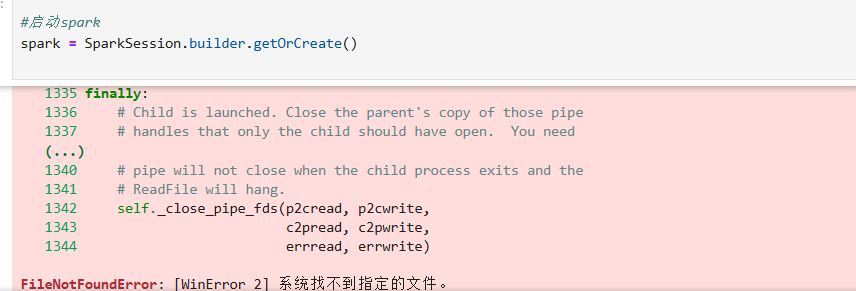

我曾经遇到过类似的问题,当时也是在Jupyter Notebook中使用PySpark时出现了“FileNotFoundError: [WinError 2] 系统找不到指定的文件”,经过排查发现主要是Spark相关环境配置或文件路径的问题,结合你的情况,我可以提供以下几种解决方案:

解决方案一:检查并配置Spark环境变量

- 首先,确认你已经正确安装了Spark,并且安装路径中没有空格或特殊字符(比如“#”“&”等),建议将Spark安装在简单路径下,例如“C:\spark”。

- 然后,配置系统环境变量:右键“此电脑”→“属性”→“高级系统设置”→“环境变量”,在系统变量中新增“SPARK_HOME”,值为你的Spark安装路径(如“C:\spark”)。

- 接着,在系统变量的“Path”中添加“%SPARK_HOME%\bin”和“%SPARK_HOME%\sbin”,这样系统就能找到Spark相关的可执行文件了。

- 最后,重启Jupyter Notebook,重新运行代码尝试解决问题。

解决方案二:检查虚拟环境中PySpark的安装

- 你使用了Anaconda的虚拟环境“sparkEnv”,可能是该环境中PySpark的安装存在问题。

- 打开命令提示符,激活虚拟环境:在命令行中输入“conda activate sparkEnv”并回车。

- 卸载当前的PySpark:输入“pip uninstall pyspark”,按提示确认卸载。

- 重新安装PySpark:输入“pip install pyspark”,确保安装过程没有报错。

- 安装完成后,重启Jupyter Notebook,再次运行代码。

最优方案:检查并配置Spark环境变量

这个方案是最优的,因为从报错信息来看,问题很可能是系统无法找到Spark的可执行文件,而配置环境变量能直接让系统识别到Spark的安装路径和相关文件。很多时候,这类“找不到指定文件”的错误都是由于环境变量未正确配置导致的,通过上述步骤配置好Spark的环境变量后,系统就能顺利找到所需的文件,从而解决该错误。

如果按照上述方法仍未解决问题,你可以提供更详细的报错日志,我会继续帮你分析。请楼主采纳,如有问题请继续留言。