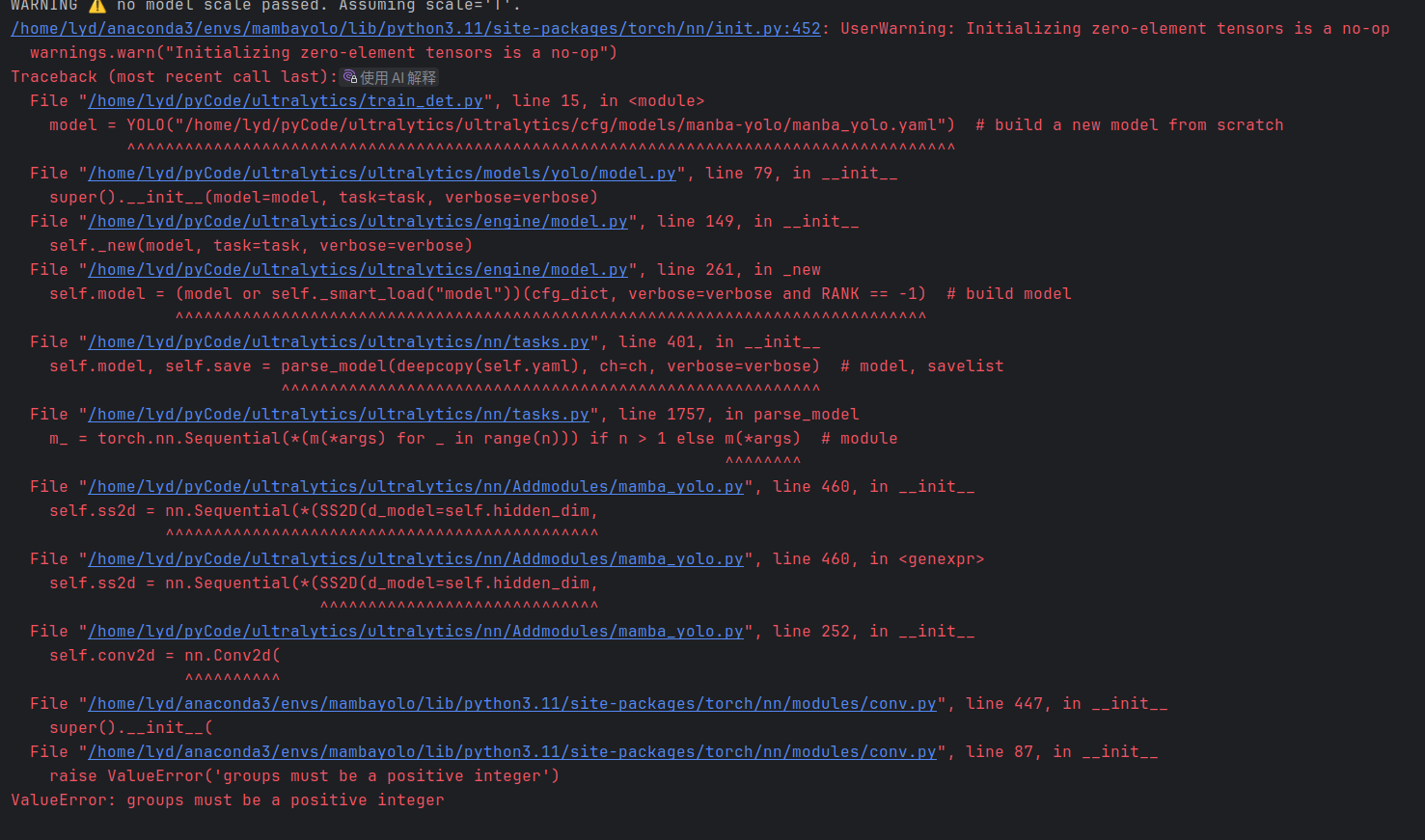

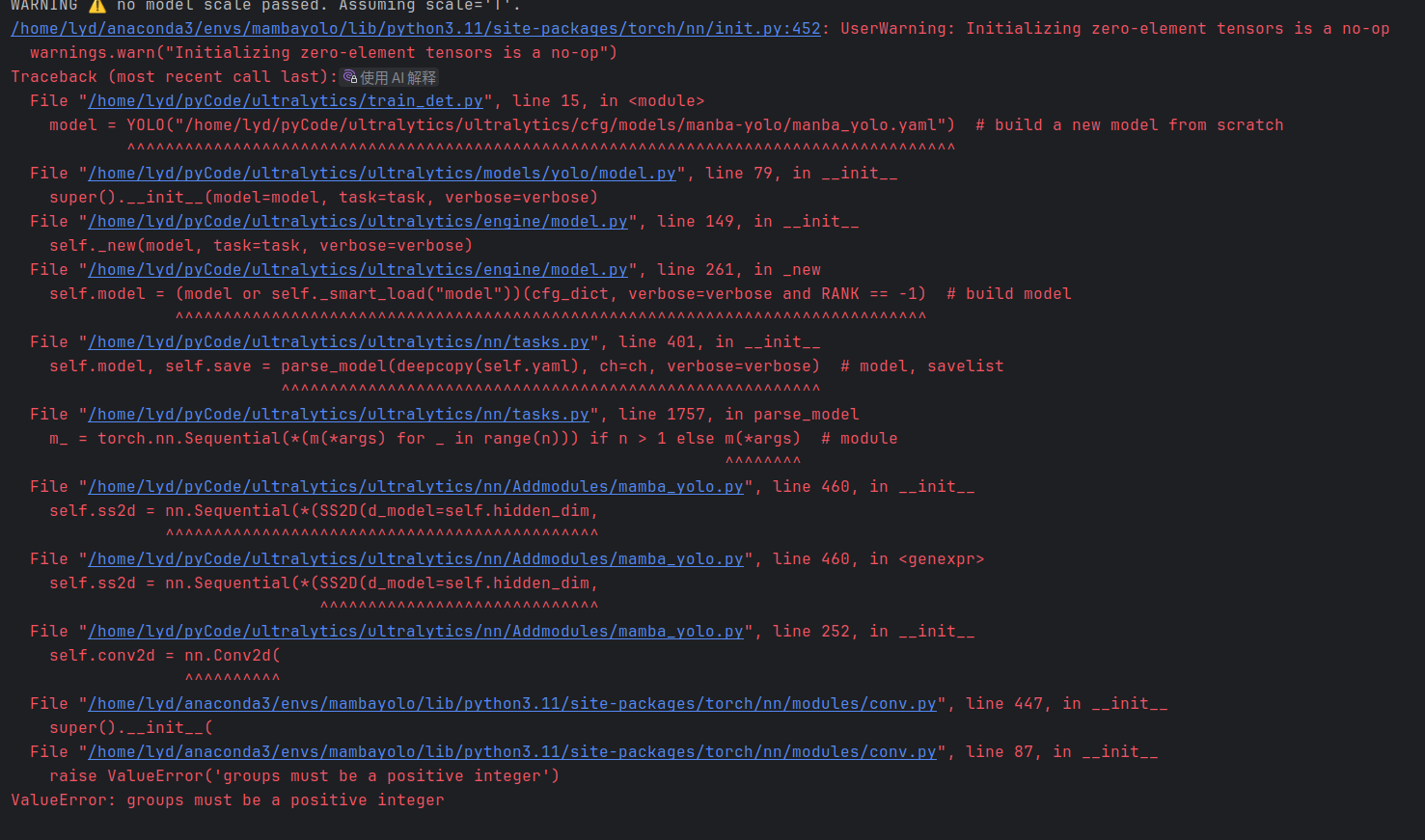

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

根據教程改,出現問題。mamba放入detr,說是con2d的group不對

下午好🌅🌅🌅

本答案参考通义千问

你提到的问题是将 Mamba 模型集成到 DETR 中时,出现了 Conv2d 的 groups 参数不匹配的错误。这个问题通常出现在模型结构设计上,尤其是当 Mamba 被用作一个模块插入到 DETR 的编码器(如 Transformer 编码器)中时。

在 PyTorch 中,torch.nn.Conv2d 的 groups 参数决定了输入通道如何被分割为多个组进行卷积操作。例如:

conv = nn.Conv2d(in_channels=64, out_channels=64, kernel_size=3, groups=1)

如果 groups 设置为 in_channels,则会变成深度可分离卷积(depthwise convolution)。

在 DETR 中,通常使用的是标准的 Transformer 编码器,而 Mamba 是一种基于状态空间模型(SSM)的架构,其设计与传统的 CNN 或 Transformer 不同。因此,当你试图将 Mamba 模块直接替换或插入到 DETR 的某个部分(比如特征提取层、注意力机制等),可能会出现维度不一致或参数设置错误的问题。

确保 Mamba 模块的输入和输出维度与 DETR 的预期输入相匹配。例如:

(B, C, H, W),那么 Mamba 模块的输入也应是这个形状。重点: 如果你在 Mamba 模块中使用了

Conv2d层,必须确保groups参数与输入通道数匹配,否则会报错。

Conv2d,并调整 groups 参数如果你的 Mamba 模块中使用了类似如下代码:

self.conv = nn.Conv2d(in_channels=64, out_channels=64, kernel_size=3, groups=1)

但 DETR 预期的输入是 groups=64(即深度可分离卷积),那就会出错。

解决方法: 修改

groups参数为in_channels,或者根据 DETR 的输入调整你的 Mamba 模块。

self.conv = nn.Conv2d(in_channels=64, out_channels=64, kernel_size=3, groups=64)

注意: 这个参数需要根据实际输入通道数动态设置,不能硬编码。

假设你有一个 Mamba 模块如下:

class MambaBlock(nn.Module):

def __init__(self, in_channels):

super().__init__()

self.conv = nn.Conv2d(in_channels, in_channels, kernel_size=3, groups=in_channels)

def forward(self, x):

return self.conv(x)

如果 DETR 的特征图是 (B, C, H, W),你可以这样使用它:

mamba_block = MambaBlock(in_channels=256) # 假设特征图通道是 256

x = torch.randn(1, 256, 32, 32) # B, C, H, W

out = mamba_block(x)

print(out.shape) # 应该是 (1, 256, 30, 30)

如果你是想将 Mamba 替换掉 DETR 的编码器部分(比如 Transformer 编码器),你需要重新设计整个结构,确保:

groups 参数import torch

import torch.nn as nn

class MambaBlock(nn.Module):

def __init__(self, in_channels):

super().__init__()

self.conv = nn.Conv2d(

in_channels=in_channels,

out_channels=in_channels,

kernel_size=3,

padding=1,

groups=in_channels # 深度可分离卷积

)

self.norm = nn.BatchNorm2d(in_channels)

def forward(self, x):

# x: [B, C, H, W]

x = self.conv(x)

x = self.norm(x)

return x

说明: 这个模块可以作为 DETR 编码器中的一个组件,前提是输入通道数与 DETR 的特征图一致。

| 步骤 | 内容 |

|------|------|

| 1 | 确认 Mamba 模块的输入输出形状与 DETR 兼容 |

| 2 | 检查 Conv2d 的 groups 参数是否正确 |

| 3 | 修改 groups=in_channels 来适配 DETR 的输入 |

| 4 | 重新设计 Mamba 模块,使其适合 DETR 的结构 |

如果你愿意提供具体的代码片段或错误信息,我可以进一步帮你调试!