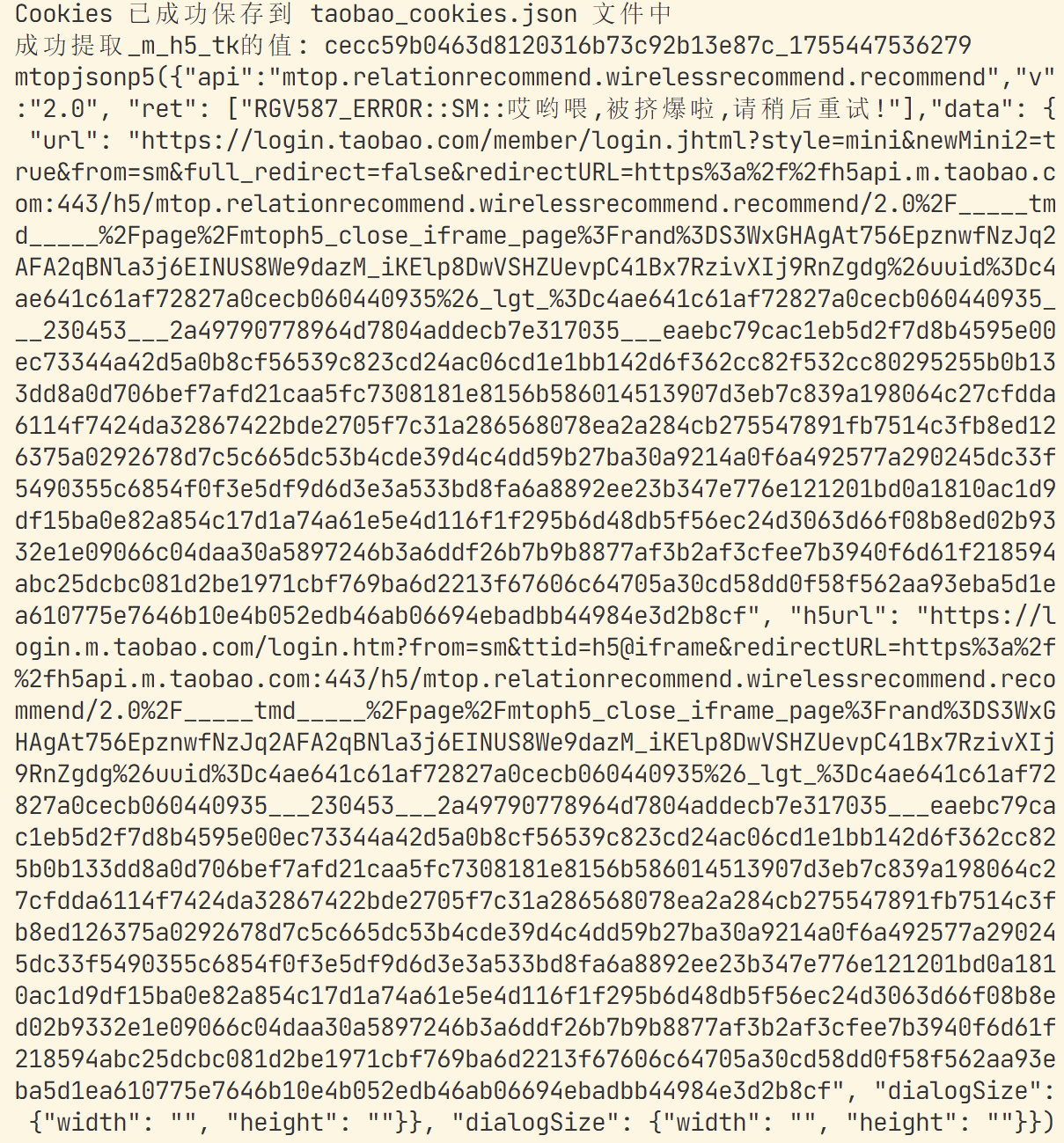

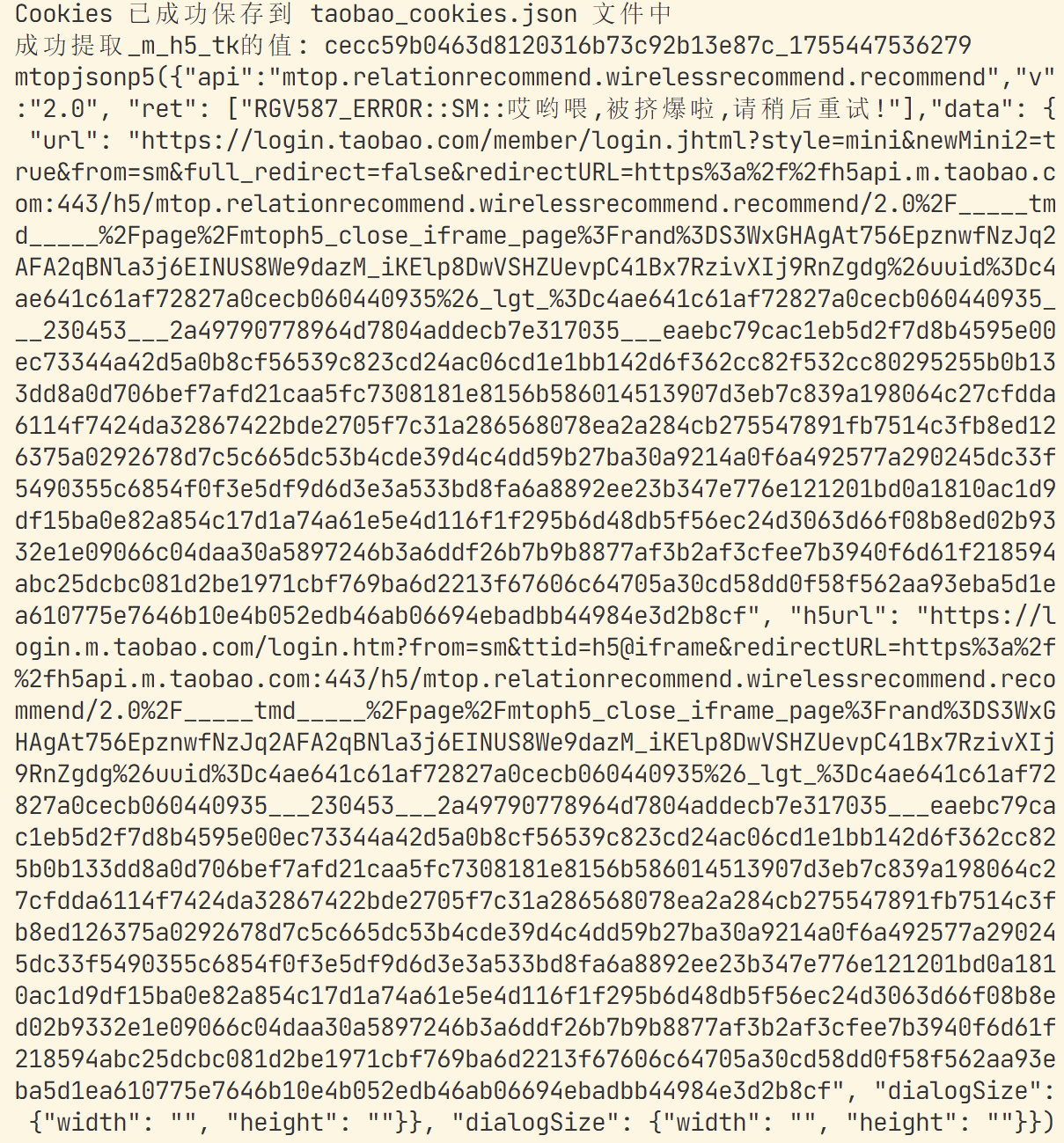

最近在使用爬虫爬取淘宝上的一些信息,每次模拟完sign后得到的json数据都是重定向到一个登录网站,请求高人帮忙指点一下

最近在使用爬虫爬取淘宝上的一些信息,每次模拟完sign后得到的json数据都是重定向到一个登录网站,请求高人帮忙指点一下

晚上好🌙🌙🌙

本答案参考通义千问

你提到在使用爬虫爬取淘宝信息时,模拟sign后返回的网址会重定向到登录页面,这说明你的请求虽然通过了签名验证(sign),但可能还存在其他反爬机制或身份验证机制未被正确处理。下面我将详细分析问题并提供解决方案。

Sign 模拟不完整或错误

sign 的生成方式与实际接口不一致,例如加密算法、参数顺序、时间戳等。sign,如结合 timestamp 和 session 或 token。缺少 Cookie 或 Session 验证

sign 正确,如果未携带有效的 Cookie 或 Session,服务器仍会认为你是未登录用户,从而跳转到登录页。IP 被封或频率过高

User-Agent 不匹配

Referer 校验

Referer 必须为特定域名,否则视为非法请求。动态 Token 或 CAPTCHA

sign 参数。示例代码(Python)

import hashlib

def generate_sign(params):

# 示例:MD5 + 时间戳

timestamp = str(int(time.time()))

sign_str = params + timestamp

sign = hashlib.md5(sign_str.encode()).hexdigest()

return sign

注意:实际 sign 可能更复杂,建议用抓包工具分析真实请求。

示例代码(使用 requests)

import requests

# 登录后获取 Cookie

session = requests.Session()

login_url = 'https://login.taobao.com'

session.post(login_url, data={'username': 'your_user', 'password': 'your_pass'})

# 使用 session 发送请求

response = session.get('https://api.taobao.com/your_api')

print(response.text)

示例代码

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/90.0.4430.93 Safari/537.36'

}

示例代码

headers = {

'Referer': 'https://www.taobao.com/'

}

示例代码(使用代理)

proxies = {

'http': 'http://10.10.1.10:3128',

'https': 'http://10.10.1.10:1080',

}

response = requests.get(url, headers=headers, proxies=proxies)

| 问题点 | 解决方案 | |--------|----------| | Sign 错误 | 分析真实请求,确保 sign 生成逻辑一致 | | 缺少 Cookie | 使用 Session 或手动获取 Cookie | | User-Agent 不匹配 | 设置浏览器 User-Agent | | Referer 校验 | 设置正确的 Referer | | IP 被封 | 使用代理 IP,控制请求频率 | | CAPTCHA | 手动处理或使用 OCR 服务 |

如果你愿意提供具体的请求 URL 或抓包数据,我可以进一步帮你分析具体 sign 的生成方式。希望以上内容对你有帮助!