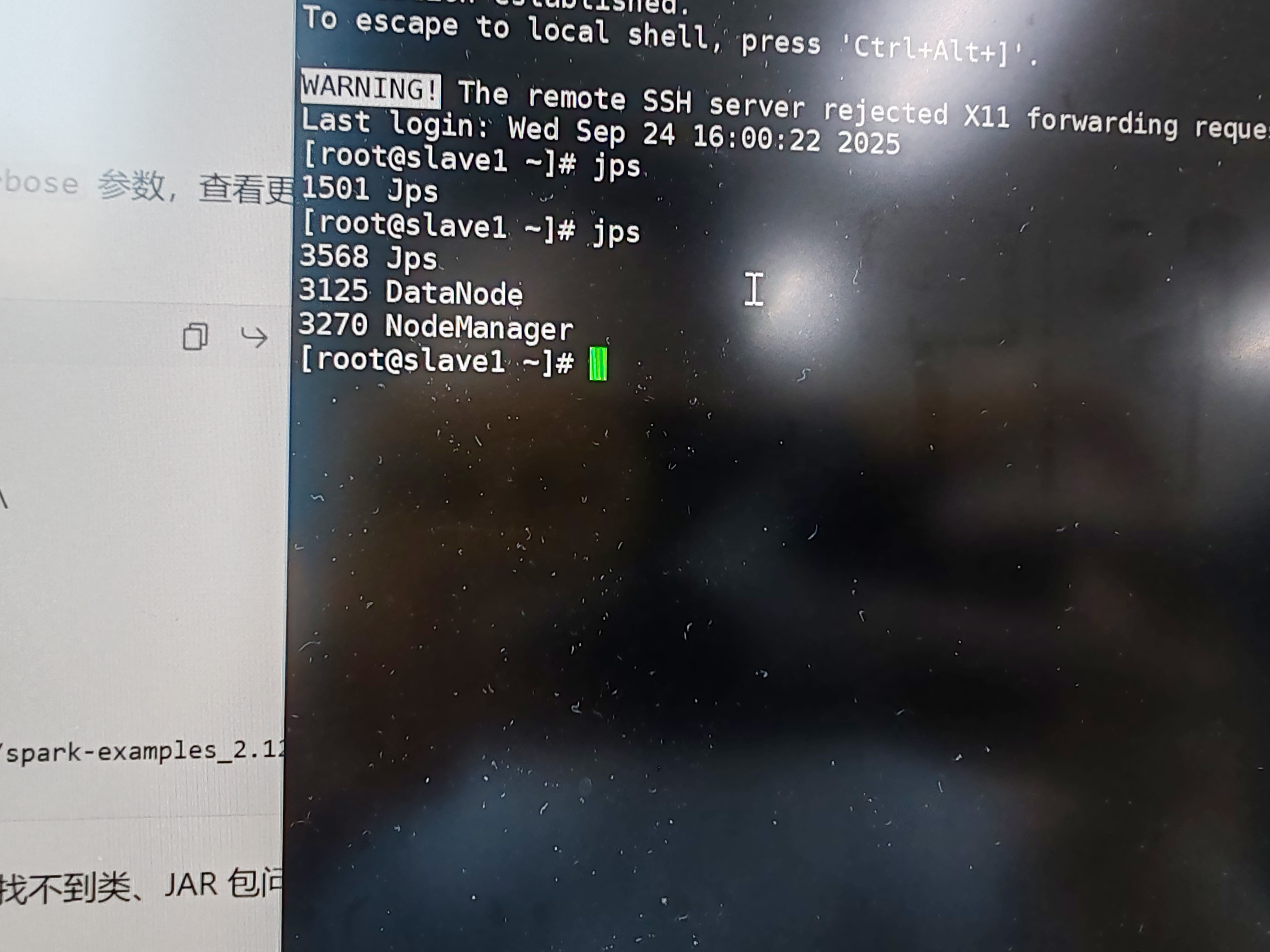

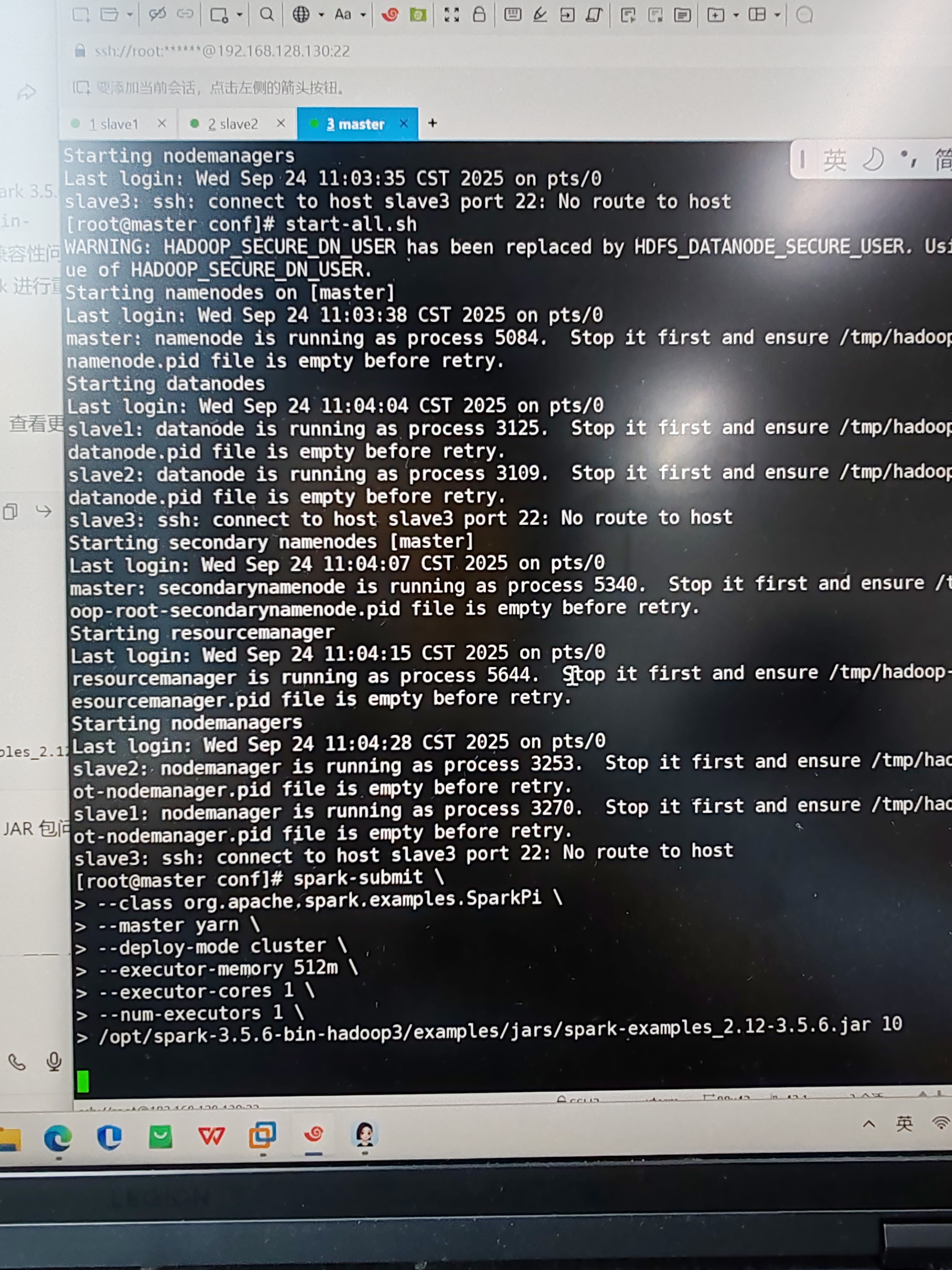

到这一步卡了很久,一直不动,jPS的各内容也有,怎么解决,网络连通性,spark也有,内存是4g,有两个从节点

下午好🌅🌅🌅

本答案参考通义千问

在Spark集群中提交任务后卡住不动,可能是由多种原因引起的。根据你提供的信息:jps的各内容也有,网络连通性正常,Spark已安装,内存为4G,有两个从节点,我们可以逐步排查问题并提供解决方案。

资源分配不足

Driver或Executor未正常启动

jps显示有进程,但可能Driver或Executor没有成功启动或处于等待状态。网络通信问题

配置错误

spark-submit参数配置不正确(如--master、--executor-memory等)。日志信息缺失

定位日志路径:

# 查看Spark日志目录(默认)

/tmp/spark-<user>/logs/

查看Driver和Executor日志:

tail -f /tmp/spark-<user>/logs/spark-driver-*.log

tail -f /tmp/spark-<user>/logs/spark-execute-*.log

重点关注内容:

ERROR 或 WARN 级别的日志Connection refused、No route to host、Timeout 等提示使用 jps 命令查看是否确实有以下进程:

DriverMain(Driver进程)ExecutorRunner(Executor进程)jps

1234 DriverMain

5678 ExecutorRunner

如果没有看到这些进程,说明任务可能没有成功提交或被阻塞。

查看Spark配置:

spark-submit --conf spark.driver.memory=2g --conf spark.executor.memory=1g your_app.py

确保内存合理分配:

spark-submit \

--master yarn \

--deploy-mode cluster \

--driver-memory 1g \

--executor-memory 1g \

--num-executors 2 \

your_app.py

验证各节点之间的通信:

ping <master-ip>

ping <worker1-ip>

ping <worker2-ip>

检查端口开放情况:

telnet 或 nc 测试端口:telnet <master-ip> 7077

telnet <worker1-ip> 7077

如果失败,检查防火墙设置:

sudo ufw status

sudo iptables -L

如果使用的是YARN模式,可以访问 YARN ResourceManager 的 Web UI:

http://<rm-host>:8088在页面上查看:

查看Spark日志文件

确认Driver和Executor是否启动

jps 检查进程是否存在调整Spark资源配置

spark-submit \

--master yarn \

--deploy-mode cluster \

--driver-memory 1g \

--executor-memory 1g \

--num-executors 2 \

your_app.py

检查网络连通性

查看YARN ResourceManager界面

spark-submit \

--master yarn \

--deploy-mode cluster \

--driver-memory 1g \

--executor-memory 1g \

--num-executors 2 \

--conf spark.app.name="MyApp" \

--conf spark.logConf=true \

your_app.py

| 问题 | 解决方案 |

|------|----------|

| 日志未查看 | 检查Spark日志文件,定位错误 |

| Driver/Executor未启动 | 使用 jps 检查进程,排查任务提交问题 |

| 内存不足 | 合理分配Driver和Executor内存 |

| 网络不通 | 检查ping和端口连通性,关闭防火墙 |

| YARN资源不足 | 查看ResourceManager UI,优化资源分配 |

如果你能提供具体的日志内容或错误信息,我可以进一步帮你定位问题。